Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vi introduserer Liquid Nanos ⚛️ – en ny familie av ekstremt små oppgavespesifikke modeller som leverer ytelse i GPT-4o-klassen mens de kjører direkte på telefoner, bærbare datamaskiner, biler, innebygde enheter og GPUer med lavest ventetid og raskeste generasjonshastighet.

> modellstørrelse: 350M til 2.6B

> bygget på LFM2, vår v2-effektive modellarkitektur

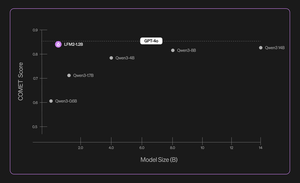

> presterer konkurransedyktig med modeller som er opptil hundrevis av ganger større

> muliggjør kjerneagentoppgaver: presis datautvinning, flerspråklig oversettelse, verktøykall, matematikk og RAG. 1/n

Vi bruker en kombinasjon av metoder for automatiserte evalueringer, kunnskapsdestillasjon, RL og modellsammenslåing for å iterativt forbedre ytelsen til en modell på en gitt oppgave. De resulterende modellene, selv om de er små, presterer konkurransedyktig i forhold til vesentlig større modeller. 2/n

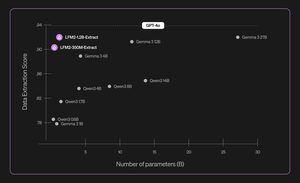

For eksempel er LFM2-350M-Extract og LFM2-1.2B-Extract designet for å trekke ut viktig informasjon fra et bredt utvalg av ustrukturerte dokumenter (for eksempel artikler, transkripsjoner eller rapporter) til strukturerte utdata som JSON, XML eller YAML. De er kompatible med engelske, arabiske, kinesiske, franske, tyske, japanske, koreanske, portugisiske og spanske inndata.

Våre datautvinningsmodeller gir et betydelig løft i validitet, nøyaktighet og trofasthet. For eksempel kan LFM2-1.2B-Extract sende ut komplekse objekter på forskjellige språk på et nivå høyere enn Gemma 3 27B, en modell 22.5 ganger størrelsen og nærmer seg ytelsen til GPT-4o. 3/n

Vi kunngjør seks oppgavespesifikke Nano-er i vår første utgivelse:

> LFM2-Extract – En 350M og 1.2B flerspråklig modell for datautvinning fra ustrukturert tekst, som å gjøre faktura-e-poster om til JSON-objekter.

> LFM2-350M-ENJP-MT – EN 350M-modell for toveis engelsk ↔ japansk oversettelse.

> LFM2-1.2B-RAG – En 1.2B-modell optimalisert for svar på spørsmål i lang kontekst i RAG-rørledninger.

> LFM2-1.2B-Tool – En 1.2B-modell bygget for funksjonsanrop og agentverktøybruk.

> LFM2-350M-Math – En 350M resonneringsmodell for å løse matematiske problemer.

4/n

"Jeg synes det er veldig imponerende at Liquids nye teknikk før og etter trening gjør det mulig for deres raske og små LLM-er å yte på nivå med grensemodeller som GPT-4o, som er størrelsesordener større, på spesialiserte oppgaver," sa Mikhail Parakhin (@MParakhin), CTO, Shopify. «Liquid hever samtidig standarden for både ytelse og hastighet i fundamentmodeller, og presser seg utover toppmoderne. Derfor er vi glade for å bruke modellene deres på tvers av Shopifys plattformer og tjenester." 5/n

"Deloitte er begeistret for muligheten til å samarbeide med Liquid AI og deres nye Nanos-modell, som har potensial til å drive ytelse som kan sammenlignes med større modeller til en lavere kostnad," sa Ranjit Bawa (@ronbawa), Chief Strategy and Technology Officer, Deloitte US 6/n

"Liquids Nanos representerer et kraftig vendepunkt for AI-PC-er, og leverer ytelse på frontlinjenivå i en kompakt, energieffektiv form. Hos AMD deler vi dette fokuset på ytelse-per-watt-ledelse og ser på intelligens på enheten som nøkkelen til å skalere AI bredt og bærekraftig», sa Papermaster (@mpaper2000), CTO og EVP, AMD. 7/n

284,66K

Topp

Rangering

Favoritter