Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

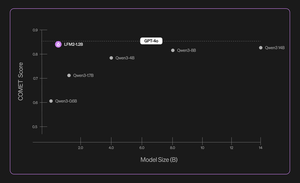

Presentamos Liquid Nanos ⚛️, una nueva familia de modelos extremadamente pequeños para tareas específicas que ofrecen un rendimiento de clase GPT-4o mientras se ejecutan directamente en teléfonos, computadoras portátiles, automóviles, dispositivos integrados y GPU con la latencia más baja y la velocidad de generación más rápida.

> tamaño del modelo: 350M a 2.6B

> basa en LFM2, nuestra arquitectura de modelo eficiente v2

> rendimiento competitivo con modelos hasta cientos de veces más grandes

> habilitar tareas agenciales básicas: extracción precisa de datos, traducción multilingüe, llamada a herramientas, matemáticas y RAG. 1/n

Utilizamos una combinación de métodos para evaluaciones automatizadas, destilación de conocimiento, RL y fusión de modelos para mejorar iterativamente el rendimiento de un modelo en una tarea determinada. Los modelos resultantes, aunque pequeños, funcionan de manera competitiva con modelos sustancialmente más grandes. 2/n

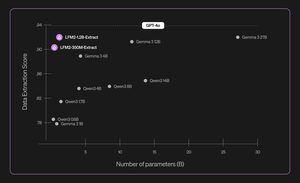

Por ejemplo, LFM2-350M-Extract y LFM2-1.2B-Extract están diseñados para extraer información importante de una amplia variedad de documentos no estructurados (como artículos, transcripciones o informes) en salidas estructuradas como JSON, XML o YAML. Son compatibles con entradas en inglés, árabe, chino, francés, alemán, japonés, coreano, portugués y español.

Nuestros modelos de extracción de datos proporcionan un aumento significativo en la validez, precisión y fidelidad. Por ejemplo, LFM2-1.2B-Extract puede generar objetos complejos en diferentes idiomas a un nivel superior al de Gemma 3 27B, un modelo 22,5 veces más grande que su tamaño y cercano a GPT-4o. 3/n

Anunciamos seis Nanos específicos de tareas en nuestra versión inicial:

> LFM2-Extract: modelos multilingües de 350 millones y 1,2 mil millones para la extracción de datos de texto no estructurado, como convertir correos electrónicos de facturas en objetos JSON.

> LFM2-350M-ENJP-MT: un modelo 350M para traducción bidireccional del inglés ↔ al japonés.

> LFM2-1.2B-RAG: un modelo 1.2B optimizado para la respuesta a preguntas de contexto largo en canalizaciones RAG.

> LFM2-1.2B-Tool: un modelo 1.2B creado para la llamada a funciones y el uso de herramientas agenciales.

> LFM2-350M-Math – Un modelo de razonamiento de 350M para resolver problemas matemáticos.

4/n

"Me parece muy impresionante que la novedosa técnica de pre-entrenamiento y post-entrenamiento de Liquid permita que sus LLM rápidos y pequeños se desempeñen a la par con modelos de frontera como GPT-4o, que es órdenes de magnitud más grande, en tareas especializadas", dijo Mikhail Parakhin (@MParakhin), CTO de Shopify. "Liquid está elevando simultáneamente el listón del rendimiento y la velocidad en los modelos de base, yendo más allá del estado del arte. Es por eso que estamos entusiasmados de utilizar sus modelos en las plataformas y servicios de Shopify". 5/n

"Deloitte está entusiasmado con la oportunidad de colaborar con Liquid AI y su nuevo modelo Nanos, que tiene el potencial de impulsar un rendimiento comparable al de los modelos más grandes a un costo menor", dijo Ranjit Bawa (@ronbawa), director de estrategia y tecnología de Deloitte U.S. 6/n

"Nanos de Liquid representa un poderoso punto de inflexión para las PC de IA, ya que ofrece un rendimiento de nivel de frontera en una forma compacta y energéticamente eficiente. En AMD, compartimos este enfoque en el liderazgo de rendimiento por vatio y vemos la inteligencia en el dispositivo como clave para escalar la IA de manera amplia y sostenible", dijo Mark Papermaster (@mpaper2000), CTO y EVP de AMD. 7/n

284.61K

Populares

Ranking

Favoritas