トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Liquid Nanos ⚛️ のご紹介は、携帯電話、ラップトップ、自動車、組み込みデバイス、GPU 上で最小の遅延と最速の生成速度で直接実行しながら、GPT-4o クラスのパフォーマンスを提供する、非常に小さなタスク固有のモデルの新しいファミリーです。

>モデルサイズ:350M〜2.6B

> v2 の効率的なモデル アーキテクチャである LFM2 に基づいて構築されています

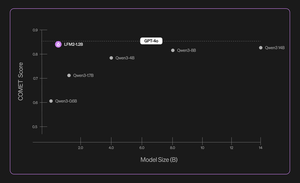

>最大数百倍のモデルで競争力のあるパフォーマンスを発揮します

>、正確なデータ抽出、多言語翻訳、ツール呼び出し、数学、RAG などのコア エージェント タスクを可能にします。1/n

自動評価、知識蒸留、RL、モデルマージの手法を組み合わせて使用し、特定のタスクに対するモデルのパフォーマンスを反復的に向上させます。結果として得られるモデルは、小さいものの、かなり大きなモデルと競合するパフォーマンスを発揮します。2/n

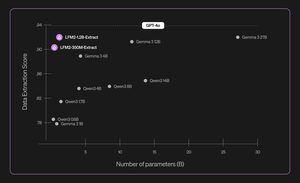

たとえば、LFM2-350M-Extract と LFM2-1.2B-Extract は、さまざまな非構造化ドキュメント (記事、トランスクリプト、レポートなど) から重要な情報を JSON、XML、YAML などの構造化出力に抽出するように設計されています。英語、アラビア語、中国語、フランス語、ドイツ語、日本語、韓国語、ポルトガル語、スペイン語の入力と互換性があります。

当社のデータ抽出モデルは、有効性、正確性、忠実性を大幅に向上させます。たとえば、LFM2-1.2B-Extract は、Gemma 3 27B よりも高いレベルで複雑なオブジェクトをさまざまな言語で出力でき、モデルはそのサイズの 22.5 倍で、GPT-4o に近いパフォーマンスです。3/n

最初のリリースでは、6つのタスク固有のNanoを発表しました。

> LFM2-Extract – 請求書の電子メールを JSON オブジェクトに変換するなど、非構造化テキストからデータを抽出するための 350M および 1.2B 多言語モデル。

> LFM2-350M-ENJP-MT – 双方向英語↔日本語翻訳用の350Mモデル。

> LFM2-1.2B-RAG – RAG パイプラインでのロング コンテキストの質問応答用に最適化された 1.2B モデル。

> LFM2-1.2B-Tool – 関数呼び出しとエージェントツールの使用用に構築された1.2Bモデル。

> LFM2-350M-Math – 数学的問題を解決するための 350M 推論モデル。

4/n

「Liquid の斬新な事前トレーニングおよび事後トレーニング技術により、高速で小型の LLM が、特殊なタスクにおいて桁違いに大きい GPT-4o などのフロンティア モデルと同等のパフォーマンスを発揮できることは非常に印象的です」と Shopify の CTO である Mikhail Parakhin 氏 (@MParakhin) は述べています。「Liquidは、基礎モデルのパフォーマンスとスピードの両方の水準を同時に引き上げ、最先端技術を超えています。そのため、Shopify のプラットフォームとサービス全体で彼らのモデルを活用できることに興奮しています。」5月1日

「デロイトは、Liquid AIとその新しいNanosモデルと協力する機会に興奮しています。これは、より低コストで大型モデルに匹敵するパフォーマンスを推進できる可能性を秘めています」と、Deloitte US 6/nの最高戦略技術責任者であるRanjit Bawa(@ronbawa)は述べています

「LiquidのNanosは、AI PCの強力な転換点であり、コンパクトでエネルギー効率の高い形でフロンティアレベルのパフォーマンスを提供します。AMDでは、ワットあたりのパフォーマンスのリーダーシップに重点を置いており、オンデバイスインテリジェンスがAIを広範かつ持続的に拡張するための鍵であると考えています」と、AMDのCTO兼EVPであるMark Papermaster(@mpaper2000)は述べています。7月7日

44.27K

トップ

ランキング

お気に入り