Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Esittelyssä Liquid Nanos ⚛️ – uusi perhe erittäin pieniä tehtäväkohtaisia malleja, jotka tarjoavat GPT-4o-luokan suorituskyvyn toimiessaan suoraan puhelimissa, kannettavissa tietokoneissa, autoissa, sulautetuissa laitteissa ja GPU:issa pienimmällä latenssilla ja nopeimmalla sukupolven nopeudella.

> mallin koko: 350–2,6 miljardia

> rakennettu LFM2:lle, tehokkaalle v2-malliarkkitehtuurillemme

> suoriutua kilpailukykyisesti jopa satoja kertoja suuremmilla malleilla

> mahdollistavat agentin ydintehtävät: tarkan tietojen poimimisen, monikielisen kääntämisen, työkalukutsun, matematiikan ja RAG:n. 1/n

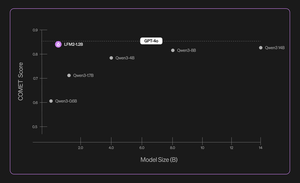

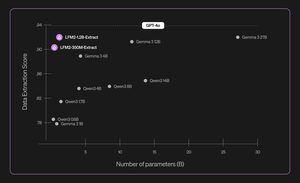

Käytämme menetelmien yhdistelmää automatisoituihin arviointeihin, tiedon tislaukseen, RL:ään ja mallien yhdistämiseen parantaaksemme iteratiivisesti mallin suorituskykyä tietyssä tehtävässä. Tuloksena olevat mallit, vaikka ne ovatkin pieniä, toimivat kilpailukykyisesti huomattavasti suurempiin malleihin verrattuna. 2/n

Esimerkiksi LFM2-350M-Extract ja LFM2-1.2B-Extract on suunniteltu poimimaan tärkeitä tietoja monista jäsentämättömistä asiakirjoista (kuten artikkeleista, transkriptioista tai raporteista) jäsenneltyihin tulosteisiin, kuten JSON, XML tai YAML. Ne ovat yhteensopivia englannin, arabian, kiinan, ranskan, saksan, japanin, korean, portugalin ja espanjan kanssa.

Tiedonkeruumallimme lisäävät merkittävästi validiteettia, tarkkuutta ja uskollisuutta. Esimerkiksi LFM2-1.2B-Extract voi tulostaa monimutkaisia objekteja eri kielillä korkeammalla tasolla kuin Gemma 3 27B, malli on 22,5 kertaa suurempi ja suorituskyky GPT-4o:n tasolla. 3/n

Julkistamme kuusi tehtäväkohtaista nanoa ensimmäisessä julkaisussamme:

> LFM2-Extract – 350M ja 1.2B monikieliset mallit tietojen poimimiseen jäsentämättömästä tekstistä, kuten laskusähköpostien muuttamiseen JSON-objekteiksi.

> LFM2-350M-ENJP-MT – 350M-malli kaksisuuntaiseen englannin-japani-käännökseen ↔.

> LFM2-1.2B-RAG – 1.2B-malli, joka on optimoitu pitkän kontekstin kysymyksiin vastaamiseen RAG-putkissa.

> LFM2-1.2B-työkalu – 1.2B-malli, joka on rakennettu funktiokutsuun ja agenttityökalujen käyttöön.

> LFM2-350M-Math – 350M päättelymalli matemaattisten ongelmien ratkaisemiseen.

4/n

"Minusta on erittäin vaikuttavaa, että Liquidin uudenlainen harjoittelua edeltävä ja sen jälkeinen tekniikka mahdollistaa sen, että heidän nopeat ja pienet LLM:t toimivat samalla tasolla kuin GPT-4o:n kaltaiset etulinjamallit, jotka ovat suuruusluokkaa suurempia, erikoistehtävissä", sanoi Mikhail Parakhin (@MParakhin), Shopifyn teknologiajohtaja. "Liquid nostaa samanaikaisesti rimaa sekä suorituskyvyn että nopeuden suhteen perustusmalleissa ja ylittää tekniikan tason. Siksi olemme innoissamme voidessamme hyödyntää heidän mallejaan Shopifyn alustoilla ja palveluissa." 5/n

"Deloitte on innoissaan mahdollisuudesta tehdä yhteistyötä Liquid AI:n ja heidän uuden Nanos-mallinsa kanssa, jolla on potentiaalia parantaa suurempiin malleihin verrattavissa olevaa suorituskykyä pienemmillä kustannuksilla", sanoi Ranjit Bawa (@ronbawa), strategia- ja teknologiajohtaja, Deloitte U.S. 6/n

"Liquidin Nanos edustaa voimakasta käännekohtaa tekoälytietokoneille, ja se tarjoaa huipputason suorituskykyä kompaktissa ja energiatehokkaassa muodossa. AMD:llä keskitymme suorituskykyyn wattia kohden ja näemme laitteen älykkyyden avaimena tekoälyn laajaan ja kestävään skaalaamiseen", sanoi Mark Papermaster (@mpaper2000), AMD:n teknologiajohtaja ja varatoimitusjohtaja. 7/n

139,6K

Johtavat

Rankkaus

Suosikit