Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Presentamos Liquid Nanos ⚛️ — una nueva familia de modelos extremadamente pequeños y específicos para tareas que ofrecen un rendimiento de clase GPT-4o mientras se ejecutan directamente en teléfonos, laptops, coches, dispositivos integrados y GPUs con la menor latencia y la velocidad de generación más rápida.

> tamaño del modelo: 350M a 2.6B

> construido sobre LFM2, nuestra arquitectura de modelo eficiente v2

> compiten de manera competitiva con modelos hasta cientos de veces más grandes

> habilitan tareas centrales de agente: extracción precisa de datos, traducción multilingüe, llamada a herramientas, matemáticas y RAG. 1/n

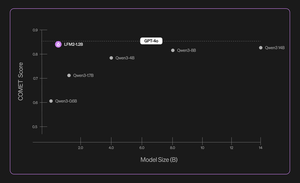

Utilizamos una combinación de métodos para evaluaciones automatizadas, destilación de conocimiento, RL y fusión de modelos para mejorar iterativamente el rendimiento de un modelo en una tarea dada. Los modelos resultantes, aunque pequeños, rinden de manera competitiva frente a modelos sustancialmente más grandes. 2/n

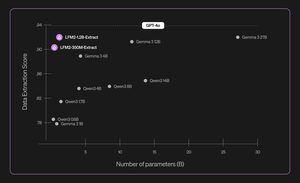

Por ejemplo, LFM2-350M-Extract y LFM2-1.2B-Extract están diseñados para extraer información importante de una amplia variedad de documentos no estructurados (como artículos, transcripciones o informes) en salidas estructuradas como JSON, XML o YAML. Son compatibles con entradas en inglés, árabe, chino, francés, alemán, japonés, coreano, portugués y español.

Nuestros modelos de extracción de datos proporcionan un aumento significativo en validez, precisión y fidelidad. Por ejemplo, LFM2-1.2B-Extract puede generar objetos complejos en diferentes idiomas a un nivel superior al de Gemma 3 27B, un modelo 22.5 veces más grande y que se acerca a su rendimiento al de GPT-4o. 3/n

Anunciamos seis Nanos específicos para tareas en nuestro lanzamiento inicial:

> LFM2-Extract – Un modelo multilingüe de 350M y 1.2B para la extracción de datos de texto no estructurado, como convertir correos electrónicos de facturas en objetos JSON.

> LFM2‑350M‑ENJP‑MT – Un modelo de 350M para traducción bidireccional entre inglés ↔ japonés.

> LFM2‑1.2B‑RAG – Un modelo de 1.2B optimizado para respuestas a preguntas de largo contexto en pipelines RAG.

> LFM2‑1.2B‑Tool – Un modelo de 1.2B diseñado para llamadas a funciones y uso de herramientas agentes.

> LFM2‑350M‑Math – Un modelo de razonamiento de 350M para resolver problemas matemáticos.

4/n

"Me parece muy impresionante que la novedosa técnica de pre-entrenamiento y post-entrenamiento de Liquid permita que sus LLMs rápidos y pequeños rindan al nivel de modelos de vanguardia como GPT-4o, que es órdenes de magnitud más grande, en tareas especializadas," dijo Mikhail Parakhin (@MParakhin), CTO de Shopify. "Liquid está elevando simultáneamente el estándar tanto para el rendimiento como para la velocidad en modelos fundamentales, superando el estado del arte. Por eso estamos emocionados de utilizar sus modelos en las plataformas y servicios de Shopify." 5/n

"Deloitte está emocionado por la oportunidad de colaborar con Liquid AI y su nuevo modelo Nanos, que tiene el potencial de impulsar un rendimiento comparable al de modelos más grandes a un costo menor", dijo Ranjit Bawa (@ronbawa), Director de Estrategia y Tecnología, Deloitte U.S. 6/n

"Los Nanos de Liquid representan un poderoso punto de inflexión para los PCs con IA, ofreciendo un rendimiento de nivel fronterizo en un formato compacto y eficiente en energía. En AMD, compartimos este enfoque en el liderazgo de rendimiento por vatio y vemos la inteligencia en el dispositivo como clave para escalar la IA de manera amplia y sostenible", dijo Mark Papermaster (@mpaper2000), CTO y EVP de AMD. 7/n

560,97K

Parte superior

Clasificación

Favoritos