Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

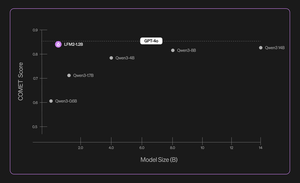

Giới thiệu Liquid Nanos ⚛️ — một gia đình mới của các mô hình cực kỳ nhỏ gọn, chuyên biệt cho nhiệm vụ, mang lại hiệu suất tương đương GPT-4o trong khi chạy trực tiếp trên điện thoại, máy tính xách tay, ô tô, thiết bị nhúng và GPU với độ trễ thấp nhất và tốc độ tạo ra nhanh nhất.

> kích thước mô hình: 350M đến 2.6B

> được xây dựng trên LFM2, kiến trúc mô hình hiệu quả v2 của chúng tôi

> hoạt động cạnh tranh với các mô hình lớn gấp hàng trăm lần

> cho phép thực hiện các nhiệm vụ cốt lõi: trích xuất dữ liệu chính xác, dịch đa ngôn ngữ, gọi công cụ, toán học và RAG. 1/n

Chúng tôi sử dụng sự kết hợp của các phương pháp để đánh giá tự động, tinh chế kiến thức, RL và hợp nhất mô hình nhằm cải thiện hiệu suất của một mô hình trên một nhiệm vụ nhất định theo cách lặp đi lặp lại. Các mô hình kết quả, mặc dù nhỏ, nhưng hoạt động cạnh tranh với các mô hình lớn hơn nhiều. 2/n

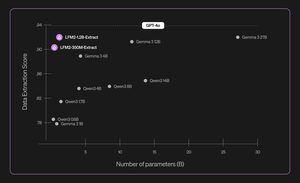

Ví dụ, LFM2-350M-Extract và LFM2-1.2B-Extract được thiết kế để trích xuất thông tin quan trọng từ nhiều loại tài liệu không cấu trúc (như bài viết, biên bản, hoặc báo cáo) thành các đầu ra có cấu trúc như JSON, XML, hoặc YAML. Chúng tương thích với các đầu vào bằng tiếng Anh, Ả Rập, Trung Quốc, Pháp, Đức, Nhật Bản, Hàn Quốc, Bồ Đào Nha và Tây Ban Nha.

Các mô hình trích xuất dữ liệu của chúng tôi cung cấp sự gia tăng đáng kể về tính hợp lệ, độ chính xác và độ trung thành. Ví dụ, LFM2-1.2B-Extract có thể xuất ra các đối tượng phức tạp bằng nhiều ngôn ngữ ở mức cao hơn Gemma 3 27B, một mô hình lớn gấp 22,5 lần và gần đạt hiệu suất của GPT-4o. 3/n

Chúng tôi thông báo về sáu Nanos theo nhiệm vụ trong bản phát hành ban đầu của chúng tôi:

> LFM2-Extract – Một mô hình đa ngôn ngữ 350M và 1.2B để trích xuất dữ liệu từ văn bản không cấu trúc, như chuyển đổi email hóa đơn thành các đối tượng JSON.

> LFM2‑350M‑ENJP‑MT – Một mô hình 350M cho dịch song phương giữa tiếng Anh ↔ tiếng Nhật.

> LFM2‑1.2B‑RAG – Một mô hình 1.2B được tối ưu hóa cho việc trả lời câu hỏi trong ngữ cảnh dài trong các pipeline RAG.

> LFM2‑1.2B‑Tool – Một mô hình 1.2B được xây dựng cho việc gọi hàm và sử dụng công cụ tự động.

> LFM2‑350M‑Math – Một mô hình suy luận 350M để giải quyết các bài toán toán học.

4/n

“Tôi thấy rất ấn tượng rằng kỹ thuật huấn luyện trước và sau độc đáo của Liquid cho phép các LLM nhỏ và nhanh của họ hoạt động ngang bằng với các mô hình tiên tiến như GPT-4o, mà lớn hơn hàng triệu lần, trong các nhiệm vụ chuyên biệt,” Mikhail Parakhin (@MParakhin), CTO của Shopify, cho biết. “Liquid đang đồng thời nâng cao tiêu chuẩn cho cả hiệu suất và tốc độ trong các mô hình nền tảng, vượt qua cả công nghệ tiên tiến nhất. Đó là lý do tại sao chúng tôi rất hào hứng khi sử dụng các mô hình của họ trên các nền tảng và dịch vụ của Shopify.” 5/n

“Deloitte rất hào hứng với cơ hội hợp tác cùng Liquid AI và mô hình Nanos mới của họ, có tiềm năng mang lại hiệu suất tương đương với các mô hình lớn hơn với chi phí thấp hơn,” Ranjit Bawa (@ronbawa), Giám đốc Chiến lược và Công nghệ, Deloitte U.S. 6/n

“Nanos của Liquid đại diện cho một điểm chuyển mình mạnh mẽ cho các PC AI, mang lại hiệu suất cấp biên trong một hình thức nhỏ gọn, tiết kiệm năng lượng. Tại AMD, chúng tôi chia sẻ sự tập trung này vào việc dẫn đầu hiệu suất trên watt và xem trí tuệ trên thiết bị là chìa khóa để mở rộng AI một cách rộng rãi và bền vững,” Mark Papermaster (@mpaper2000), CTO và EVP, AMD cho biết. 7/n

139,58K

Hàng đầu

Thứ hạng

Yêu thích