Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

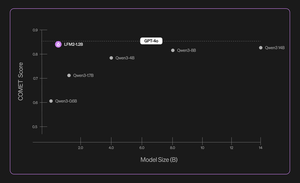

Introductie van Liquid Nanos ⚛️ — een nieuwe familie van extreem kleine taak-specifieke modellen die GPT-4o-klasse prestaties leveren terwijl ze direct draaien op telefoons, laptops, auto's, ingebedde apparaten en GPU's met de laagste latentie en de snelste generatie snelheid.

> modelgrootte: 350M tot 2.6B

> gebouwd op LFM2, onze v2 efficiënte modelarchitectuur

> presteert concurrerend met modellen tot honderden keren groter

> stelt kern agentische taken in staat: nauwkeurige gegevensextractie, meertalige vertaling, tool-aanroep, wiskunde en RAG. 1/n

We gebruiken een combinatie van methoden voor geautomatiseerde evaluaties, kennisdistillatie, RL en model-samenvoeging om de prestaties van een model op een bepaalde taak iteratief te verbeteren. De resulterende modellen, hoewel klein, presteren competitief ten opzichte van aanzienlijk grotere modellen. 2/n

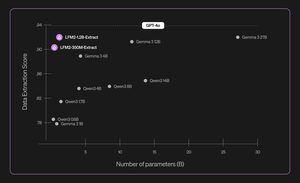

Bijvoorbeeld, LFM2-350M-Extract en LFM2-1.2B-Extract zijn ontworpen om belangrijke informatie uit een breed scala aan ongestructureerde documenten (zoals artikelen, transcripties of rapporten) te extraheren naar gestructureerde uitvoer zoals JSON, XML of YAML. Ze zijn compatibel met invoer in het Engels, Arabisch, Chinees, Frans, Duits, Japans, Koreaans, Portugees en Spaans.

Onze data-extractiemodellen bieden een aanzienlijke boost in geldigheid, nauwkeurigheid en trouw. Bijvoorbeeld, LFM2-1.2B-Extract kan complexe objecten in verschillende talen outputten op een niveau dat hoger is dan Gemma 3 27B, een model dat 22,5 keer zo groot is en zijn prestaties benadert van GPT-4o. 3/n

We kondigen zes taak-specifieke Nanos aan in onze eerste release:

> LFM2-Extract – Een 350M en 1.2B meertalige modellen voor gegevensextractie uit ongestructureerde tekst, zoals het omzetten van factuur-e-mails in JSON-objecten.

> LFM2‑350M‑ENJP‑MT – Een 350M model voor bidirectionele Engelse ↔ Japanse vertaling.

> LFM2‑1.2B‑RAG – Een 1.2B model geoptimaliseerd voor vraag-antwoord in lange contexten in RAG-pijplijnen.

> LFM2‑1.2B‑Tool – Een 1.2B model gebouwd voor functie-aanroepen en agentische toolgebruik.

> LFM2‑350M‑Math – Een 350M redeneermodel voor het oplossen van wiskundige problemen.

4/n

"Ik vind het zeer indrukwekkend dat de nieuwe pre-train- en post-train-techniek van Liquid hun snelle en kleine LLM's in staat stelt om op gelijke hoogte te presteren met grensmodellen zoals GPT-4o, dat orders of magnitude groter is, bij gespecialiseerde taken," zei Mikhail Parakhin (@MParakhin), CTO van Shopify. "Liquid tilt tegelijkertijd de lat voor zowel prestaties als snelheid in fundamentmodellen, en duwt verder dan de huidige stand van zaken. Daarom zijn we enthousiast om hun modellen te gebruiken op de platforms en diensten van Shopify." 5/n

"Deloitte is enthousiast over de mogelijkheid om samen te werken met Liquid AI en hun nieuwe Nanos-model, dat het potentieel heeft om prestaties te leveren die vergelijkbaar zijn met grotere modellen tegen lagere kosten," zei Ranjit Bawa (@ronbawa), Chief Strategy and Technology Officer, Deloitte U.S. 6/n

"Liquid's Nanos vertegenwoordigt een krachtig keerpunt voor AI-pc's, met grensverleggende prestaties in een compacte, energie-efficiënte vorm. Bij AMD delen we deze focus op prestaties per watt leiderschap en beschouwen we on-device intelligentie als de sleutel tot het breed en duurzaam opschalen van AI," zei Mark Papermaster (@mpaper2000), CTO en EVP, AMD. 7/n

560,97K

Boven

Positie

Favorieten