Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

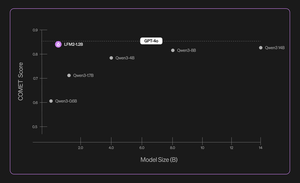

Представляем Liquid Nanos ⚛️ — новую семью чрезвычайно маленьких моделей, предназначенных для выполнения конкретных задач, которые обеспечивают производительность на уровне GPT-4o, работая непосредственно на телефонах, ноутбуках, автомобилях, встроенных устройствах и GPU с наименьшей задержкой и самой быстрой скоростью генерации.

> размер модели: от 350M до 2.6B

> основаны на LFM2, нашей эффективной архитектуре модели v2

> конкурируют с моделями, которые в сотни раз больше

> позволяют выполнять основные агентные задачи: точный извлечение данных, многоязычный перевод, вызов инструментов, математика и RAG. 1/n

Мы используем комбинацию методов для автоматизированных оценок, дистилляции знаний, RL и объединения моделей, чтобы итеративно улучшать производительность модели по заданной задаче. Полученные модели, хотя и небольшие, показывают конкурентоспособные результаты по сравнению с существенно более крупными моделями. 2/n

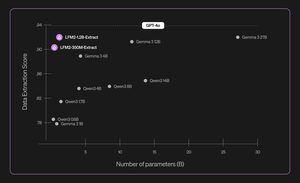

Например, LFM2-350M-Extract и LFM2-1.2B-Extract предназначены для извлечения важной информации из широкого спектра неструктурированных документов (таких как статьи, стенограммы или отчеты) в структурированные выходные данные, такие как JSON, XML или YAML. Они совместимы с входными данными на английском, арабском, китайском, французском, немецком, японском, корейском, португальском и испанском языках.

Наши модели извлечения данных обеспечивают значительное повышение валидности, точности и достоверности. Например, LFM2-1.2B-Extract может выводить сложные объекты на разных языках на уровне выше, чем Gemma 3 27B, модели, которая в 22,5 раза больше и приближается по производительности к GPT-4o. 3/n

Мы объявляем о шести специализированных Nanos в нашем первоначальном релизе:

> LFM2-Extract – Многоязычные модели на 350M и 1.2B для извлечения данных из неструктурированного текста, например, преобразование электронных писем с счетами в объекты JSON.

> LFM2‑350M‑ENJP‑MT – Модель на 350M для двунаправленного перевода с английского на японский и обратно.

> LFM2‑1.2B‑RAG – Модель на 1.2B, оптимизированная для ответов на вопросы с длинным контекстом в RAG-пайплайнах.

> LFM2‑1.2B‑Tool – Модель на 1.2B, созданная для вызова функций и использования инструментов агентами.

> LFM2‑350M‑Math – Модель на 350M для решения математических задач.

4/n

«Меня очень впечатляет, что новая техника предварительной и последующей тренировки Liquid позволяет их быстрым и компактным LLM работать на уровне передовых моделей, таких как GPT-4o, которые в несколько раз больше, в специализированных задачах», — сказал Михаил Парахин (@MParakhin), технический директор Shopify. «Liquid одновременно поднимает планку как для производительности, так и для скорости в базовых моделях, выходя за рамки современного уровня. Вот почему мы рады использовать их модели на платформах и в сервисах Shopify.» 5/n

"Deloitte рада возможности сотрудничать с Liquid AI и их новой моделью Nanos, которая имеет потенциал обеспечить производительность, сопоставимую с более крупными моделями, при более низких затратах," сказал Ранджит Бава (@ronbawa), директор по стратегии и технологиям, Deloitte U.S. 6/n

«Nanos от Liquid представляет собой мощную точку поворота для AI ПК, обеспечивая производительность на уровне передовых технологий в компактной и энергоэффективной форме. В AMD мы разделяем этот акцент на лидерстве в производительности на ватт и считаем, что интеллектуальные устройства являются ключом к широкомасштабному и устойчивому внедрению AI», — сказал Марк Папермастер (@mpaper2000), технический директор и EVP, AMD. 7/n

560,99K

Топ

Рейтинг

Избранное