Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Przedstawiamy Liquid Nanos ⚛️ — nową rodzinę niezwykle małych modeli specyficznych dla zadań, które oferują wydajność na poziomie GPT-4o, działając bezpośrednio na telefonach, laptopach, samochodach, urządzeniach wbudowanych i GPU z najniższą latencją i najszybszą prędkością generacji.

> rozmiar modelu: od 350M do 2.6B

> zbudowany na LFM2, naszej wydajnej architekturze modelu v2

> konkurencyjny w wydajności z modelami do setek razy większymi

> umożliwia podstawowe zadania agentowe: precyzyjne wydobywanie danych, tłumaczenie wielojęzyczne, wywoływanie narzędzi, matematyka i RAG. 1/n

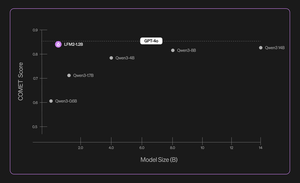

Używamy kombinacji metod do automatycznych ocen, destylacji wiedzy, RL i łączenia modeli, aby iteracyjnie poprawić wydajność modelu w danym zadaniu. Otrzymane modele, chociaż małe, działają konkurencyjnie w porównaniu do znacznie większych modeli. 2/n

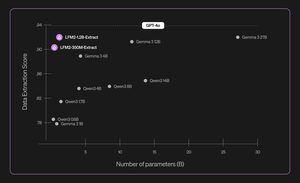

Na przykład, LFM2-350M-Extract i LFM2-1.2B-Extract są zaprojektowane do wydobywania ważnych informacji z szerokiej gamy niestrukturalnych dokumentów (takich jak artykuły, transkrypcje czy raporty) do strukturalnych wyników, takich jak JSON, XML lub YAML. Są kompatybilne z wejściami w języku angielskim, arabskim, chińskim, francuskim, niemieckim, japońskim, koreańskim, portugalskim i hiszpańskim.

Nasze modele ekstrakcji danych zapewniają znaczący wzrost ważności, dokładności i wierności. Na przykład, LFM2-1.2B-Extract może generować złożone obiekty w różnych językach na poziomie wyższym niż Gemma 3 27B, model 22,5 razy większy, zbliżający się do wydajności GPT-4o. 3/n

Ogłaszamy sześć modeli Nanos, które są specyficzne dla zadań w naszej początkowej wersji:

> LFM2-Extract – Modele wielojęzyczne 350M i 1.2B do ekstrakcji danych z tekstu nieustrukturyzowanego, takie jak przekształcanie e-maili z fakturami w obiekty JSON.

> LFM2‑350M‑ENJP‑MT – Model 350M do dwukierunkowego tłumaczenia angielski ↔ japoński.

> LFM2‑1.2B‑RAG – Model 1.2B zoptymalizowany do odpowiadania na pytania w długim kontekście w pipeline'ach RAG.

> LFM2‑1.2B‑Tool – Model 1.2B stworzony do wywoływania funkcji i użycia narzędzi agentowych.

> LFM2‑350M‑Math – Model 350M do rozwiązywania problemów matematycznych.

4/n

„Uważam, że to bardzo imponujące, że nowatorska technika wstępnego i końcowego szkolenia Liquid pozwala ich szybkim i małym LLM-om osiągać wyniki porównywalne z modelami czołowymi, takimi jak GPT-4o, które są o rzędy wielkości większe, w specjalistycznych zadaniach” – powiedział Mikhail Parakhin (@MParakhin), CTO, Shopify. „Liquid jednocześnie podnosi poprzeczkę zarówno dla wydajności, jak i szybkości w modelach podstawowych, przesuwając granice stanu techniki. Dlatego cieszymy się, że możemy wykorzystać ich modele w platformach i usługach Shopify.” 5/n

„Deloitte jest podekscytowane możliwością współpracy z Liquid AI i ich nowym modelem Nanos, który ma potencjał, aby osiągać wyniki porównywalne z większymi modelami przy niższych kosztach” – powiedział Ranjit Bawa (@ronbawa), dyrektor ds. strategii i technologii w Deloitte U.S. 6/n

„Nanos Liquid to potężny punkt zwrotny dla komputerów PC z AI, oferujący wydajność na poziomie granicznym w kompaktowej, energooszczędnej formie. W AMD podzielamy to skupienie na przywództwie w zakresie wydajności na wat i postrzegamy inteligencję na urządzeniu jako klucz do szerokiego i zrównoważonego skalowania AI,” powiedział Mark Papermaster (@mpaper2000), CTO i EVP w AMD. 7/n

284,62K

Najlepsze

Ranking

Ulubione