Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

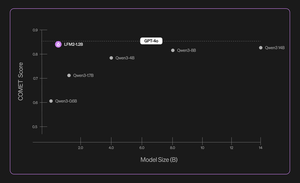

Einführung von Liquid Nanos ⚛️ — einer neuen Familie von extrem kleinen, aufgaben-spezifischen Modellen, die eine Leistung auf GPT-4o-Klasse bieten, während sie direkt auf Handys, Laptops, Autos, eingebetteten Geräten und GPUs mit der niedrigsten Latenz und der schnellsten Generierungsgeschwindigkeit laufen.

> Modellgröße: 350M bis 2,6B

> basiert auf LFM2, unserer v2 effizienten Modellarchitektur

> konkurrieren leistungsstark mit Modellen, die bis zu Hunderte von Malen größer sind

> ermöglichen zentrale agentische Aufgaben: präzise Datenextraktion, mehrsprachige Übersetzung, Toolaufruf, Mathematik und RAG. 1/n

Wir verwenden eine Kombination von Methoden für automatisierte Bewertungen, Wissensdistillation, RL und Modellfusion, um die Leistung eines Modells bei einer bestimmten Aufgabe iterativ zu verbessern. Die resultierenden Modelle, obwohl klein, schneiden im Vergleich zu erheblich größeren Modellen wettbewerbsfähig ab. 2/n

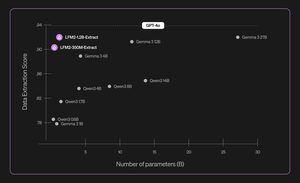

Zum Beispiel sind LFM2-350M-Extract und LFM2-1.2B-Extract dafür ausgelegt, wichtige Informationen aus einer Vielzahl von unstrukturierten Dokumenten (wie Artikeln, Transkripten oder Berichten) in strukturierte Ausgaben wie JSON, XML oder YAML zu extrahieren. Sie sind kompatibel mit Eingaben in Englisch, Arabisch, Chinesisch, Französisch, Deutsch, Japanisch, Koreanisch, Portugiesisch und Spanisch.

Unsere Datenextraktionsmodelle bieten einen erheblichen Schub in Bezug auf Gültigkeit, Genauigkeit und Treue. Zum Beispiel kann LFM2-1.2B-Extract komplexe Objekte in verschiedenen Sprachen auf einem höheren Niveau ausgeben als Gemma 3 27B, ein Modell, das 22,5-mal so groß ist und dessen Leistung sich der von GPT-4o nähert. 3/n

Wir kündigen sechs aufgabenbezogene Nanos in unserer ersten Veröffentlichung an:

> LFM2-Extract – Ein 350M und 1.2B mehrsprachiges Modell zur Datenextraktion aus unstrukturiertem Text, wie das Umwandeln von Rechnungs-E-Mails in JSON-Objekte.

> LFM2‑350M‑ENJP‑MT – Ein 350M Modell für bidirektionale Englisch ↔ Japanisch Übersetzung.

> LFM2‑1.2B‑RAG – Ein 1.2B Modell, das für die Beantwortung von Fragen mit langem Kontext in RAG-Pipelines optimiert ist.

> LFM2‑1.2B‑Tool – Ein 1.2B Modell, das für Funktionsaufrufe und agentische Werkzeugnutzung entwickelt wurde.

> LFM2‑350M‑Math – Ein 350M Denkmodell zur Lösung mathematischer Probleme.

4/n

„Ich finde es sehr beeindruckend, dass die neuartige Vor- und Nachtrainingstechnik von Liquid es ihren schnellen und kleinen LLMs ermöglicht, bei spezialisierten Aufgaben auf dem Niveau von Frontmodellen wie GPT-4o zu performen, die um Größenordnungen größer sind“, sagte Mikhail Parakhin (@MParakhin), CTO von Shopify. „Liquid setzt gleichzeitig neue Maßstäbe für sowohl Leistung als auch Geschwindigkeit in Fundamentmodellen und geht über den Stand der Technik hinaus. Deshalb sind wir begeistert, ihre Modelle auf den Plattformen und Dienstleistungen von Shopify zu nutzen.“ 5/n

„Deloitte ist begeistert von der Möglichkeit, mit Liquid AI und ihrem neuen Nanos-Modell zusammenzuarbeiten, das das Potenzial hat, eine Leistung vergleichbar mit größeren Modellen zu einem niedrigeren Preis zu erzielen“, sagte Ranjit Bawa (@ronbawa), Chief Strategy and Technology Officer, Deloitte U.S. 6/n

„Die Nanos von Liquid stellt einen entscheidenden Wendepunkt für AI-PCs dar und bietet eine leistungsstarke Leistung auf höchstem Niveau in einem kompakten, energieeffizienten Format. Bei AMD teilen wir diesen Fokus auf die Führerschaft in der Leistung pro Watt und sehen die Intelligenz auf dem Gerät als Schlüssel zur breiten und nachhaltigen Skalierung von AI“, sagte Mark Papermaster (@mpaper2000), CTO und EVP von AMD. 7/n

560,93K

Top

Ranking

Favoriten