Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

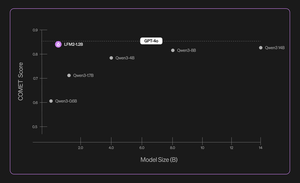

Apresentando o Liquid Nanos ⚛️ — uma nova família de modelos específicos de tarefas extremamente pequenos que oferecem desempenho de classe GPT-4o enquanto são executados diretamente em telefones, laptops, carros, dispositivos incorporados e GPUs com a menor latência e velocidade de geração mais rápida.

> tamanho do modelo: 350M a 2.6B

> construído no LFM2, nossa arquitetura de modelo eficiente v2

> desempenho competitivo com modelos até centenas de vezes maiores

> permitem tarefas principais do agente: extração precisa de dados, tradução multilíngue, chamada de ferramentas, matemática e RAG. 1/n

Usamos uma combinação de métodos para avaliações automatizadas, destilação de conhecimento, RL e mesclagem de modelos para melhorar iterativamente o desempenho de um modelo em uma determinada tarefa. Os modelos resultantes, embora pequenos, têm um desempenho competitivo em relação aos modelos substancialmente maiores. 2/n

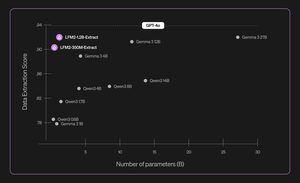

Por exemplo, LFM2-350M-Extract e LFM2-1.2B-Extract são projetados para extrair informações importantes de uma ampla variedade de documentos não estruturados (como artigos, transcrições ou relatórios) em saídas estruturadas como JSON, XML ou YAML. Eles são compatíveis com entradas em inglês, árabe, chinês, francês, alemão, japonês, coreano, português e espanhol.

Nossos modelos de extração de dados fornecem um aumento significativo na validade, precisão e fidelidade. Por exemplo, LFM2-1.2B-Extract pode produzir objetos complexos em diferentes idiomas em um nível superior ao Gemma 3 27B, um modelo 22.5 vezes seu tamanho e próximo ao desempenho do GPT-4o. 3/n

Anunciamos seis Nanos específicos para tarefas em nossa versão inicial:

> LFM2-Extract – Um modelo multilíngue de 350M e 1,2B para extração de dados de texto não estruturado, como transformar e-mails de fatura em objetos JSON.

> LFM2-350M-ENJP-MT – um modelo de 350M para tradução bidirecional Inglês-Japonês ↔.

> LFM2-1.2B-RAG – Um modelo de 1,2B otimizado para responder a perguntas de contexto longo em pipelines RAG.

> LFM2-1.2B-Tool – Um modelo 1.2B construído para chamada de função e uso de ferramentas agenciais.

> LFM2-350M-Math – Um modelo de raciocínio de 350M para resolver problemas matemáticos.

4/n

"Acho muito impressionante que a nova técnica de pré-treinamento e pós-treinamento da Liquid permita que seus LLMs rápidos e pequenos tenham um desempenho semelhante ao de modelos de fronteira, como o GPT-4o, que é ordens de magnitude maior, em tarefas especializadas", disse Mikhail Parakhin (@MParakhin), CTO da Shopify. "A Liquid está simultaneamente elevando o nível de desempenho e velocidade nos modelos de base, indo além do estado da arte. É por isso que estamos entusiasmados em utilizar seus modelos nas plataformas e serviços da Shopify." 5/n

"A Deloitte está entusiasmada com a oportunidade de colaborar com a Liquid AI e seu novo modelo Nanos, que tem o potencial de impulsionar o desempenho comparável a modelos maiores a um custo menor", disse Ranjit Bawa (@ronbawa), diretor de estratégia e tecnologia da Deloitte U.S. 6/n

"O Nanos da Liquid representa um poderoso ponto de inflexão para PCs de IA, oferecendo desempenho de nível de fronteira em uma forma compacta e eficiente em termos de energia. Na AMD, compartilhamos esse foco na liderança de desempenho por watt e vemos a inteligência no dispositivo como a chave para dimensionar a IA de forma ampla e sustentável", disse Mark Papermaster (@mpaper2000), CTO e EVP da AMD. 7/n

560,99K

Melhores

Classificação

Favoritos