热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

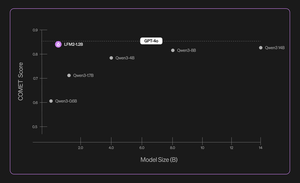

介绍 Liquid Nanos ⚛️ — 一种全新的极小型任务特定模型家族,能够在手机、笔记本电脑、汽车、嵌入式设备和 GPU 上直接运行,提供与 GPT-4o 类似的性能,同时具有最低的延迟和最快的生成速度。

> 模型大小:350M 到 2.6B

> 基于 LFM2,我们的 v2 高效模型架构

> 与高达数百倍更大模型的竞争表现

> 实现核心代理任务:精确数据提取、多语言翻译、工具调用、数学运算和 RAG。 1/n

我们使用多种方法进行自动评估、知识蒸馏、强化学习和模型合并,以迭代地提高模型在特定任务上的表现。尽管生成的模型较小,但其性能与大得多的模型相当。 2/n

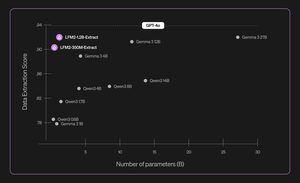

例如,LFM2-350M-Extract 和 LFM2-1.2B-Extract 旨在从各种非结构化文档(如文章、转录或报告)中提取重要信息,并将其转换为结构化输出,如 JSON、XML 或 YAML。它们兼容英语、阿拉伯语、中文、法语、德语、日语、韩语、葡萄牙语和西班牙语输入。

我们的数据提取模型在有效性、准确性和忠实度方面提供了显著提升。例如,LFM2-1.2B-Extract 可以以高于 Gemma 3 27B 的水平输出不同语言的复杂对象,后者是其大小的 22.5 倍,并且其性能接近 GPT-4o。 3/n

我们在初始发布中宣布六个特定任务的Nanos:

> LFM2-Extract – 一个350M和1.2B的多语言模型,用于从非结构化文本中提取数据,比如将发票邮件转换为JSON对象。

> LFM2‑350M‑ENJP‑MT – 一个350M的双向英语↔日语翻译模型。

> LFM2‑1.2B‑RAG – 一个1.2B的模型,针对RAG管道中的长上下文问答进行了优化。

> LFM2‑1.2B‑Tool – 一个1.2B的模型,专为函数调用和代理工具使用而构建。

> LFM2‑350M‑Math – 一个350M的推理模型,用于解决数学问题。

4/n

“我发现Liquid的新型预训练和后训练技术非常令人印象深刻,使得他们快速且小型的LLM在专业任务上能够与像GPT-4o这样规模大几个数量级的前沿模型相媲美,”Shopify首席技术官Mikhail Parakhin(@MParakhin)表示。“Liquid同时在基础模型的性能和速度上设定了新的标准,超越了现有的技术水平。这就是为什么我们很高兴能够在Shopify的平台和服务中使用他们的模型。” 5/n

“德勤对与Liquid AI及其新Nanos模型的合作机会感到兴奋,该模型有潜力以更低的成本驱动与更大模型相当的性能,”德勤美国首席战略和技术官Ranjit Bawa(@ronbawa)表示。6/n

“Liquid的Nanos代表了AI PC的一个强大转折点,在紧凑且节能的形式中提供前沿级别的性能。在AMD,我们也关注每瓦性能的领导地位,并认为设备内智能是广泛和可持续扩展AI的关键,”AMD首席技术官兼执行副总裁Mark Papermaster(@mpaper2000)表示。 7/n

139.59K

热门

排行

收藏