Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

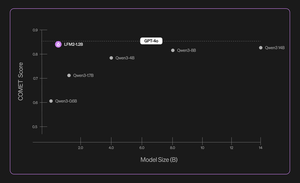

Introducendo Liquid Nanos ⚛️ — una nuova famiglia di modelli estremamente piccoli e specifici per compiti che offrono prestazioni di classe GPT-4o mentre funzionano direttamente su telefoni, laptop, auto, dispositivi embedded e GPU con la latenza più bassa e la velocità di generazione più rapida.

> dimensione del modello: 350M a 2.6B

> costruito su LFM2, la nostra architettura di modello efficiente v2

> performano in modo competitivo con modelli fino a centinaia di volte più grandi

> abilitano compiti agentici fondamentali: estrazione dati precisa, traduzione multilingue, chiamata di strumenti, matematica e RAG. 1/n

Utilizziamo una combinazione di metodi per valutazioni automatizzate, distillazione della conoscenza, RL e fusione dei modelli per migliorare iterativamente le prestazioni di un modello su un determinato compito. I modelli risultanti, sebbene piccoli, si comportano in modo competitivo rispetto a modelli sostanzialmente più grandi. 2/n

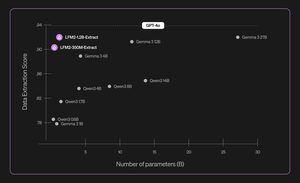

Ad esempio, LFM2-350M-Extract e LFM2-1.2B-Extract sono progettati per estrarre informazioni importanti da una vasta gamma di documenti non strutturati (come articoli, trascrizioni o rapporti) in output strutturati come JSON, XML o YAML. Sono compatibili con input in inglese, arabo, cinese, francese, tedesco, giapponese, coreano, portoghese e spagnolo.

I nostri modelli di estrazione dei dati forniscono un notevole aumento di validità, accuratezza e fedeltà. Ad esempio, LFM2-1.2B-Extract può generare oggetti complessi in diverse lingue a un livello superiore rispetto a Gemma 3 27B, un modello 22,5 volte più grande e che si avvicina alle prestazioni di GPT-4o. 3/n

Annunciamo sei Nanos specifici per compiti nel nostro rilascio iniziale:

> LFM2-Extract – Modelli multilingue da 350M e 1.2B per l'estrazione di dati da testo non strutturato, come trasformare le email delle fatture in oggetti JSON.

> LFM2‑350M‑ENJP‑MT – Un modello da 350M per la traduzione bidirezionale tra inglese e giapponese.

> LFM2‑1.2B‑RAG – Un modello da 1.2B ottimizzato per rispondere a domande in contesti lunghi nei pipeline RAG.

> LFM2‑1.2B‑Tool – Un modello da 1.2B costruito per chiamate di funzione e utilizzo di strumenti agentici.

> LFM2‑350M‑Math – Un modello di ragionamento da 350M per risolvere problemi matematici.

4/n

“Trovo molto impressionante che la nuova tecnica di pre-addestramento e post-addestramento di Liquid consenta ai loro LLM veloci e piccoli di esibirsi alla pari con modelli all'avanguardia come GPT-4o, che è ordini di grandezza più grande, in compiti specializzati," ha dichiarato Mikhail Parakhin (@MParakhin), CTO di Shopify. "Liquid sta alzando simultaneamente l'asticella sia per le prestazioni che per la velocità nei modelli di base, superando lo stato dell'arte. Ecco perché siamo entusiasti di utilizzare i loro modelli su tutte le piattaforme e i servizi di Shopify.” 5/n

“Deloitte è entusiasta dell'opportunità di collaborare con Liquid AI e il loro nuovo modello Nanos, che ha il potenziale di offrire prestazioni comparabili a modelli più grandi a un costo inferiore,” ha dichiarato Ranjit Bawa (@ronbawa), Chief Strategy and Technology Officer di Deloitte U.S. 6/n

"I Nanos di Liquid rappresentano un potente punto di svolta per i PC AI, offrendo prestazioni di livello avanzato in una forma compatta ed energeticamente efficiente. In AMD, condividiamo questo focus sulla leadership delle prestazioni per watt e vediamo l'intelligenza on-device come fondamentale per scalare l'AI in modo ampio e sostenibile," ha dichiarato Mark Papermaster (@mpaper2000), CTO e EVP di AMD. 7/n

139,59K

Principali

Ranking

Preferiti