Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Présentation de Liquid Nanos ⚛️ — une nouvelle famille de modèles extrêmement petits et spécifiques aux tâches qui offrent des performances de classe GPT-4o tout en fonctionnant directement sur des téléphones, ordinateurs portables, voitures, dispositifs embarqués et GPU avec la latence la plus basse et la vitesse de génération la plus rapide.

> taille du modèle : 350M à 2,6B

> construit sur LFM2, notre architecture de modèle efficace v2

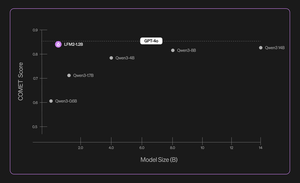

> performe de manière compétitive avec des modèles jusqu'à des centaines de fois plus grands

> permet des tâches agentiques essentielles : extraction de données précise, traduction multilingue, appel d'outils, mathématiques et RAG. 1/n

Nous utilisons une combinaison de méthodes pour des évaluations automatisées, la distillation des connaissances, l'apprentissage par renforcement et la fusion de modèles afin d'améliorer de manière itérative la performance d'un modèle sur une tâche donnée. Les modèles résultants, bien que petits, sont compétitifs par rapport à des modèles substantiellement plus grands. 2/n

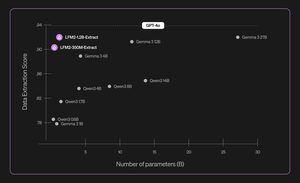

Par exemple, LFM2-350M-Extract et LFM2-1.2B-Extract sont conçus pour extraire des informations importantes d'une grande variété de documents non structurés (tels que des articles, des transcriptions ou des rapports) en sorties structurées comme JSON, XML ou YAML. Ils sont compatibles avec des entrées en anglais, arabe, chinois, français, allemand, japonais, coréen, portugais et espagnol.

Nos modèles d'extraction de données offrent un gain significatif en validité, précision et fidélité. Par exemple, LFM2-1.2B-Extract peut produire des objets complexes dans différentes langues à un niveau supérieur à Gemma 3 27B, un modèle 22,5 fois plus grand et approchant ses performances à celles de GPT-4o. 3/n

Nous annonçons six Nanos spécifiques à des tâches dans notre première version :

> LFM2-Extract – Un modèle multilingue de 350M et 1.2B pour l'extraction de données à partir de texte non structuré, comme transformer des e-mails de factures en objets JSON.

> LFM2‑350M‑ENJP‑MT – Un modèle de 350M pour la traduction bidirectionnelle anglais ↔ japonais.

> LFM2‑1.2B‑RAG – Un modèle de 1.2B optimisé pour la réponse à des questions en contexte long dans des pipelines RAG.

> LFM2‑1.2B‑Tool – Un modèle de 1.2B conçu pour l'appel de fonctions et l'utilisation d'outils agentiques.

> LFM2‑350M‑Math – Un modèle de raisonnement de 350M pour résoudre des problèmes mathématiques.

4/n

« Je trouve très impressionnant que la technique novatrice de pré-entraînement et de post-entraînement de Liquid permette à leurs LLMs rapides et compacts de performer au même niveau que des modèles de pointe tels que GPT-4o, qui est de plusieurs ordres de grandeur plus grand, sur des tâches spécialisées », a déclaré Mikhail Parakhin (@MParakhin), CTO de Shopify. « Liquid élève simultanément la barre tant en termes de performance que de vitesse dans les modèles de base, dépassant l'état de l'art. C'est pourquoi nous sommes ravis d'utiliser leurs modèles sur les plateformes et services de Shopify. » 5/n

« Deloitte est enthousiaste à l'idée de collaborer avec Liquid AI et leur nouveau modèle Nanos, qui a le potentiel d'offrir des performances comparables à celles de modèles plus grands à un coût inférieur », a déclaré Ranjit Bawa (@ronbawa), Directeur de la stratégie et de la technologie, Deloitte U.S. 6/n

« Les Nanos de Liquid représentent un point d'inflexion puissant pour les PC AI, offrant des performances de niveau avancé dans un format compact et économe en énergie. Chez AMD, nous partageons cet objectif de leadership en performance par watt et considérons l'intelligence sur appareil comme essentielle pour étendre l'IA de manière large et durable », a déclaré Mark Papermaster (@mpaper2000), CTO et EVP, AMD. 7/n

284,62K

Meilleurs

Classement

Favoris