熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

介紹 Liquid Nanos ⚛️ — 一個全新的極小型任務專用模型系列,能在手機、筆記型電腦、汽車、嵌入式設備和 GPU 上直接運行,提供 GPT-4o 級別的性能,並具備最低的延遲和最快的生成速度。

> 模型大小:350M 到 2.6B

> 基於 LFM2,我們的 v2 高效模型架構

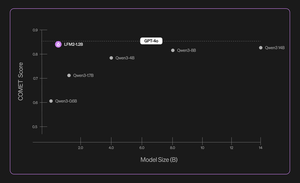

> 與數百倍更大的模型競爭表現

> 實現核心代理任務:精確數據提取、多語言翻譯、工具調用、數學運算和 RAG。 1/n

我們使用多種方法進行自動評估、知識蒸餾、強化學習和模型合併,以迭代地提高模型在特定任務上的表現。雖然結果模型較小,但其表現與大得多的模型相當。 2/n

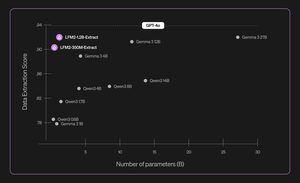

例如,LFM2-350M-Extract 和 LFM2-1.2B-Extract 被設計用來從各種非結構化文件(如文章、逐字稿或報告)中提取重要信息,並轉換為結構化輸出,如 JSON、XML 或 YAML。它們兼容英語、阿拉伯語、中文、法語、德語、日語、韓語、葡萄牙語和西班牙語的輸入。

我們的數據提取模型在有效性、準確性和忠實度上提供了顯著的提升。例如,LFM2-1.2B-Extract 能夠以高於 Gemma 3 27B 的水平輸出不同語言的複雜對象,該模型的大小是其 22.5 倍,並且其性能接近 GPT-4o。 3/n

我們在初始版本中宣布六個特定任務的 Nanos:

> LFM2-Extract – 一個 350M 和 1.2B 的多語言模型,用於從非結構化文本中提取數據,例如將發票電子郵件轉換為 JSON 對象。

> LFM2‑350M‑ENJP‑MT – 一個 350M 模型,用於雙向英語 ↔ 日語翻譯。

> LFM2‑1.2B‑RAG – 一個 1.2B 模型,優化用於 RAG 管道中的長上下文問題回答。

> LFM2‑1.2B‑Tool – 一個 1.2B 模型,專為函數調用和代理工具使用而構建。

> LFM2‑350M‑Math – 一個 350M 推理模型,用於解決數學問題。

4/n

“我覺得Liquid的新型預訓練和後訓練技術非常令人印象深刻,使他們快速且小型的LLM能夠在專業任務上與像GPT-4o這樣的前沿模型相媲美,而後者的規模大數量級,”Shopify的CTO Mikhail Parakhin(@MParakhin)表示。“Liquid同時在基礎模型的性能和速度上提高了標準,超越了當前的技術水平。這就是為什麼我們對在Shopify的平台和服務中使用他們的模型感到興奮。” 5/n

“德勤對於與Liquid AI及其新Nanos模型合作的機會感到興奮,該模型有潛力以更低的成本驅動與較大模型相當的性能,”德勤美國首席策略與技術官Ranjit Bawa(@ronbawa)表示。 6/n

“Liquid 的 Nanos 代表了 AI PC 的一個強大轉折點,提供了前沿級別的性能,並以緊湊、節能的形式呈現。在 AMD,我們也專注於每瓦特性能的領導地位,並認為設備內智能是廣泛且可持續擴展 AI 的關鍵,”AMD 的首席技術官兼執行副總裁 Mark Papermaster (@mpaper2000) 說。 7/n

284.62K

熱門

排行

收藏