Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Evolução do aprendizado de few-shot para LLMs de raciocínio moderno usando @NethermindEth AuditAgent como exemplo.

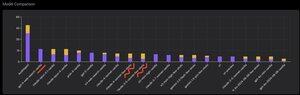

Abaixo, você pode ver um gráfico interessante, ou melhor, uma comparação do número de vulnerabilidades corretamente identificadas pelo nosso produto em comparação com LLMs prontos como @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro ou @xai Grok-4.

Claro, a parte óbvia dessa comparação, que já mostrei muitas vezes antes e não há nada de novo nisso, é que um agente especializado quase sempre superará uma solução de propósito geral. Essa situação é, na verdade, explicada de forma bastante simples pelo fato de que todas as soluções de propósito geral fazem parte da nossa solução especializada, embora a contribuição muito maior para o resultado venha da gestão adequada do contexto ou do que @karpathy chamou recentemente de "Engenharia de Contexto."

Além disso, o uso das ferramentas corretas e sua seleção - um modelo de propósito geral sempre terá problemas porque existem bilhões de ferramentas e aprender a usá-las todas é uma habilidade grande e separada, enquanto nós explicitamente ensinamos nosso modelo especializado a fazer isso. Depois, há o uso de bases de conhecimento corretas e algoritmos de busca adequados para elas, e assim por diante. Então, de uma forma ou de outra, fazemos tudo o que é possível, usamos todas as ferramentas possíveis para superar essas soluções de propósito geral.

Mas a nuance interessante que eu queria chamar a atenção é que se você olhar para a imagem que postei há cerca de um ano, as melhores soluções prontas eram os modelos da OpenAI ou da Anthropic com o rótulo "Few-Shot Learning", enquanto agora todos os melhores são Vanilla. E essa mudança tem ocorrido gradualmente com o surgimento do raciocínio como tal nos modelos e com a melhoria de sua qualidade. A conclusão que pode ser tirada é que exemplos de soluções corretas prontas que o modelo recebe de nós como aprendizado em contexto, quando literalmente os mostramos no prompt, param de ajudar a resolver a tarefa, ou mais precisamente, sem eles o modelo que pode raciocinar resolve o problema até melhor. Ou seja, limitamos um pouco suas capacidades ao mostrar-lhe vários exemplos que selecionamos.

Além disso, um aspecto interessante é que modelos com acesso à internet e seleção automática dessa ferramenta também começam a superar tudo, significando que o modelo pode ir à internet e formular o contexto certo para si mesmo. Sim, claro que há o risco de que o modelo encontre a resposta correta, mas naturalmente trabalhamos especificamente com isso, fazemos blacklist de sites e assim por diante, então tentamos não ter esse tipo de vazamento nos dados (a benchmarkização adequada é fundamental no geral). Mas a tendência é interessante - os modelos estão se tornando mais inteligentes e assumindo cada vez mais componentes da solução por conta própria, não exigindo que os desenvolvedores façam configurações explícitas no contexto.

Qual é a sua experiência com isso?

572

Top

Classificação

Favoritos