Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Utvikling av læring med få skudd for moderne resonnerende LLM-er ved å bruke @NethermindEth AuditAgent som eksempel.

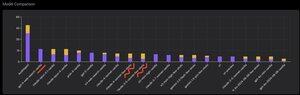

Nedenfor kan du se en interessant graf, eller rettere sagt en sammenligning av antall korrekt identifiserte sårbarheter av produktet vårt sammenlignet med ferdige LLM-er som @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro eller @xai Grok-4.

Selvfølgelig er den åpenbare delen av denne sammenligningen, som jeg har vist mange ganger før, og det er ikke noe nytt i den, at en spesialisert agent nesten alltid vil overgå en generell løsning. Denne situasjonen forklares faktisk ganske enkelt av det faktum at alle generelle løsninger er en del av vår spesialiserte løsning, selv om det mye større bidraget til resultatet kommer fra riktig kontekststyring eller det som nylig @karpathy kalt "Context Engineering".

I tillegg til dette vil bruken av riktige verktøy og deres valg - en generell modell alltid ha problemer fordi det er milliarder av verktøy og å lære å bruke dem alle er en egen stor ferdighet, mens vi eksplisitt lærer vår spesialiserte modell dette. Så er det bruken av riktige kunnskapsbaser og riktige søkealgoritmer for dem, og så videre. Så på en eller annen måte gjør vi alt mulig, bruker alle mulige verktøy for å slå disse generelle løsningene.

Men den interessante nyansen jeg ønsket å trekke oppmerksomhet til er at hvis du ser på bildet jeg la ut for et år siden eller så, var de beste ferdige løsningene OpenAI eller Anthropic-modeller med en "Few-Shot Learning"-etikett, mens nå er alle de beste Vanilla. Og denne endringen har skjedd gradvis med fremveksten av resonnement som sådan i modeller og med forbedring av kvaliteten. Konklusjonen som kan trekkes er at ferdige korrekte løsningseksempler som modellen mottar fra oss som in-context læring, når vi bokstavelig talt viser dem i ledeteksten, slutter å hjelpe til med å løse oppgaven, eller mer presist, uten dem løser modellen som kan resonnere problemet enda bedre. Det vil si at vi begrenser mulighetene noe ved å vise den flere eksempler vi har valgt.

I tillegg er et interessant aspekt at modeller med internettilgang og automatisk valg av dette verktøyet også begynner å overgå alt, noe som betyr at modellen kan gå til selve internett og formulere riktig kontekst for seg selv. Ja, selvfølgelig er det en risiko for at modellen finner det riktige svaret, men naturligvis jobber vi spesifikt med dette, vi svartelister nettsteder og så videre, så vi prøver å ikke få slik lekkasje i dataene (riktig benchmarking er nøkkelen totalt sett). Men trenden er interessant - modeller blir smartere og tar på seg flere og flere komponenter i løsningen selv, og krever ikke at utviklere eksplisitt gjør visse innstillinger i konteksten.

Hva er din erfaring med dette?

524

Topp

Rangering

Favoritter