热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

现代推理 LLM 的少量学习演变,以 @NethermindEth AuditAgent 为例。

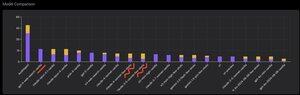

下面你可以看到一个有趣的图表,或者说是我们产品与现成的 LLM(如 @OpenAI GPT-5、@AnthropicAI Claude Opus 4.1、@Google Gemini 2.5 Pro 或 @xai Grok-4)在正确识别漏洞数量上的比较。

当然,这个比较的明显部分,我之前已经展示过很多次,并没有什么新意,那就是专用代理几乎总是会优于通用解决方案。这个情况实际上可以很容易解释,因为所有的通用解决方案都是我们专用解决方案的一部分,尽管对结果的贡献更大的是适当的上下文管理,或者说是 @karpathy 最近所称的 "上下文工程"。

除了这一点,正确工具的使用和选择 - 通用模型总是会遇到问题,因为有数十亿的工具,而学习使用它们所有的工具是一项独立的大技能,而我们明确地教导我们的专用模型这一点。然后是使用正确的知识库和适当的搜索算法等等。因此,无论如何,我们尽一切可能,使用所有可能的工具来击败这些通用解决方案。

但我想引起注意的有趣细节是,如果你看看我大约一年前发布的图片,顶尖的现成解决方案是 OpenAI 或 Anthropic 模型,带有 "少量学习" 标签,而现在所有顶尖的都是 Vanilla。这个变化随着推理的出现以及其质量的提高而逐渐发生。可以得出的结论是,模型从我们这里获得的作为上下文学习的现成正确解决方案示例,当我们在提示中字面展示它们时,停止帮助解决任务,或者更准确地说,没有它们的模型能够推理,解决问题的能力甚至更强。也就是说,通过展示我们选择的几个示例,我们在某种程度上限制了它的能力。

此外,一个有趣的方面是,具有互联网访问权限和自动选择工具的模型也开始超越一切,这意味着模型可以自己上网并为自己制定正确的上下文。是的,当然存在模型找到正确答案的风险,但我们自然会专门处理这个问题,我们会对网站进行黑名单处理等等,因此我们尽量不让数据中出现这种泄漏(适当的基准测试总体上是关键)。但这个趋势很有趣 - 模型变得更聪明,越来越多地承担解决方案的组成部分,而不需要开发人员在上下文中明确进行某些设置。

你对此有什么经验?

519

热门

排行

收藏