Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Еволюція малокадрового навчання для сучасних LLM міркувань на прикладі @NethermindEth AuditAgent.

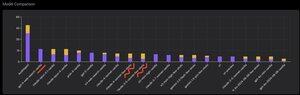

Нижче ви можете побачити цікавий графік, а точніше порівняння кількості правильно виявлених вразливостей нашим продуктом у порівнянні з готовими LLM, такими як @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro або @xai Grok-4.

Звичайно, очевидна частина цього порівняння, яку я вже багато разів показував і в якій немає нічого нового, полягає в тому, що спеціалізований агент майже завжди перевершує універсальне рішення. Ця ситуація насправді досить легко пояснюється тим, що всі універсальні рішення є частиною нашого спеціалізованого рішення, хоча набагато більший внесок у результат робить правильне управління контекстом або те, що @karpathy нещодавно назвали «контекстною інженерією».

На додаток до цього, використання правильних інструментів і їх підбір - у моделі загального призначення завжди будуть проблеми, тому що є мільярди інструментів і навчитися користуватися ними всіма - це окрема велика навичка, в той час як ми явно навчаємо цьому нашу спеціалізовану модель. Далі йде використання правильних баз знань і правильних алгоритмів пошуку для них і так далі. Тому так чи інакше, ми робимо все можливе, використовуємо всі можливі інструменти, щоб обіграти ці універсальні рішення.

Але цікавий нюанс, на який я хотів звернути увагу, полягає в тому, що якщо ви подивитеся на картинку, яку я виклав рік тому або близько того, то топовими готовими рішеннями були моделі OpenAI або Anthropic з позначкою «Few-Shot Learning», тоді як зараз усі топові — це Vanilla. І ця зміна поступово відбувається з появою міркувань як таких в моделях і з поліпшенням його якості. Висновок, який можна зробити, це те, що готові приклади правильних рішень, які модель отримує від нас як навчання в контексті, коли ми буквально показуємо їх в підказці, перестають допомагати вирішувати завдання, а точніше, без них модель, яка вміє міркувати, вирішує проблему ще краще. Тобто ми дещо обмежуємо його можливості, показуючи кілька вибраних нами прикладів.

Крім того, цікавим аспектом є те, що моделі з доступом до інтернету та автоматичним вибором цього інструменту також починають перевершувати все, тобто модель може сама вийти в інтернет і сформулювати для себе правильний контекст. Так, звичайно, є ризик, що модель знайде правильну відповідь, але природно ми працюємо саме з цим, робимо чорні списки сайтів і так далі, тому намагаємося не отримати такого витоку в даних (правильний бенчмаркінг в цілому ключовий). Але цікава тенденція - моделі стають розумнішими і самі беруть на себе все більше компонентів рішення, не вимагаючи від розробників явного внесення тих чи інших налаштувань в контексті.

Який у вас досвід з цим?

525

Найкращі

Рейтинг

Вибране