トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AuditAgentを例にした現代の推論LLMのための少数ショット学習@NethermindEth進化

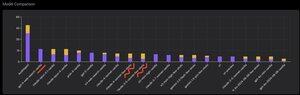

以下に、@OpenAI GPT-5、@AnthropicAI Claude Opus 4.1、@Google Gemini 2.5 Pro、@xai Grok-4 などの既製の LLM と比較して、当社の製品によって正しく特定された脆弱性の数比較した興味深いグラフ、またはむしろ見ることができます。

もちろん、この比較の明らかな部分は、これまで何度も示しましたが、新しいことは何もありませんが、専門のエージェントはほとんどの場合、汎用ソリューションよりも優れているということです。この状況は、すべての汎用ソリューションが当社の特殊なソリューションの一部であるという事実によって、実際には非常に簡単に説明できますが、結果へのはるかに大きな貢献は、適切なコンテキスト管理、または最近「コンテキストエンジニアリング」と呼ばれるものによって@karpathyされます。

これに加えて、正しいツールの使用とその選択 - 汎用モデルには何十億ものツールがあり、それらすべてを使用する方法を学ぶことは別の大きなスキルであるため、常に問題を抱えていますが、私たちはこれを専門モデルに明示的に教えています。次に、正しいナレッジベースと適切な検索アルゴリズムの使用などがあります。したがって、いずれにせよ、私たちは可能な限りのことを行い、可能なすべてのツールを使用して、これらの汎用ソリューションを打ち負かします。

しかし、私が注目したかった興味深いニュアンスは、私が 1 年ほど前に投稿した写真を見ると、既製のソリューションのトップは「Few-Shot Learning」ラベルが付いた OpenAI または Anthropic モデルでしたが、現在はトップのソリューションはすべて Vanilla であるということです。そして、この変化は、モデルにおける推論そのものの出現とその品質の向上とともに徐々に起こっています。導き出すことができる結論は、モデルがコンテキスト内学習として私たちから受け取る既製の正しい解決策の例は、プロンプトで文字通りそれらを表示すると、タスクの解決を支援するのをやめるか、より正確には、それらなしでは、推論できるモデルが問題をさらによく解決します。つまり、選択したいくつかの例を示すことで、その機能をいくらか制限します。

さらに、興味深い点は、インターネットにアクセスでき、このツールを自動選択するモデルもすべてを凌駕し始め、モデル自体がインターネットにアクセスし、それ自体に適したコンテキストを定式化できることです。はい、もちろんモデルが正しい答えを見つけるリスクはありますが、当然のことながら、私たちはこれに特化して作業し、サイトのブラックリストなどを行うため、データにそのような漏洩が発生しないようにしています(適切なベンチマークが全体的に重要です)。しかし、この傾向は興味深いもので、モデルはよりスマートになり、ソリューション自体のコンポーネントをますます引き受けており、開発者がコンテキストで特定の設定を明示的に行う必要はなくなっています。

これについてどのような経験がありますか?

518

トップ

ランキング

お気に入り