Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ewolucja uczenia się na podstawie kilku przykładów dla nowoczesnych modeli LLM do rozumowania, używając @NethermindEth AuditAgent jako przykładu.

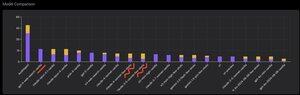

Poniżej możesz zobaczyć interesujący wykres, a raczej porównanie liczby poprawnie zidentyfikowanych luk w zabezpieczeniach przez nasz produkt w porównaniu do gotowych modeli LLM, takich jak @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro czy @xai Grok-4.

Oczywiście oczywistą częścią tego porównania, którą pokazywałem wiele razy wcześniej i nie ma w tym nic nowego, jest to, że wyspecjalizowany agent prawie zawsze przewyższa rozwiązanie ogólnego przeznaczenia. Ta sytuacja jest w rzeczywistości dość łatwo wyjaśniona przez fakt, że wszystkie rozwiązania ogólnego przeznaczenia są częścią naszego wyspecjalizowanego rozwiązania, chociaż znacznie większy wkład w wynik pochodzi z odpowiedniego zarządzania kontekstem, co @karpathy niedawno nazwał "Inżynierią Kontekstu."

Oprócz tego, użycie odpowiednich narzędzi i ich selekcja - model ogólnego przeznaczenia zawsze będzie miał problemy, ponieważ istnieją miliardy narzędzi, a nauczenie się ich wszystkich to osobna, duża umiejętność, podczas gdy my explicite uczymy nasz wyspecjalizowany model tego. Następnie jest użycie odpowiednich baz wiedzy i odpowiednich algorytmów wyszukiwania dla nich, i tak dalej. Więc w ten czy inny sposób robimy wszystko, co możliwe, używamy wszystkich dostępnych narzędzi, aby pokonać te rozwiązania ogólnego przeznaczenia.

Ale interesującym niuansem, na który chciałem zwrócić uwagę, jest to, że jeśli spojrzysz na obrazek, który opublikowałem rok temu lub coś w tym stylu, to najlepsze gotowe rozwiązania to były modele OpenAI lub Anthropic z etykietą "Few-Shot Learning", podczas gdy teraz wszystkie najlepsze to Vanilla. I ta zmiana zachodziła stopniowo wraz z pojawieniem się rozumowania jako takiego w modelach i poprawą jego jakości. Wniosek, który można wyciągnąć, jest taki, że gotowe przykłady poprawnych rozwiązań, które model otrzymuje od nas jako uczenie w kontekście, kiedy dosłownie pokazujemy je w podpowiedzi, przestają pomagać w rozwiązaniu zadania, a dokładniej, bez nich model, który potrafi rozumować, rozwiązuje problem nawet lepiej. To znaczy, w pewnym sensie ograniczamy jego możliwości, pokazując mu kilka przykładów, które wybraliśmy.

Dodatkowo interesującym aspektem jest to, że modele z dostępem do internetu i automatycznym doborem tego narzędzia również zaczynają przewyższać wszystko, co oznacza, że model może samodzielnie przeszukiwać internet i formułować odpowiedni kontekst dla siebie. Tak, oczywiście istnieje ryzyko, że model znajdzie poprawną odpowiedź, ale naturalnie pracujemy nad tym, robimy czarną listę stron i tak dalej, więc staramy się nie dopuścić do takiego wycieku w danych (odpowiednie benchmarki są kluczowe ogólnie). Ale trend jest interesujący - modele stają się mądrzejsze i przejmują coraz więcej komponentów rozwiązania samodzielnie, nie wymagając od deweloperów explicite dokonywania pewnych ustawień w kontekście.

Jakie są Twoje doświadczenia w tej kwestii?

520

Najlepsze

Ranking

Ulubione