Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Evolution des Few-Shot-Lernens für moderne reasoning LLMs am Beispiel von @NethermindEth AuditAgent.

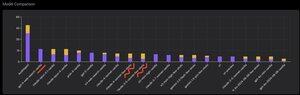

Unten sehen Sie ein interessantes Diagramm, oder besser gesagt, einen Vergleich der Anzahl der korrekt identifizierten Schwachstellen durch unser Produkt im Vergleich zu fertigen LLMs wie @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro oder @xai Grok-4.

Natürlich ist der offensichtliche Teil dieses Vergleichs, den ich schon viele Male zuvor gezeigt habe und der nichts Neues ist, dass ein spezialisierter Agent fast immer eine allgemeine Lösung übertreffen wird. Diese Situation lässt sich tatsächlich ganz einfach erklären, da alle allgemeinen Lösungen Teil unserer spezialisierten Lösung sind, obwohl der viel größere Beitrag zum Ergebnis aus dem richtigen Kontextmanagement oder dem, was @karpathy kürzlich "Context Engineering" nannte, stammt.

Zusätzlich dazu ist die Verwendung der richtigen Werkzeuge und deren Auswahl - ein allgemeines Modell wird immer Probleme haben, da es Milliarden von Werkzeugen gibt und das Lernen, sie alle zu verwenden, eine separate große Fähigkeit ist, während wir unser spezialisiertes Modell dies ausdrücklich lehren. Dann gibt es die Verwendung der richtigen Wissensdatenbanken und geeigneter Suchalgorithmen dafür und so weiter. Also tun wir alles Mögliche, nutzen alle verfügbaren Werkzeuge, um diese allgemeinen Lösungen zu übertreffen.

Aber der interessante Aspekt, auf den ich aufmerksam machen wollte, ist, dass, wenn Sie sich das Bild ansehen, das ich vor etwa einem Jahr gepostet habe, die besten fertigen Lösungen OpenAI oder Anthropic-Modelle mit dem Label "Few-Shot Learning" waren, während jetzt alle Top-Modelle Vanilla sind. Und dieser Wandel hat allmählich mit dem Aufkommen des Reasoning in Modellen und mit der Verbesserung seiner Qualität stattgefunden. Die Schlussfolgerung, die man ziehen kann, ist, dass fertige Beispiele für korrekte Lösungen, die das Modell von uns als In-Context-Learning erhält, wenn wir sie ihm buchstäblich im Prompt zeigen, nicht mehr helfen, die Aufgabe zu lösen, oder genauer gesagt, ohne sie löst das Modell, das reasoning kann, das Problem sogar besser. Das heißt, wir beschränken gewissermaßen seine Fähigkeiten, indem wir ihm mehrere Beispiele zeigen, die wir ausgewählt haben.

Zusätzlich ist ein interessanter Aspekt, dass Modelle mit Internetzugang und automatischer Auswahl dieses Werkzeugs ebenfalls beginnen, alles zu übertreffen, was bedeutet, dass das Modell selbst ins Internet gehen und den richtigen Kontext für sich selbst formulieren kann. Ja, natürlich besteht das Risiko, dass das Modell die richtige Antwort findet, aber natürlich arbeiten wir speziell daran, wir machen Blacklisting von Seiten und so weiter, also versuchen wir, solche Datenlecks zu vermeiden (ordentliches Benchmarking ist insgesamt der Schlüssel). Aber der Trend ist interessant - Modelle werden intelligenter und übernehmen immer mehr Komponenten der Lösung selbst, ohne dass Entwickler ausdrücklich bestimmte Einstellungen im Kontext vornehmen müssen.

Was sind Ihre Erfahrungen damit?

544

Top

Ranking

Favoriten