Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Evoluția învățării în câteva lovituri pentru LLM-urile de raționament modern folosind @NethermindEth AuditAgent ca exemplu.

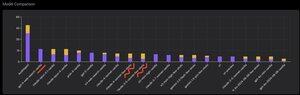

Mai jos puteți vedea un grafic interesant, sau mai degrabă o comparație a numărului de vulnerabilități identificate corect de produsul nostru în comparație cu LLM-urile gata făcute, cum ar fi @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro sau @xai Grok-4.

Desigur, partea evidentă a acestei comparații, pe care am arătat-o de multe ori și nu este nimic nou în ea, este că un agent specializat va depăși aproape întotdeauna o soluție de uz general. Această situație este de fapt explicată destul de ușor prin faptul că toate soluțiile de uz general fac parte din soluția noastră specializată, deși contribuția mult mai mare la rezultat vine din gestionarea corectă a contextului sau ceea ce @karpathy numit recent "Ingineria contextului".

În plus, utilizarea instrumentelor corecte și selecția lor - un model de uz general va avea întotdeauna probleme pentru că există miliarde de instrumente și a învăța să le folosești pe toate este o abilitate mare separată, în timp ce noi predăm în mod explicit modelul nostru specializat acest lucru. Apoi există utilizarea bazelor de cunoștințe corecte și a algoritmilor de căutare adecvați pentru ele și așa mai departe. Deci, într-un fel sau altul, facem tot posibilul, folosim toate instrumentele posibile pentru a învinge aceste soluții de uz general.

Dar nuanța interesantă asupra căreia am vrut să atrag atenția este că, dacă te uiți la poza pe care am postat-o acum un an, cele mai bune soluții gata făcute au fost modelele OpenAI sau Anthropic cu eticheta "Few-Shot Learning", în timp ce acum toate cele de top sunt Vanilla. Și această schimbare a avut loc treptat odată cu apariția raționamentului ca atare în modele și cu îmbunătățirea calității sale. Concluzia care poate fi trasă este că exemplele de soluții corecte gata făcute pe care modelul le primește de la noi ca învățare în context, atunci când le arătăm literalmente în prompt, încetează să ajute la rezolvarea sarcinii sau, mai precis, fără ele, modelul care poate rațional rezolvă problema și mai bine. Adică, îi limităm oarecum capacitățile arătându-i mai multe exemple pe care le-am selectat.

În plus, un aspect interesant este că modelele cu acces la internet și selecția automată a acestui instrument încep să depășească totul, ceea ce înseamnă că modelul poate merge pe internet și poate formula contextul potrivit pentru el însuși. Da, desigur că există riscul ca modelul să găsească răspunsul corect, dar în mod natural lucrăm în mod specific cu asta, facem lista neagră a site-urilor și așa mai departe, așa că încercăm să nu obținem astfel de scurgeri de date (benchmarking-ul adecvat este esențial în general). Dar tendința este interesantă - modelele devin mai inteligente și preiau din ce în ce mai multe componente ale soluției, necerând dezvoltatorilor să facă în mod explicit anumite setări în context.

Care este experiența ta cu asta?

515

Limită superioară

Clasament

Favorite