Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Эволюция обучения с несколькими примерами для современных LLM с рассуждениями на примере @NethermindEth AuditAgent.

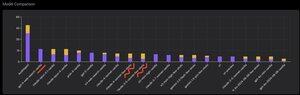

Ниже вы можете увидеть интересный график, а точнее, сравнение количества правильно идентифицированных уязвимостей нашим продуктом по сравнению с готовыми LLM, такими как @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro или @xai Grok-4.

Конечно, очевидная часть этого сравнения, которую я показывал много раз ранее и в которой нет ничего нового, заключается в том, что специализированный агент почти всегда превосходит универсальное решение. Эта ситуация на самом деле объясняется довольно просто тем, что все универсальные решения являются частью нашего специализированного решения, хотя гораздо больший вклад в результат вносит правильное управление контекстом или то, что @karpathy недавно назвал "Инженерией Контекста."

Кроме этого, использование правильных инструментов и их выбор - универсальная модель всегда будет иметь проблемы, потому что существует миллиарды инструментов, и обучение их использованию - это отдельный большой навык, в то время как мы явно обучаем нашу специализированную модель этому. Затем есть использование правильных баз знаний и правильных алгоритмов поиска для них и так далее. Так или иначе, мы делаем все возможное, используем все возможные инструменты, чтобы превзойти эти универсальные решения.

Но интересный нюанс, на который я хотел обратить внимание, заключается в том, что если вы посмотрите на картину, которую я опубликовал год назад или около того, то лучшие готовые решения были моделями OpenAI или Anthropic с меткой "Обучение с несколькими примерами", в то время как сейчас все лучшие - это Vanilla. И это изменение постепенно происходило с появлением рассуждений как таковых в моделях и с улучшением их качества. Вывод, который можно сделать, заключается в том, что готовые примеры правильных решений, которые модель получает от нас в качестве обучения в контексте, когда мы буквально показываем их в подсказке, перестают помогать решать задачу, или, точнее, без них модель, способная рассуждать, решает проблему даже лучше. То есть мы несколько ограничиваем ее возможности, показывая ей несколько примеров, которые мы выбрали.

Кроме того, интересный аспект заключается в том, что модели с доступом в интернет и автоматическим выбором этого инструмента также начинают превосходить все, что означает, что модель может сама выходить в интернет и формулировать правильный контекст для себя. Да, конечно, есть риск, что модель найдет правильный ответ, но, естественно, мы работаем именно с этим, мы проводим черный список сайтов и так далее, поэтому мы стараемся избежать утечек в данных (правильное бенчмаркинг - это ключевой момент в целом). Но тренд интересный - модели становятся умнее и берут на себя все больше компонентов решения, не требуя от разработчиков явно задавать определенные настройки в контексте.

Каков ваш опыт с этим?

523

Топ

Рейтинг

Избранное