Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Evolusi pembelajaran beberapa tembakan untuk LLM penalaran modern menggunakan @NethermindEth AuditAgent sebagai contoh.

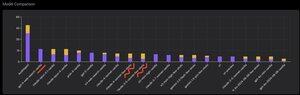

Di bawah ini Anda dapat melihat grafik yang menarik, atau lebih tepatnya perbandingan jumlah kerentanan yang diidentifikasi dengan benar oleh produk kami dibandingkan dengan LLM siap pakai seperti @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro, atau @xai Grok-4.

Tentu saja, bagian yang jelas dari perbandingan ini, yang telah saya tunjukkan berkali-kali sebelumnya dan tidak ada yang baru di dalamnya, adalah bahwa agen khusus hampir selalu akan mengungguli solusi tujuan umum. Situasi ini sebenarnya dijelaskan dengan cukup mudah oleh fakta bahwa semua solusi tujuan umum adalah bagian dari solusi khusus kami, meskipun kontribusi yang jauh lebih besar terhadap hasil berasal dari manajemen konteks yang tepat atau apa yang baru@karpathy baru ini disebut "Rekayasa Konteks."

Selain itu, penggunaan alat yang benar dan pemilihannya - model tujuan umum akan selalu bermasalah karena ada miliaran alat dan belajar menggunakan semuanya adalah keterampilan besar yang terpisah, sementara kami secara eksplisit mengajarkan model khusus kami ini. Lalu ada penggunaan basis pengetahuan yang benar dan algoritma pencarian yang tepat untuk mereka, dan sebagainya. Jadi dengan satu atau lain cara, kami melakukan segala yang mungkin, menggunakan semua alat yang mungkin untuk mengalahkan solusi tujuan umum ini.

Tetapi nuansa menarik yang ingin saya tarik perhatian adalah bahwa jika Anda melihat gambar yang saya posting setahun yang lalu atau lebih, solusi siap pakai teratas adalah model OpenAI atau Anthropic dengan label "Few-Shot Learning", sementara sekarang semua yang teratas adalah Vanilla. Dan perubahan ini secara bertahap terjadi dengan munculnya penalaran seperti itu dalam model dan dengan peningkatan kualitasnya. Kesimpulan yang dapat ditarik adalah bahwa contoh solusi benar yang sudah jadi yang diterima model dari kita sebagai pembelajaran dalam konteks, ketika kita benar-benar menunjukkannya dalam prompt, berhenti membantu memecahkan tugas, atau lebih tepatnya, tanpa mereka model yang dapat bernalar memecahkan masalah dengan lebih baik. Artinya, kami agak membatasi kemampuannya dengan menunjukkan beberapa contoh yang telah kami pilih.

Selain itu, aspek yang menarik adalah bahwa model dengan akses internet dan pemilihan otomatis alat ini juga mulai mengungguli segalanya, yang berarti model dapat pergi ke internet itu sendiri dan merumuskan konteks yang tepat untuk dirinya sendiri. Ya, tentu saja ada risiko bahwa model akan menemukan jawaban yang benar, tetapi tentu saja kami bekerja secara khusus dengan ini, kami melakukan daftar hitam situs dan sebagainya, jadi kami mencoba untuk tidak mendapatkan kebocoran seperti itu dalam data (pembandingan yang tepat adalah kunci secara keseluruhan). Tetapi trennya menarik - model menjadi lebih pintar dan mengambil lebih banyak komponen solusi itu sendiri, tidak mengharuskan pengembang untuk secara eksplisit membuat pengaturan tertentu dalam konteksnya.

Apa pengalaman Anda dengan ini?

516

Teratas

Peringkat

Favorit