Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Évolution de l'apprentissage par quelques exemples pour les LLM modernes de raisonnement en utilisant @NethermindEth AuditAgent comme exemple.

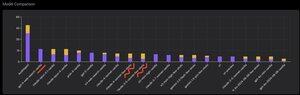

Vous pouvez voir ci-dessous un graphique intéressant, ou plutôt une comparaison du nombre de vulnérabilités correctement identifiées par notre produit par rapport aux LLM prêts à l'emploi tels que @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro, ou @xai Grok-4.

Bien sûr, la partie évidente de cette comparaison, que j'ai montrée de nombreuses fois auparavant et qui n'a rien de nouveau, est qu'un agent spécialisé surpassera presque toujours une solution polyvalente. Cette situation s'explique en fait assez facilement par le fait que toutes les solutions polyvalentes font partie de notre solution spécialisée, bien que la contribution beaucoup plus importante au résultat provienne d'une gestion appropriée du contexte ou de ce que @karpathy a récemment appelé "Ingénierie du Contexte."

En plus de cela, l'utilisation des bons outils et leur sélection - un modèle polyvalent aura toujours des problèmes car il existe des milliards d'outils et apprendre à les utiliser tous est une compétence distincte, tandis que nous enseignons explicitement à notre modèle spécialisé cela. Ensuite, il y a l'utilisation de bonnes bases de connaissances et de bons algorithmes de recherche pour celles-ci, et ainsi de suite. Donc, d'une manière ou d'une autre, nous faisons tout ce qui est possible, utilisons tous les outils possibles pour surpasser ces solutions polyvalentes.

Mais le détail intéressant auquel je voulais attirer l'attention est que si vous regardez l'image que j'ai postée il y a environ un an, les meilleures solutions prêtes à l'emploi étaient les modèles OpenAI ou Anthropic avec une étiquette "Apprentissage par Quelques Exemples", tandis que maintenant toutes les meilleures sont Vanilla. Et ce changement s'est produit progressivement avec l'émergence du raisonnement en tant que tel dans les modèles et avec l'amélioration de sa qualité. La conclusion que l'on peut tirer est que les exemples de solutions correctes prêtes à l'emploi que le modèle reçoit de notre part en tant qu'apprentissage contextuel, lorsque nous les montrons littéralement dans l'invite, cessent d'aider à résoudre la tâche, ou plus précisément, sans eux, le modèle capable de raisonner résout le problème même mieux. C'est-à-dire que nous limitons quelque peu ses capacités en lui montrant plusieurs exemples que nous avons sélectionnés.

De plus, un aspect intéressant est que les modèles avec accès à Internet et sélection automatique de cet outil commencent également à surpasser tout, ce qui signifie que le modèle peut aller sur Internet lui-même et formuler le bon contexte pour lui-même. Oui, bien sûr, il y a un risque que le modèle trouve la bonne réponse, mais naturellement, nous travaillons spécifiquement avec cela, nous faisons du blacklistage de sites, etc., donc nous essayons de ne pas avoir de telles fuites dans les données (un bon benchmarking est clé dans l'ensemble). Mais la tendance est intéressante - les modèles deviennent plus intelligents et prennent de plus en plus de composants de la solution eux-mêmes, ne nécessitant pas que les développeurs fassent explicitement certains réglages dans le contexte.

Quelle est votre expérience avec cela?

522

Meilleurs

Classement

Favoris