熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

現代推理 LLM 的少量學習演變,以 @NethermindEth AuditAgent 為例。

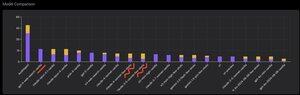

下面你可以看到一個有趣的圖表,或者說是我們產品與現成的 LLM(如 @OpenAI GPT-5、@AnthropicAI Claude Opus 4.1、@Google Gemini 2.5 Pro 或 @xai Grok-4)在正確識別漏洞數量上的比較。

當然,這個比較的明顯部分,我之前已經展示過很多次,並沒有什麼新意,那就是專用代理幾乎總是會優於通用解決方案。這個情況實際上可以很容易解釋,因為所有的通用解決方案都是我們專用解決方案的一部分,儘管對結果的貢獻更大的是適當的上下文管理,或者說是 @karpathy 最近所稱的 "上下文工程"。

除了這一點,正確工具的使用和選擇 - 通用模型總是會遇到問題,因為有數十億的工具,而學習使用它們所有的工具是一項獨立的大技能,而我們明確地教導我們的專用模型這一點。然後是使用正確的知識庫和適當的搜索算法等等。因此,無論如何,我們盡一切可能,使用所有可能的工具來擊敗這些通用解決方案。

但我想引起注意的有趣細節是,如果你看看我大約一年前發布的圖片,頂尖的現成解決方案是 OpenAI 或 Anthropic 模型,帶有 "少量學習" 標籤,而現在所有頂尖的都是 Vanilla。這個變化隨著推理的出現以及其質量的提高而逐漸發生。可以得出的結論是,模型從我們這裡獲得的作為上下文學習的現成正確解決方案示例,當我們在提示中字面展示它們時,停止幫助解決任務,或者更準確地說,沒有它們的模型能夠推理,解決問題的能力甚至更強。也就是說,通過展示我們選擇的幾個示例,我們在某種程度上限制了它的能力。

此外,一個有趣的方面是,具有互聯網訪問權限和自動選擇工具的模型也開始超越一切,這意味著模型可以自己上網並為自己制定正確的上下文。是的,當然存在模型找到正確答案的風險,但我們自然會專門處理這個問題,我們會對網站進行黑名單處理等等,因此我們儘量不讓數據中出現這種洩漏(適當的基準測試整體上是關鍵)。但這個趨勢很有趣 - 模型變得更聰明,越來越多地承擔解決方案的組成部分,而不需要開發人員在上下文中明確進行某些設置。

你對此有什麼經驗?

517

熱門

排行

收藏