Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Evolución del aprendizaje de pocos disparos para LLM de razonamiento moderno utilizando @NethermindEth AuditAgent como ejemplo.

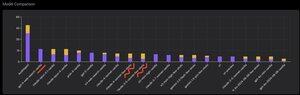

A continuación puede ver un gráfico interesante, o más bien una comparación de la cantidad de vulnerabilidades identificadas correctamente por nuestro producto en comparación con LLM listos para usar como @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro o @xai Grok-4.

Por supuesto, la parte obvia de esta comparación, que he mostrado muchas veces antes y no hay nada nuevo en ella, es que un agente especializado casi siempre superará a una solución de propósito general. Esta situación se explica con bastante facilidad por el hecho de que todas las soluciones de propósito general son parte de nuestra solución especializada, aunque la contribución mucho mayor al resultado proviene de una gestión adecuada del contexto o lo que @karpathy llamó recientemente "Ingeniería de contexto".

Además de esto, el uso de herramientas correctas y su selección: un modelo de propósito general siempre tendrá problemas porque hay miles de millones de herramientas y aprender a usarlas todas es una gran habilidad separada, mientras que enseñamos explícitamente esto a nuestro modelo especializado. Luego está el uso de bases de conocimiento correctas y algoritmos de búsqueda adecuados para ellos, y así sucesivamente. Entonces, de una forma u otra, hacemos todo lo posible, usamos todas las herramientas posibles para vencer estas soluciones de propósito general.

Pero el matiz interesante sobre el que quería llamar la atención es que si miras la imagen que publiqué hace un año más o menos, las mejores soluciones listas para usar eran modelos OpenAI o Anthropic con una etiqueta de "Few-Shot Learning", mientras que ahora todas las principales son Vanilla. Y este cambio se ha ido produciendo paulatinamente con la aparición del razonamiento como tal en los modelos y con la mejora de su calidad. La conclusión que se puede sacar es que los ejemplos de soluciones correctas ya preparados que el modelo recibe de nosotros como aprendizaje en contexto, cuando literalmente los mostramos en el prompt, dejan de ayudar a resolver la tarea, o más precisamente, sin ellos el modelo que puede razonar resuelve el problema aún mejor. Es decir, limitamos un poco sus capacidades mostrándole varios ejemplos que hemos seleccionado.

Además, un aspecto interesante es que los modelos con acceso a Internet y la selección automática de esta herramienta también comienzan a superar todo, lo que significa que el modelo puede ir a Internet y formular el contexto adecuado para sí mismo. Sí, por supuesto que existe el riesgo de que el modelo encuentre la respuesta correcta, pero naturalmente trabajamos específicamente con esto, hacemos listas negras de sitios, etc., por lo que tratamos de no obtener tal fuga en los datos (la evaluación comparativa adecuada es clave en general). Pero la tendencia es interesante: los modelos se están volviendo más inteligentes y están asumiendo cada vez más componentes de la solución, sin requerir que los desarrolladores realicen explícitamente ciertas configuraciones en el contexto.

¿Cuál es tu experiencia con esto?

526

Populares

Ranking

Favoritas