Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Muutaman laukauksen oppimisen kehitys nykyaikaiseen päättelyyn LLM:iin käyttäen esimerkkinä @NethermindEth AuditAgentia.

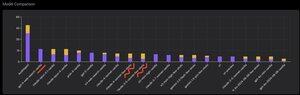

Alla näet mielenkiintoisen kaavion tai pikemminkin vertailun tuotteemme oikein tunnistettujen haavoittuvuuksien määrästä verrattuna valmiisiin LLM:iin, kuten @OpenAI GPT-5, @AnthropicAI Claude Opus 4.1, @Google Gemini 2.5 Pro tai @xai Grok-4.

Tietenkin ilmeinen osa tätä vertailua, jonka olen osoittanut monta kertaa aiemmin, eikä siinä ole mitään uutta, on se, että erikoistunut agentti on lähes aina parempi kuin yleiskäyttöinen ratkaisu. Tämä tilanne selittyy itse asiassa melko helposti sillä, että kaikki yleiskäyttöiset ratkaisut ovat osa erikoisratkaisuamme, vaikka paljon suurempi panos tulokseen tulee asianmukaisesta kontekstinhallinnasta tai siitä, mitä @karpathy äskettäin kutsuttu "kontekstisuunnitteluksi".

Tämän lisäksi oikeiden työkalujen käyttö ja niiden valinta - yleiskäyttöisessä mallissa on aina ongelmia, koska työkaluja on miljardeja ja niiden kaikkien käytön oppiminen on erillinen iso taito, kun taas opetamme tämän nimenomaisesti erikoistuneelle mallillemme. Sitten on oikeiden tietokantojen ja asianmukaisten hakualgoritmien käyttö ja niin edelleen. Joten tavalla tai toisella teemme kaikkemme, käytämme kaikkia mahdollisia työkaluja voittaaksemme nämä yleiskäyttöiset ratkaisut.

Mutta mielenkiintoinen vivahde, johon halusin kiinnittää huomiota, on se, että jos katsot noin vuosi sitten julkaisemaani kuvaa, parhaat valmiit ratkaisut olivat OpenAI- tai Anthropic -mallit, joissa oli "Few-Shot Learning" -merkintä, kun taas nyt kaikki kärjessä ovat Vanilla. Ja tämä muutos on tapahtunut vähitellen päättelyn sellaisenaan ilmaantumisen myötä malleihin ja sen laadun parantuessa. Johtopäätös, joka voidaan tehdä, on, että valmiit oikeat ratkaisuesimerkit, jotka malli saa meiltä kontekstin sisäisenä oppimisena, kun kirjaimellisesti näytämme ne kehotteessa, lakkaavat auttamasta tehtävän ratkaisemisessa, tai tarkemmin sanottuna ilman niitä malli, joka osaa päätellä, ratkaisee ongelman vielä paremmin. Toisin sanoen rajoitamme jonkin verran sen ominaisuuksia näyttämällä sille useita valitsemiamme esimerkkejä.

Lisäksi mielenkiintoinen näkökohta on, että mallit, joissa on Internet-yhteys ja tämän työkalun automaattinen valinta, alkavat myös ylittää kaiken, mikä tarkoittaa, että malli voi mennä itse Internetiin ja muotoilla itselleen oikean kontekstin. Kyllä, tietysti on olemassa riski, että malli löytää oikean vastauksen, mutta luonnollisesti työskentelemme nimenomaan tämän kanssa, teemme sivustojen mustalle listalle ja niin edelleen, joten yritämme välttää tällaista vuotoa tietoihin (asianmukainen benchmarking on kaiken kaikkiaan avainasemassa). Mutta trendi on mielenkiintoinen - malleista on tulossa älykkäämpiä ja ne ottavat yhä enemmän ratkaisun komponentteja itse, eikä kehittäjien tarvitse nimenomaisesti tehdä tiettyjä asetuksia kontekstissa.

Mitä kokemuksia sinulla on tästä?

570

Johtavat

Rankkaus

Suosikit