トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

AIモデルとホスティングプロバイダーの独立した分析 - ユースケースに最適なモデルとAPIプロバイダーを選択します

DeepSeekがV3.1を発表し、V3とR1をハイブリッド推論モデルに統合し、インテリジェンスを段階的に向上させる

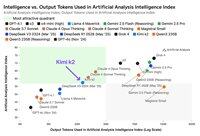

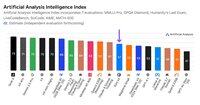

インテリジェンスの増加: DeepSeek V3.1 の初期ベンチマーク結果では、推論モードでの人工分析知能指数は R1 のスコア 59 から 60 に上昇しました。非推論モードでは、V3.1 は 49 のスコアを達成し、以前の V3 0324 スコアの 44 から大幅に増加しています。これにより、V3.1 (推論) はアリババの最新の Qwen3 235B 2507 (推論) に遅れをとっています - DeepSeek はリードを取り戻していません。

ハイブリッド推論: @deepseek_ai は初めてハイブリッド推論モデルに移行し、推論モードと非推論モードの両方をサポートします。DeepSeek の統合ハイブリッド推論モデルへの移行は、OpenAI、Anthropic、Google が採用したアプローチを模倣しています。ただし、興味深いことに、アリババは最近、Qwen3 2507推論モデルと指示モデルを個別にリリースし、Qwen3に好まれたハイブリッドアプローチを放棄しました。

関数呼び出し/ツールの使用: DeepSeek はモデルの関数呼び出しが改善されたと主張していますが、DeepSeek V3.1 は推論モード時の関数呼び出しをサポートしていません。これにより、エージェントのコーディングを含め、インテリジェンス要件を持つエージェントワークフローをサポートする能力が大幅に制限される可能性があります。

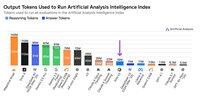

トークンの使用状況: DeepSeek V3.1 は、推論モードで DeepSeek R1 よりもスコアが徐々に高く、人工分析知能インデックスに使用する評価全体で使用するトークンの数がわずかに少なくなります。非推論モードでは、V3 0324 よりもわずかに多くのトークンを使用しますが、それでも独自の推論モードよりも数倍少ないです。

API: DeepSeekのファーストパーティAPIは、チャットエンドポイントと推論エンドポイントの両方で新しいDeepSeek V3.1モデルを提供するようになりました - </think> チャットテンプレートで最終思考トークンがモデルに提供されるかどうかを変更して、モデルが推論するかどうかを制御するだけです。

アーキテクチャ: DeepSeek V3.1 は、以前の V3 および R1 モデルとアーキテクチャ的に同一で、合計パラメータは 671B で、アクティブ パラメータは 37B です。

含意: このリリースが、噂では V4 または R2 と呼ばれる将来のモデルに向けた DeepSeek の進歩について何を意味するかについて仮定を立てる際には注意することをお勧めします。DeepSeek は以前、V3 リリースのわずか 2 週間前の 2024 年 12 月 10 日に V2 アーキテクチャに基づいて構築された最終モデルをリリースしていたことに注意してください。

71.02K

複数の長いドキュメント(~100kトークン)にわたる推論能力のテストを通じて長いコンテキストのパフォーマンスを評価する新しいベンチマークであるArtificial Analysis Long Context Reasoning(AA-LCR)を発表

AA-LCRの焦点は、実際の知識作業と推論タスクを再現し、ドキュメント分析、コードベースの理解、複雑なマルチステップワークフローにまたがる最新のAIアプリケーションに不可欠な機能をテストすることです。

AA-LCRは、~100kの入力トークンを表す複数の現実世界のドキュメントにわたる推論を必要とする100のハードテキストベースの質問です。質問は、答えを直接見つけることができず、複数の情報源から推論する必要があるように設計されており、人間のテストにより、各質問には検索ではなく真の推論が必要であることが検証されます。

重要なポイント:

➤ 今日の主要なモデルは~70%の精度を達成しています:上位3位はOpenAI o3(69%)、xAI Grok 4(68%)、Qwen3 235B 2507 Thinking(67%)です。

➤ 👀 gpt-oss の結果もすでにあります。120B は o4-mini (高) に近いパフォーマンスを発揮し、モデルのパフォーマンスに関する OpenAI の主張と一致しています。モデルのインテリジェンスインデックスをまもなくフォローアップする予定です。

➤ 7つのカテゴリのドキュメント(企業レポート、業界レポート、政府相談、学術、法律、マーケティング資料、調査レポート)にまたがる100のハードテキストベースの質問

➤ 質問ごとに~100Kの入力トークンがあり、このベンチマークでスコアを獲得するには、モデルが最低128Kのコンテキストウィンドウをサポートする必要があります

➤ ベンチマークを実行するための~230ドキュメントにまたがる合計~3Mの一意の入力トークン(出力トークンは通常、モデルによって異なります)

➤ @HuggingFace の🤗データセットへのリンクは以下のとおりです

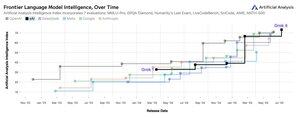

人工分析知能インデックスに AA-LCR を追加し、バージョン番号を v2.2 にします。Artificial Analysis Intelligence Index v2.2 には、MMLU-Pro、GPQA Diamond、AIME 2025、IFBench、LiveCodeBench、SciCode、AA-LCR が含まれるようになりました。

現在、すべての数字がサイトで更新されています。人工分析知能インデックス v2.2 👇 のモデルを確認する

28.75K

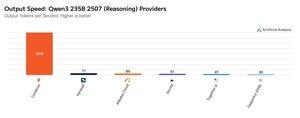

Cerebras は今週、大規模な MoE を非常に高速でホストする能力を実証しており、Qwen3 235B 2507 および Qwen3 Coder 480B エンドポイントを >1,500 出力トークン/秒で起動しました

➤ @CerebrasSystems は、Qwen3 235B 2507 推論と非推論の両方のエンドポイントを提供するようになりました。どちらのモデルも合計パラメータが 235B で、アクティブは 22B です。

➤ Qwen 3 235B 2507 Reasoning は、o4-mini (高) および DeepSeek R1 0528 に匹敵するインテリジェンスを提供します。Non-reasoning バリアントは、Kimi K2 に匹敵し、GPT-4.1 や Llama 4 Maverick をはるかに上回るインテリジェンスを提供します。

➤ Qwen3 Coder 480B には合計 480B のパラメータがあり、35B がアクティブです。このモデルはエージェントコーディングに特に強力で、Qwen3-Coder CLI を含むさまざまなコーディングエージェントツールで使用できます。

Cerebrasの発売は、このレベルのインテリジェンスがこのような出力速度で初めてアクセスできるようになったことを意味し、エージェントの各ステップに数分待たずに推論モデルを使用するなど、新しいユースケースを解き放つ可能性を秘めています。

25.22K

🇰🇷 LGは最近、EXAONE 4.0 32Bを発売しましたが、人工分析知能指数で62点を獲得し、32Bモデルとしてはこれまでで最高点となった

@LG_AI_Research の EXAONE 4.0 は、ここでベンチマーク結果を報告している 32B ハイブリッド推論モデルと、まだベンチマークしていないオンデバイス アプリケーション向けに設計された小型の 1.2B モデルの 2 つのバリエーションでリリースされています。

Upstage の最近の Solar Pro 2 リリースと並行して、韓国の AI ラボが米国と中国に加わり、インテリジェンス チャートのトップ近くにランクインするのはエキサイティングです。

主な結果:

➤ 🧠 EXAONE 4.0 32B (推論): 推論モードでは、EXAONE 4.0 は人工分析知能指数で 62 のスコアを獲得しています。これは、Claude 4 OpusとNVIDIAの新しいLlama Nemotron Super 49B v1.5に匹敵し、Gemini 2.5 Flashにわずか1ポイント差です

➤ ⚡ EXAONE 4.0 32B (非推論): 非推論モードでは、EXAONE 4.0 は人工分析知能指数で 51 のスコアを獲得します。合計パラメータは~1/4しかないにもかかわらず、知能の点ではラマ4マーベリックに匹敵します(ただし、アクティブなパラメータは~2倍です)。

➤ ⚙️ 出力トークンと冗長性: 推論モードでは、EXAONE 4.0 は人工分析知能インデックスに 100M 出力トークンを使用しました。これは他のフロンティアモデルよりも高いですが、Llama Nemotron Super 49B v1.5、Grok 4、Qwen3 235B 2507 Reasoningと同様に、より多くの出力トークンを使用して「もっと考える」推論モデルの最近の傾向と一致しています。非推論モードでは、EXAONE 4.0 は 15M トークンを使用しました - 非推論者としては高かったが、Kimi K2 の 30M ほど高くはありません。

主な詳細:

➤ハイブリッド推論:このモデルは、「推論」モードと「非推論」モードの間のオプションを提供します

➤ 可用性: 現在 @friendliai によってホストされており、FriendliAI によって 1M の入出力トークンあたり 1 ドルで競争力のある価格 (特に独自のオプションと比較して) で提供されています

➤ オープンウェイト: EXAONE 4.0 は、EXAONE AI モデル ライセンス契約 1.2 に基づいて利用可能なオープンウェイト モデルです。ライセンスは商用利用を制限しています。

➤マルチモダリティ:テキストのみの入力と出力

➤コンテキストウィンドウ:131kトークン

➤ パラメータ: 32B のアクティブおよび合計パラメータ、16 ビットおよび 8 ビットの精度で利用可能 (モデルを単一の H100 チップ上でフル精度で実行できることを意味します)

41.58K

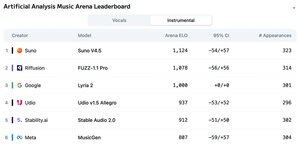

人工分析音楽アリーナリーダーボードの発表:>5k票を獲得したSuno v4.5は、RiffusionのFUZZ-1.1 Proがそれに続く主要な音楽生成モデルです。

Google の Lyria 2 はインストゥルメンタル リーダーボードで 3 位、Udio の v1.5 Allegro はボーカル リーダーボードで 3 位です。

インストゥルメンタルリーダーボードは次のとおりです。

🥇 @SunoMusic V4.5

🥈 @riffusionai ファズ-1.1プロ

🥉 @GoogleDeepMindリリア2

@udiomusic v1.5 Allegro

@StabilityAI安定したオーディオ2.0

@metaai MusicGen

ランキングは、さまざまなジャンルやプロンプトにわたるコミュニティの投票に基づいています。プロンプトを特集したいですか?今すぐアリーナでプロンプトを送信できます。

👇 ボーカルリーダーボードと参加リンクは以下をご覧ください!

22.21K

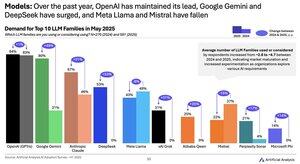

2024 年から 2025 年のモデル需要の変化: Google (+49pts)、DeepSeek (+53pts)、xAI (+31pts) は、過去 1 年間で需要シェアの大幅な増加を達成しました

@Googleは、Gemini モデル シリーズを使用または検討している回答者の割合が ~2.5 倍増加し、AI の遅れから AI リーダーに移行しました。その主な原動力は、Googleがインテリジェンスで大幅な進歩を遂げたことです:Gemini 2.5 Proは、2024年初頭にはOpenAIやAnthropicに大きく遅れをとっていたのに対し、人工分析知能指数で#3にランクインしています。

@deepseek_ai 2024 年上半期には、採用が限定的で、Llama 3 70B のパフォーマンスを下回るモデルである DeepSeek 67B のみをリリースしました。DeepSeek は、2024 年後半に V2 モデルのリリースで最初にある程度の普及が見られ、その後 2025 年初頭に V3 および R1 モデルで急速に採用され、オープンウェイト モデルの中でリーダーになりました。

@xai は 2024 年上半期半ばに最初のモデル Grok-1 をリリースし、それ以来、連続したリリースですべてのモデルでインテリジェンスのリーダーシップに急速に上り詰め、先週の Grok 4 の発売で最高潮に達しました。

出典:Artificial Analysis AI Adoption Survey H1 2025 (レポートは Artificial Analysis の Web サイトで入手可能)

389.06K

Kimi K2プロバイダー:Groqは、MoonshotのファーストパーティAPIよりも40倍速い>400出力トークン/秒でKimi K2を提供しています

@GroqInc、@basetenco、@togethercompute、@FireworksAI_HQ、@parasail_io、@novita_labs、@DeepInfra、そしてもちろん@Kimi_Moonshotなど、Kimi K2のAPIを迅速に立ち上げた多くのプロバイダーにおめでとうございます。これは、合計 1 兆個のパラメーターというモデルのサイズを考えると、印象的です。

Groqは、超高速で際立っています。DeepInfra、Novita、Basetenは、MoonshotのファーストパーティAPIと同等またはそれ以上に安い価格設定をしている唯一のプロバイダーであり、その価格設定で際立っています。

プロバイダー間の詳細な比較については、以下を参照してください。チームがK2モデルに最適化するにつれて、一部のプロバイダーで速度が急速に向上すると予想しています - 以下の数値は過去72時間の速度の中央値を示していますが、今日の測定ではすでにDeepInfraが最大62トークン/秒に跳ね上がっていることがわかります

52.33K

Moonshot AI の Kimi k2 は、人工分析知能指数で主要なオープンウェイト非推論モデルですが、他の非推論モデルよりも ~3 倍多くのトークンを出力し、推論と非推論の境界線を曖昧にしています

Kimi k2 は、これまでで最大のメジャー オープン ウェイト モデルです - 合計 1T のパラメーターで 32B がアクティブです (ウェイトを保持するには、ネイティブ FP8 で 1TB の大容量メモリが必要です)。人工分析知能指数の k2 は 57 で、GPT-4.1 や DeepSeek V3 などのモデルを上回る印象的なスコアですが、主要な推論モデルには遅れをとっています。

これまで、私たちの評価では、推論モデルと非推論モデルの間に明確な区別があり、モデルがタグを使用するかどうかだけでなく<reasoning>、主にトークンの使用によって定義されてきました。Artificial Analysis Intelligence Indexのすべての評価に回答するために使用されるトークン数の中央値は、推論モデルでは非推論モデルよりも~10倍高くなっています。

@Kimi_MoonshotのKimi k2は、中央値の非推論モデルが使用するトークン数の~3倍を使用します。そのトークン使用量は、最大予算拡張思考モードで実行した場合、Claude 4 Sonnet と Opus よりも最大 30% しか低くなく、推論をオフにした場合の Claude 4 Sonnet と Opus の両方のトークン使用量のほぼ 3 倍です。

したがって、Kimi k2 は、Claude 4 モデルの非推論スコアではなく、最大予算拡張思考モードで Claude 4 Sonnet および Opus と比較することをお勧めします。

Kimi k2 は、@Kimi_Moonshot のファーストパーティ API のほか、@FireworksAI_HQ、@togethercompute、@novita_labs、@parasail_io でも利用できます。

さらなる分析👇については、以下および人工分析を参照してください

60.64K

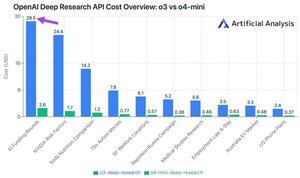

OpenAI の新しい Deep Research API の費用は、API 呼び出しごとに最大 ~30 ドルです。これらの新しいDeep Research APIエンドポイントは、お金を使うための新しい最速の方法かもしれません

10 件の詳細な調査テスト クエリで、o3 に 100 ドル、o4-mini に 9.18 ドルを費やしました。なぜコストがこれほど大きくなるのでしょうか?高価格と数百万のトークン。

これらのエンドポイントは、詳細な研究タスクのためにRL化されたo3およびo4-miniのバージョンです。API 経由で利用できるため、OpenAI の Web 検索ツールとリモート MCP サーバー経由のカスタム データ ソースの両方で使用できます。

O4-mini-Deep-Researchの価格は、O3-Deep-Researchの価格よりも5倍安いです。テストクエリでは、o4-miniは使用するトークンも少ないようで、10のテストクエリで合計で10倍以上安くなっています。

プライシング:

➤ o3-deep-research の価格は、入力 10 ドル /M (キャッシュ入力 2.50 ドル)、出力 40 ドルです

➤ o4-mini-deep-research の価格は、入力 2 ドル /M (キャッシュ入力 0.5 ドル)、出力 8 ドルです。

これらのエンドポイントはどちらも、OpenAI の標準の o3 および o4-mini エンドポイントよりも大幅に高価です。

➤ o3: $2 /M ($0.5 キャッシュ) 入力、o3 の場合は $8 /M 出力

➤ o4-mini: $1.1 /M (0.275 キャッシュ) 入力、$4.4 /M 出力

37.36K

トップ

ランキング

お気に入り

Trending onchain

Trending on X

Recent top fundings

Most notable