熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

Artificial Analysis

獨立分析 AI 模型和託管供應商 - 為您的用例選擇最佳模型和 API 供應商

DeepSeek推出V3.1,將V3和R1統一為一個混合推理模型,智能水平逐步提升

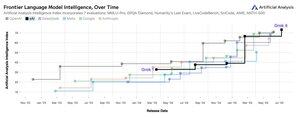

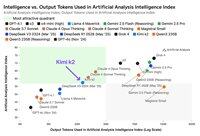

智能水平逐步提升:DeepSeek V3.1的初步基準測試結果顯示,推理模式下的人工分析智能指數為60,較R1的59有所上升。在非推理模式下,V3.1的得分為49,較早期的V3 0324得分44有了更大的提升。這使得V3.1(推理)落後於阿里巴巴最新的Qwen3 235B 2507(推理)——DeepSeek尚未重新奪回領先地位。

混合推理:@deepseek_ai首次採用混合推理模型,支持推理和非推理模式。DeepSeek轉向統一的混合推理模型模仿了OpenAI、Anthropic和Google的做法。然而,值得注意的是,阿里巴巴最近放棄了他們之前偏好的混合方法,分別發布了Qwen3 2507推理和指令模型。

功能調用/工具使用:雖然DeepSeek聲稱模型的功能調用有所改善,但DeepSeek V3.1在推理模式下不支持功能調用。這可能會大大限制其支持具有智能要求的代理工作流程的能力,包括在編碼代理中的應用。

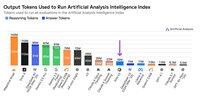

令牌使用:DeepSeek V3.1在推理模式下的得分比DeepSeek R1略高,並且在我們用於人工分析智能指數的評估中使用的令牌略少。在非推理模式下,它使用的令牌比V3 0324略多——但仍然是其推理模式使用的令牌的幾倍。

API:DeepSeek的第一方API現在在他們的聊天和推理端點上服務於新的DeepSeek V3.1模型——只需在聊天模板中更改是否提供結束思考</think>令牌,以控制模型是否進行推理。

架構:DeepSeek V3.1在架構上與之前的V3和R1模型完全相同,具有671B的總參數和37B的活躍參數。

影響:我們建議在對這一發布所暗示的DeepSeek在未來模型(傳聞稱為V4或R2)進展方面做出任何假設時保持謹慎。我們注意到,DeepSeek之前在2024年12月10日發布了基於其V2架構的最終模型,僅在發布V3的兩週前。

71.1K

宣布人工分析長文推理(AA-LCR),這是一個新的基準,用於通過測試多個長文檔中的推理能力來評估長文檔性能(約100k個標記)

AA-LCR的重點是複製真實的知識工作和推理任務,測試對於現代AI應用至關重要的能力,涵蓋文檔分析、代碼庫理解和複雜的多步工作流程。

AA-LCR包含100個基於文本的困難問題,這些問題需要在多個現實世界文檔中進行推理,代表約100k個輸入標記。問題的設計使得答案無法直接找到,而必須從多個信息來源中推理出來,並且人類測試驗證每個問題都需要真正的推斷,而不是檢索。

關鍵要點:

➤ 當前領先的模型達到約70%的準確率:前三名分別是OpenAI o3(69%)、xAI Grok 4(68%)和Qwen3 235B 2507 Thinking(67%)

➤👀 我們也已經有gpt-oss的結果!120B的表現接近o4-mini(高),與OpenAI關於模型性能的聲明一致。我們將很快跟進模型的智能指數。

➤ 100個基於文本的困難問題,涵蓋7類文檔(公司報告、行業報告、政府諮詢、學術界、法律、營銷材料和調查報告)

➤ 每個問題約100k個輸入標記,要求模型支持至少128K的上下文窗口才能在此基準上得分

➤ 約300萬個獨特的輸入標記,涵蓋約230個文檔以運行基準(輸出標記通常因模型而異)

➤ 下面是🤗 @HuggingFace上的數據集鏈接

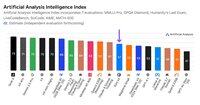

我們將AA-LCR添加到人工分析智能指數中,並將版本號提升至v2.2。人工分析智能指數v2.2現在包括:MMLU-Pro、GPQA Diamond、AIME 2025、IFBench、LiveCodeBench、SciCode和AA-LCR。

所有數字現在已在網站上更新。查看哪些模型在人工分析智能指數v2.2中表現良好👇

28.79K

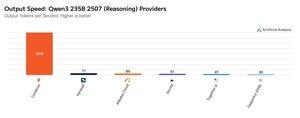

Cerebras 本週一直在展示其以非常高的速度託管大型 MoE 的能力,以 >1,500 個輸出令牌/秒的速度推出 Qwen3 235B 2507 和 Qwen3 Coder 480B 端點

➤ @CerebrasSystems現在提供 Qwen3 235B 2507 推理和非推理的端點。兩種型號的總參數均為 235B,其中 22B 處於活動狀態。

➤ Qwen 3 235B 2507 Reasoning 提供可與 o4-mini(高)和 DeepSeek R1 0528 相媲美的智能。非推理變體提供的智能可與 Kimi K2 相媲美,遠高於 GPT-4.1 和 Llama 4 Maverick。

➤ Qwen3 Coder 480B 總參數為 480B,其中 35B 處於活動狀態。該模型對於代理編碼特別強大,可用於各種編碼代理工具,包括 Qwen3-Coder CLI。

Cerebras 的推出代表了這種智能水平首次以這樣的輸出速度實現,並有可能解鎖新的用例——例如為代理的每個步驟使用推理模型,而無需等待幾分鐘。

25.28K

🇰🇷 LG 最近推出了 EXAONE 4.0 32B - 在人工分析智能指數上得分 62,這是迄今為止 32B 型號的最高分數。

@LG_AI_Research 的 EXAONE 4.0 有兩個變體:我們在此報告基準測試結果的 32B 混合推理模型,以及一個為設備應用設計的小型 1.2B 模型,我們尚未對其進行基準測試。

隨著 Upstage 最近發布的 Solar Pro 2,看到韓國 AI 實驗室與美國和中國一起接近智能排行榜的頂端,令人興奮。

關鍵結果:

➤ 🧠 EXAONE 4.0 32B(推理):在推理模式下,EXAONE 4.0 在人工分析智能指數上得分 62。這與 Claude 4 Opus 和 NVIDIA 的新 Llama Nemotron Super 49B v1.5 相匹配,僅比 Gemini 2.5 Flash 低 1 分。

➤ ⚡ EXAONE 4.0 32B(非推理):在非推理模式下,EXAONE 4.0 在人工分析智能指數上得分 51。儘管總參數僅約為 1/4,但在智能上與 Llama 4 Maverick 相匹配(雖然活躍參數約為 2 倍)。

➤ ⚙️ 輸出標記和冗長性:在推理模式下,EXAONE 4.0 使用了 100M 輸出標記來計算人工分析智能指數。這比其他一些前沿模型高,但與最近推理模型使用更多輸出標記以「思考更多」的趨勢一致 - 類似於 Llama Nemotron Super 49B v1.5、Grok 4 和 Qwen3 235B 2507 推理。在非推理模式下,EXAONE 4.0 使用了 15M 標記 - 對於非推理者來說算是高,但不及 Kimi K2 的 30M。

關鍵細節:

➤ 混合推理:該模型在「推理」模式和「非推理」模式之間提供選擇性。

➤ 可用性:目前由 @friendliai 托管,並且由 FriendliAI 以每 1M 輸入和輸出標記 1 美元的價格具有競爭力(尤其是與專有選項相比)。

➤ 開放權重:EXAONE 4.0 是一個開放權重模型,根據 EXAONE AI 模型許可協議 1.2 提供。該許可限制商業使用。

➤ 多模態:僅支持文本輸入和輸出。

➤ 上下文窗口:131k 標記。

➤ 參數:32B 活躍和總參數,提供 16 位和 8 位精度(這意味著該模型可以在單個 H100 芯片上以全精度運行)。

41.64K

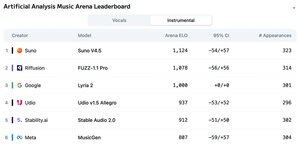

宣布人工分析音樂競技場排行榜:擁有超過5000票的Suno v4.5是領先的音樂生成模型,緊隨其後的是Riffusion的FUZZ-1.1 Pro。

Google的Lyria 2在我們的器樂排行榜中名列第三,而Udio的v1.5 Allegro在我們的聲樂排行榜中名列第三。

器樂排行榜如下:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

排名基於社區在多樣化的音樂類型和提示中的投票。想要看到你的提示被展示嗎?你今天可以在競技場提交提示。

👇 下面是聲樂排行榜和參與鏈接!

22.27K

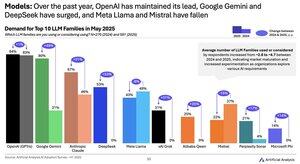

2024 年至 2025 年模型需求變化:谷歌(+49 點)、DeepSeek(+53 點)和 xAI(+31 點)在過去一年中實現了需求份額的大幅增長

@Google 已從人工智慧落後者轉變為人工智慧領導者,使用或考慮 Gemini 模型系列的受訪者比例增加了 ~2.5 倍。其中一個關鍵驅動因素是谷歌在智能方面取得了顯著進展:Gemini 2.5 Pro 目前在我們的人工智能分析智能指數中排名 #3,而 2024 年初明顯落後於 OpenAI 和 Anthropic。

@deepseek_ai 在 2024 年上半年僅發布了 DeepSeek 67B,該型號採用率有限,表現不如 Llama 3 70B。DeepSeek 首先在 2024 年底隨著 V2 模型的發布而獲得一些採用,然後在 2025 年初隨著 V3 和 R1 模型的迅速採用,這使他們在開放重量模型中處於領先地位。

@xai於 2024 年上半年中期發布了首款型號 Grok-1,此後迅速攀升至所有型號的智能領先地位,並陸續發布,最終在上週推出了 Grok 4。

資料來源:Artificial Analysis AI 採用調查 2025 年上半年(報告可在 Artificial Analysis 網站上取得)

389.12K

Kimi K2 供應商:Groq 的輸出速度超過 400 個標記/秒,比 Moonshot 的第一方 API 快 40 倍。

恭喜多家供應商迅速推出 Kimi K2 的 API,包括 @GroqInc、@basetenco、@togethercompute、@FireworksAI_HQ、@parasail_io、@novita_labs、@DeepInfra,當然還有 @Kimi_Moonshot。考慮到模型的大小達到 1 兆個參數,這實在令人印象深刻。

Groq 以其驚人的速度脫穎而出。DeepInfra、Novita 和 Baseten 以其定價而著稱,成為唯一與 Moonshot 的第一方 API 定價相似或更便宜的供應商。

請參見下方供應商之間的進一步比較。我們預期隨著團隊對 K2 模型的優化,某些供應商的速度將迅速提升 - 我們下面的數據顯示過去 72 小時的中位數速度,但我們已經看到 DeepInfra 在今天的測量中跳升至 62 個標記/秒。

52.4K

雖然 Moonshot AI 的 Kimi k2 是人工智慧分析智慧指數中領先的開放權重非推理模型,但它輸出的代幣數量是其他非推理模型的 ~3 倍,模糊了推理與非推理之間的界線

Kimi k2 是迄今為止最大的主要開放權重模型 - 總參數為 1T,活動容量為 32B(這需要原生 FP1 的 8TB 大內存來保持權重)。我們在人工智慧分析智慧指數中的 k2 為 57,這是一個令人印象深刻的分數,使其高於 GPT-4.1 和 DeepSeek V3 等模型,但落後於領先的推理模型。

到目前為止,在我們的評估中,推理模型和非推理模型之間已經有明顯的區別——不僅由模型是否使用<reasoning>標籤來定義,而且主要由標記使用來定義。用於回答人工智慧分析智慧指數中所有評估的標記數量中位數,推理模型比非推理模型高 ~10 倍。

@Kimi_Moonshot 的 Kimi k2 使用的標記數量是中位數非推理模型使用的標記數量的 ~3 倍。當以最大預算擴展思維模式運行時,其令牌使用量僅比 Claude 4 Sonnet 和 Opus 低 30%,並且幾乎是 Claude 4 Sonnet 和 Opus 在關閉推理的情況下的令牌使用量的三倍。

因此,我們建議將 Kimi k2 與 Claude 4 Sonnet 和 Opus 在最大預算擴展思維模式下進行比較,而不是與 Claude 4 模型的非推理分數進行比較。

Kimi k2 可在 @Kimi_Moonshot 的第一方 API 以及 @FireworksAI_HQ、@togethercompute、@novita_labs 和 @parasail_io 上使用。

請參閱下文和人工分析以進行進一步分析 👇

60.7K

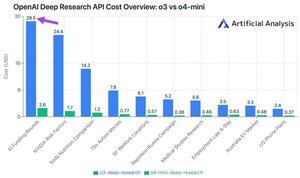

OpenAI 的新深度研究 API 每次 API 調用費用高達 ~30 美元!這些新的深度研究 API 端點可能只是新的最快的花錢方式

在我們的 10 個深入研究測試查詢中,我們在 o100 上花費了 3 美元,在 o9.18-mini 上花費了 4 美元。成本怎麼會變得這麼大?高價和數百萬代幣。

這些端點是 o3 和 o4-mini 的版本,已針對深度研究任務進行了 RL。通過 API 提供,它們可以通過遠程 MCP 服務器與 OpenAI 的網絡搜索工具和自定義數據源一起使用。

O4-mini-Deep-Research 的定價比 O3-Deep-Research 定價低 5 倍。在我們的測試查詢中,o4-mini 似乎也使用了更少的令牌 - 在我們的 10 個測試查詢中,它的總成本降低了 10 倍以上。

定價:

➤ o3-deep-research 定價為 10 美元/月輸入(2.50 美元快取輸入),40 美元/月輸出

➤ O4-mini-deep-research 定價為 2 美元/月輸入(0.5 美元快取輸入)、8 美元/月輸出

這些端點都比 OpenAI 的標準 o3 和 o4-mini 端點貴得多 - 它們位於:

➤ o3:2 美元/月(緩存 0.5 美元)輸入,o3 8 美元/月輸出

➤ o4-mini:1.1 美元/月(0.275 緩存)輸入,4.4 美元/月輸出

37.42K

熱門

排行

收藏

鏈上熱點

X 熱門榜

近期融資

最受認可