Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Niezależna analiza modeli AI i dostawców usług hostingowych - wybierz najlepszego dostawcę modelu i API dla swojego przypadku użycia

DeepSeek uruchamia V3.1, łącząc V3 i R1 w hybrydowy model rozumowania z stopniowym wzrostem inteligencji

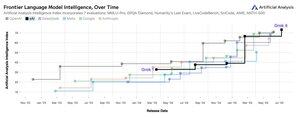

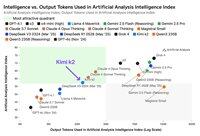

Stopniowy wzrost inteligencji: Wstępne wyniki benchmarków dla DeepSeek V3.1 pokazują wskaźnik Inteligencji Analizy Sztucznej na poziomie 60 w trybie rozumowania, w porównaniu do wyniku R1 wynoszącego 59. W trybie nie-rozumowania V3.1 osiąga wynik 49, co stanowi większy wzrost w porównaniu do wcześniejszego wyniku V3 0324 wynoszącego 44. To pozostawia V3.1 (rozumienie) za najnowszym Qwen3 235B 2507 Alibaba (rozumienie) - DeepSeek nie odzyskał prowadzenia.

Hybrydowe rozumowanie: @deepseek_ai po raz pierwszy przeszedł na hybrydowy model rozumowania - wspierając zarówno tryby rozumowania, jak i nie-rozumowania. Przejście DeepSeek na zjednoczony hybrydowy model rozumowania naśladuje podejście przyjęte przez OpenAI, Anthropic i Google. Warto jednak zauważyć, że Alibaba niedawno porzucił swoje preferencje dotyczące hybrydowego podejścia dla Qwen3, wydając osobno modele rozumowania i instrukcji Qwen3 2507.

Wywoływanie funkcji / użycie narzędzi: Chociaż DeepSeek twierdzi, że poprawił wywoływanie funkcji dla modelu, DeepSeek V3.1 nie obsługuje wywoływania funkcji w trybie rozumowania. Prawdopodobnie znacznie ograniczy to jego zdolność do wspierania agentowych przepływów pracy z wymaganiami inteligencji, w tym w agentach kodujących.

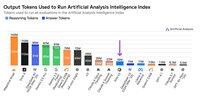

Użycie tokenów: DeepSeek V3.1 osiąga stopniowo wyższe wyniki w trybie rozumowania niż DeepSeek R1 i używa nieco mniej tokenów w ocenach, które wykorzystujemy do wskaźnika Inteligencji Analizy Sztucznej. W trybie nie-rozumowania używa nieco więcej tokenów niż V3 0324 - ale wciąż kilka razy mniej niż w swoim własnym trybie rozumowania.

API: Pierwsze API DeepSeek teraz obsługuje nowy model DeepSeek V3.1 zarówno na ich punktach końcowych czatu, jak i rozumowania - wystarczy zmienić, czy token końcowy myślenia </think> jest dostarczany do modelu w szablonie czatu, aby kontrolować, czy model będzie rozumował.

Architektura: DeepSeek V3.1 jest architektonicznie identyczny z wcześniejszymi modelami V3 i R1, z 671B całkowitych parametrów i 37B aktywnych parametrów.

Implikacje: Zalecamy ostrożność w formułowaniu jakichkolwiek założeń dotyczących tego, co ta wersja implikuje na temat postępów DeepSeek w kierunku przyszłego modelu, który w plotkach nazywany jest V4 lub R2. Zauważamy, że DeepSeek wcześniej wydał ostateczny model zbudowany na swojej architekturze V2 10 grudnia 2024 roku, zaledwie dwa tygodnie przed wydaniem V3.

71,07K

Ogłaszamy Artificial Analysis Long Context Reasoning (AA-LCR), nowy benchmark do oceny wydajności w długim kontekście poprzez testowanie zdolności rozumowania w wielu długich dokumentach (~100k tokenów)

Celem AA-LCR jest odwzorowanie rzeczywistej pracy wiedzy i zadań rozumowania, testując zdolności krytyczne dla nowoczesnych aplikacji AI obejmujących analizę dokumentów, zrozumienie kodu oraz złożone wieloetapowe przepływy pracy.

AA-LCR to 100 trudnych pytań opartych na tekście, które wymagają rozumowania w oparciu o wiele rzeczywistych dokumentów reprezentujących ~100k tokenów wejściowych. Pytania są zaprojektowane w taki sposób, aby odpowiedzi nie mogły być bezpośrednio znalezione, lecz muszą być wywnioskowane z wielu źródeł informacji, przy czym testy przeprowadzane przez ludzi weryfikują, że każde pytanie wymaga prawdziwego wnioskowania, a nie tylko wyszukiwania.

Kluczowe informacje:

➤ Dzisiejsze wiodące modele osiągają ~70% dokładności: pierwsze trzy miejsca zajmują OpenAI o3 (69%), xAI Grok 4 (68%) oraz Qwen3 235B 2507 Thinking (67%)

➤👀 Mamy już również wyniki gpt-oss! 120B osiąga wyniki bliskie o4-mini (wysokie), zgodnie z twierdzeniami OpenAI dotyczącymi wydajności modeli. Wkrótce przedstawimy Indeks Inteligencji dla modeli.

➤ 100 trudnych pytań opartych na tekście obejmujących 7 kategorii dokumentów (Raporty Firmowe, Raporty Branżowe, Konsultacje Rządowe, Akademia, Prawo, Materiały Marketingowe i Raporty z Badań)

➤ ~100k tokenów wejściowych na pytanie, wymagające od modeli wsparcia dla minimalnego okna kontekstowego 128K, aby uzyskać wynik w tym benchmarku

➤ ~3M unikalnych tokenów wejściowych obejmujących ~230 dokumentów do przeprowadzenia benchmarku (tokeny wyjściowe zazwyczaj różnią się w zależności od modelu)

➤ Link do zestawu danych na 🤗 @HuggingFace znajduje się poniżej

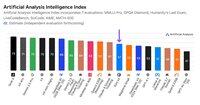

Dodajemy AA-LCR do Indeksu Inteligencji Artificial Analysis i podnosimy numer wersji do v2.2. Indeks Inteligencji Artificial Analysis v2.2 teraz obejmuje: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode i AA-LCR.

Wszystkie liczby są teraz zaktualizowane na stronie. Sprawdź, które modele znajdują się w Indeksie Inteligencji Artificial Analysis v2.2 👇

28,78K

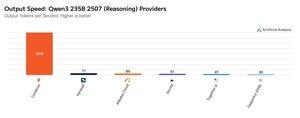

Cerebras demonstruje swoją zdolność do hostowania dużych MoEs z bardzo wysokimi prędkościami w tym tygodniu, uruchamiając punkty końcowe Qwen3 235B 2507 i Qwen3 Coder 480B przy >1,500 tokenów wyjściowych/s

➤ @CerebrasSystems teraz oferuje punkty końcowe zarówno dla Qwen3 235B 2507 Reasoning, jak i Non-reasoning. Oba modele mają łącznie 235B parametrów, z 22B aktywnymi.

➤ Qwen 3 235B 2507 Reasoning oferuje inteligencję porównywalną z o4-mini (wysoka) i DeepSeek R1 0528. Wariant Non-reasoning oferuje inteligencję porównywalną z Kimi K2 i znacznie wyższą niż GPT-4.1 oraz Llama 4 Maverick.

➤ Qwen3 Coder 480B ma łącznie 480B parametrów, z 35B aktywnymi. Ten model jest szczególnie silny w zakresie kodowania agentowego i może być używany w różnych narzędziach dla agentów kodujących, w tym w Qwen3-Coder CLI.

Uruchomienia Cerebras reprezentują pierwszy raz, gdy ten poziom inteligencji jest dostępny przy tych prędkościach wyjściowych i mają potencjał do odblokowania nowych zastosowań - jak użycie modelu reasoning dla każdego kroku agenta bez konieczności czekania minut.

25,27K

🇰🇷 LG niedawno wprowadziło EXAONE 4.0 32B - uzyskuje 62 punkty w Indeksie Sztucznej Analizy Inteligencji, co jest najwyższym wynikiem dla modelu 32B do tej pory.

EXAONE 4.0 @LG_AI_Research jest dostępne w dwóch wariantach: modelu hybrydowego 32B, dla którego raportujemy wyniki benchmarków, oraz mniejszego modelu 1.2B zaprojektowanego do aplikacji na urządzeniach, którego jeszcze nie testowaliśmy.

Wraz z niedawnym wydaniem Solar Pro 2 od Upstage, ekscytujące jest widzieć koreańskie laboratoria AI dołączające do USA i Chin w czołówce wykresów inteligencji.

Kluczowe wyniki:

➤ 🧠 EXAONE 4.0 32B (Rozumowanie): W trybie rozumowania EXAONE 4.0 uzyskuje 62 punkty w Indeksie Sztucznej Analizy Inteligencji. To odpowiada Claude 4 Opus i nowemu Llama Nemotron Super 49B v1.5 od NVIDIA, a tylko 1 punkt za Gemini 2.5 Flash.

➤ ⚡ EXAONE 4.0 32B (Bez rozumowania): W trybie bez rozumowania EXAONE 4.0 uzyskuje 51 punktów w Indeksie Sztucznej Analizy Inteligencji. Odpowiada Llama 4 Maverick pod względem inteligencji, mimo że ma tylko ~1/4 całkowitych parametrów (chociaż ma ~2x aktywnych parametrów).

➤ ⚙️ Tokeny wyjściowe i obszerność: W trybie rozumowania EXAONE 4.0 użyło 100M tokenów wyjściowych dla Indeksu Sztucznej Analizy Inteligencji. To więcej niż w niektórych innych modelach granicznych, ale zgadza się z ostatnimi trendami modeli rozumujących, które używają więcej tokenów wyjściowych, aby 'myśleć więcej' - podobnie jak Llama Nemotron Super 49B v1.5, Grok 4 i Qwen3 235B 2507 Reasoning. W trybie bez rozumowania EXAONE 4.0 użyło 15M tokenów - dużo jak na model bez rozumowania, ale nie tak dużo jak 30M Kimi K2.

Kluczowe szczegóły:

➤ Hybrydowe rozumowanie: Model oferuje opcjonalność między trybem 'rozumowania' a 'bez rozumowania'.

➤ Dostępność: Obecnie hostowane przez @friendliai i konkurencyjnie wycenione (szczególnie w porównaniu do opcji własnościowych) przez FriendliAI na 1 USD za 1M tokenów wejściowych i wyjściowych.

➤ Otwarte wagi: EXAONE 4.0 to model z otwartymi wagami dostępny na podstawie Umowy Licencyjnej Modelu AI EXAONE 1.2. Licencja ogranicza użycie komercyjne.

➤ Multimodalność: Tylko tekstowe wejście i wyjście.

➤ Okno kontekstowe: 131k tokenów.

➤ Parametry: 32B aktywnych i całkowitych parametrów, dostępnych w precyzji 16bit i 8bit (co oznacza, że model może być uruchamiany na pojedynczym chipie H100 w pełnej precyzji).

41,63K

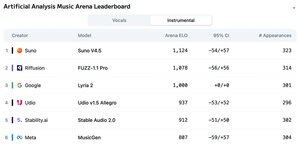

Ogłaszamy ranking Artificial Analysis Music Arena: z ponad 5 tys. głosów, Suno v4.5 jest wiodącym modelem generacji muzyki, a za nim znajduje się FUZZ-1.1 Pro od Riffusion.

Lyria 2 od Google zajmuje trzecie miejsce w naszym rankingu instrumentalnym, a v1.5 Allegro od Udio zajmuje trzecie miejsce w naszym rankingu wokalnym.

Ranking Instrumentalny przedstawia się następująco:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

Ranking oparty jest na głosach społeczności w różnych gatunkach i na różnorodnych promptach. Chcesz, aby twój prompt został wyróżniony? Możesz przesłać prompt w arenie już dziś.

👇 Zobacz poniżej ranking wokalny i link do udziału!

22,25K

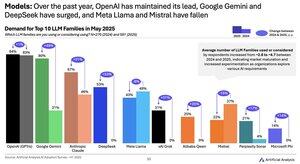

Zmiana popytu modelowego w latach 2024-2025: Google (+49 pkt), DeepSeek (+53 pkt) i xAI (+31 pkt) osiągnęły w ciągu ostatniego roku ogromny wzrost udziału w popycie

@Google przekształciła się z marudera w dziedzinie sztucznej inteligencji w lidera w dziedzinie sztucznej inteligencji z ~2,5-krotnym wzrostem odsetka respondentów korzystających lub rozważających serię modeli Gemini. Kluczowym czynnikiem napędzającym było to, że Google poczynił znaczne postępy w zakresie inteligencji: Gemini 2.5 Pro znajduje się teraz na #3 w naszym indeksie inteligencji analizy sztucznej inteligencji, w porównaniu do znacznego pozostawania w tyle za OpenAI i Anthropic na początku 2024 roku.

@deepseek_ai w I połowie 2024 r. wypuścił tylko DeepSeek 67B, model, który spotkał się z ograniczoną adopcją i osiągał gorsze wyniki niż Llama 3 70B. DeepSeek po raz pierwszy odnotował pewne zainteresowanie pod koniec 2024 r. wraz z wypuszczeniem modelu V2, a następnie odnotował szybką adopcję na początku 2025 r. dzięki modelom V3 i R1, które wyniosły je na pozycję lidera wśród modeli o otwartych ciężarach.

@xai wypuściła swój pierwszy model Grok-1 w połowie I półrocza 2024 roku i od tego czasu szybko wspięła się na pozycję lidera wywiadu we wszystkich modelach z kolejnymi wydaniami, czego kulminacją była premiera Grok 4 w zeszłym tygodniu.

Źródło: Artificial Analysis AI Adoption Survey H1 2025 (raport dostępny na stronie Artificial Analysis)

389,1K

Dostawcy Kimi K2: Groq obsługuje Kimi K2 z prędkością >400 tokenów/s, 40 razy szybciej niż API pierwszej strony Moonshot.

Gratulacje dla wielu dostawców za szybkie uruchomienie API dla Kimi K2, w tym @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra, a oczywiście @Kimi_Moonshot. To imponujące, biorąc pod uwagę rozmiar modelu wynoszący 1 bilion parametrów.

Groq wyróżnia się błyskawiczną prędkością. DeepInfra, Novita i Baseten wyróżniają się cenami, będąc jedynymi dostawcami, którzy wyceniają podobnie lub taniej niż API pierwszej strony Moonshot.

Zobacz poniżej dalsze porównania między dostawcami. Oczekujemy szybkiego wzrostu prędkości u niektórych dostawców, gdy zespoły optymalizują model K2 - nasze dane poniżej pokazują mediany prędkości z ostatnich 72 godzin, ale już widzimy, że DeepInfra skoczył do 62 tokenów/s w dzisiejszych pomiarach.

52,38K

Podczas gdy Kimi k2 firmy Moonshot AI jest wiodącym modelem bez rozumowania o otwartych wagach w Indeksie Sztucznej Inteligencji Analizy, generuje ~ 3 razy więcej tokenów niż inne modele nierozumujące, zacierając granice między rozumowaniem a nierozumowaniem

Kimi k2 to największy jak dotąd model dużych otwartych odważników - 1T łącznych parametrów przy 32B aktywnych (wymaga to ogromnego 1 TB pamięci w natywnym FP8 do utrzymania mas). Mamy k2 na 57 miejscu w Artificial Analysis Intelligence Index, imponujący wynik, który plasuje go powyżej modeli takich jak GPT-4.1 i DeepSeek V3, ale za wiodącymi modelami rozumowania.

Do tej pory w naszych ewaluacjach istniało wyraźne rozróżnienie między modelem rozumowania a modelami nierozumującymi - definiowanymi nie tylko przez to, czy model używa <reasoning> tagów, ale przede wszystkim przez użycie tokenów. Mediana liczby tokenów używanych do udzielenia odpowiedzi na wszystkie oceny w Indeksie Sztucznej Analizy Inteligencji jest ~10 razy wyższa dla modeli rozumujących niż dla modeli bez rozumowania.

@Kimi_Moonshot's Kimi k2 zużywa ~3 razy więcej tokenów niż mediana modelu nierozumującego. Jego użycie tokenów jest tylko do 30% niższe niż Claude 4 Sonnet i Opus, gdy są uruchomione w trybie myślenia o maksymalnym budżecie rozszerzonym i jest prawie trzykrotnie większe niż użycie tokenów zarówno Claude 4 Sonnet, jak i Opus z wyłączonym rozumowaniem.

Dlatego zalecamy, aby Kimi k2 był porównywany z Claude 4 Sonnet i Opus w ich maksymalnie budżetowych rozszerzonych trybach myślenia, a nie z nieuzasadnionymi wynikami dla modeli Claude 4.

Kimi k2 jest dostępny w interfejsie API @Kimi_Moonshot firmy first-party, a także w @FireworksAI_HQ, @togethercompute, @novita_labs i @parasail_io.

Zobacz poniżej i na Sztuczna analiza w celu dalszej analizy 👇

60,68K

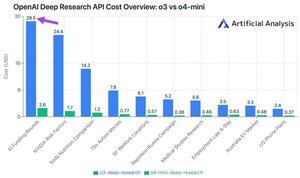

Nowy interfejs API Deep Research firmy OpenAI kosztuje do ~30 USD za wywołanie API! Te nowe punkty końcowe interfejsu API Deep Research mogą być po prostu nowym najszybszym sposobem wydawania pieniędzy

W naszych 10 zapytaniach testowych Deep Research wydaliśmy 100 USD na o3 i 9,18 USD na o4-mini. Jak to się dzieje, że koszty są tak duże? Wysokie ceny i miliony tokenów.

Te punkty końcowe są wersjami o3 i o4-mini, które zostały zweryfikowane na potrzeby głębokich zadań badawczych. Dostępność za pośrednictwem interfejsu API pozwala na korzystanie z nich zarówno z wyszukiwarką internetową OpenAI, jak i niestandardowymi źródłami danych za pośrednictwem zdalnych serwerów MCP.

Ceny O4-Mini-Deep-Research są 5 razy niższe niż ceny O3-Deep-Research. W naszych zapytaniach testowych o4-mini wydaje się również używać mniej tokenów - jest w sumie ponad 10 razy tańszy w naszych 10 zapytaniach testowych.

Ceny:

➤ o3-deep-research jest wyceniany na 10 USD / M wejścia (2.50 USD w pamięci podręcznej), 40 USD / M wyjścia

➤ o4-mini-deep-research jest wyceniany na 2 USD / M wejścia (0,5 USD w pamięci podręcznej), 8 USD / M wyjścia

Te punkty końcowe są znacznie droższe niż standardowe punkty końcowe o3 i o4-mini firmy OpenAI - są to:

➤ o3: 2 $ / M (0,5 $ w pamięci podręcznej) wejść, 8 $ / M wyjście dla o3

➤ o4-mini: wejście 1.1 USD / M (0.275 w pamięci podręcznej), wyjście 4.4 USD / M

37,4K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi