Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Nezávislá analýza modelů AI a poskytovatelů hostingu - vyberte si nejlepší model a poskytovatele API pro váš případ použití

DeepSeek uvádí na trh V3.1, sjednocuje V3 a R1 do hybridního modelu uvažování s postupným zvyšováním inteligence

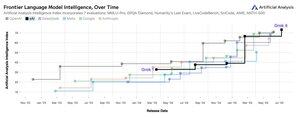

Přírůstkové zvýšení inteligence: Počáteční výsledky benchmarkingu pro DeepSeek V3.1 ukazují index umělé analýzy 60 v režimu uvažování, což je nárůst oproti skóre R1 59. V režimu bez uvažování dosahuje verze V3.1 skóre 49, což je větší nárůst oproti dřívějšímu skóre V3 0324 44. To nechává V3.1 (uvažování) za nejnovějším Qwen3 235B 2507 (uvažování) - DeepSeek si nevzal zpět vedení.

Hybridní uvažování: @deepseek_ai poprvé přešla na hybridní model uvažování, který podporuje režimy uvažování i bez uvažování. Přechod společnosti DeepSeek na jednotný model hybridního uvažování napodobuje přístup společností OpenAI, Anthropic a Google. Je však zajímavé poznamenat, že Alibaba nedávno opustila svůj hybridní přístup, který upřednostňovala pro Qwen3 se svými samostatnými vydáními modelů uvažování a instrukcí Qwen3 2507.

Volání funkcí / použití nástroje: Zatímco DeepSeek tvrdí, že pro model je vylepšeno volání funkcí, DeepSeek V3.1 nepodporuje volání funkcí v režimu uvažování. To pravděpodobně podstatně omezí jeho schopnost podporovat agentské pracovní postupy s požadavky na inteligenci, včetně kódovacích agentů.

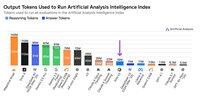

Použití tokenů: DeepSeek V3.1 má v režimu uvažování přírůstkově vyšší skóre než DeepSeek R1 a používá o něco méně tokenů napříč hodnoceními, která používáme pro Artificial Analysis Intelligence Index. V režimu nerozumu používá o něco více tokenů než V3 0324 - ale stále několikanásobně méně než ve svém vlastním režimu uvažování.

API: API první strany DeepSeek nyní poskytuje nový model DeepSeek V3.1 na svých koncových bodech chatu i uvažování – jednoduše změní, zda </think> je modelu v šabloně chatu poskytnut token koncového myšlení, aby bylo možné určit, zda bude model uvažovat.

Architektura: DeepSeek V3.1 je architektonicky identický s předchozími modely V3 a R1, s celkovými parametry 671B a aktivními parametry 37B.

Důsledky: Doporučujeme opatrnost při vytváření jakýchkoli předpokladů o tom, co toto vydání znamená o pokroku společnosti DeepSeek směrem k budoucímu modelu, který je v pověstech označován jako V4 nebo R2. Podotýkáme, že společnost DeepSeek již dříve vydala finální model postavený na jejich architektuře V2 10. prosince 2024, pouhé dva týdny před vydáním V3.

71,02K

Oznámení umělé analýzy Dlouhé kontextové uvažování (AA-LCR), nový benchmark pro hodnocení výkonu dlouhého kontextu prostřednictvím testování schopností uvažování napříč více dlouhými dokumenty (~100 tisíc tokenů)

AA-LCR se zaměřuje na replikaci skutečných znalostních prací a úloh uvažování, testování schopností kritických pro moderní aplikace AI, které zahrnují analýzu dokumentů, porozumění kódové základně a komplexní vícekrokové pracovní postupy.

AA-LCR je 100 pevných textových otázek, které vyžadují uvažování v několika reálných dokumentech, které představují ~100 tisíc vstupních tokenů. Otázky jsou navrženy tak, aby odpovědi nebylo možné najít přímo, ale musí být zdůvodněny z více informačních zdrojů, přičemž testování na lidech ověřuje, že každá otázka vyžaduje skutečné odvození, nikoli vyhledávání.

Klíčové poznatky:

➤ Dnešní přední modely dosahují přesnosti ~70 %: první tři místa patří OpenAI o3 (69 %), xAI Grok 4 (68 %) a Qwen3 235B 2507 Thinking (67 %)

👀 ➤ Také již máme výsledky gpt-oss! 120B se blíží o4-mini (vysoký), což je v souladu s tvrzeními OpenAI týkajícími se výkonu modelu. Brzy na to navážeme indexem inteligence pro modely.

➤ 100 otázek založených na pevném textu v 7 kategoriích dokumentů (zprávy společnosti, zprávy z odvětví, vládní konzultace, akademická obec, právní informace, marketingové materiály a zprávy z průzkumů)

➤ ~100 tisíc tokenů vstupu na otázku, což vyžaduje, aby modely podporovaly minimálně 128 tisíc kontextových oken pro dosažení skóre v tomto benchmarku

➤ ~3 miliony celkových jedinečných vstupních tokenů zahrnujících ~230 dokumentů pro spuštění benchmarku (výstupní tokeny se obvykle liší podle modelu)

➤ Odkaz na dataset na 🤗 @HuggingFace je níže

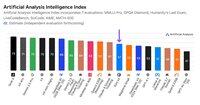

Přidáváme AA-LCR do indexu umělé analýzy a posouváme číslo verze na verzi 2.2. Artificial Analysis Intelligence Index v2.2 nyní obsahuje: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode a AA-LCR.

Všechna čísla jsou nyní na webu aktualizována. Zjistěte, které modely Umělá analýza Index v2.2 👇

28,74K

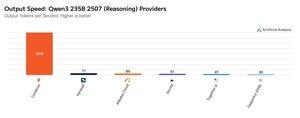

Cerebras tento týden demonstroval svou schopnost hostit velké MoE při velmi vysokých rychlostech a spustil koncové body Qwen3 235B 2507 a Qwen3 Coder 480B s výstupními tokeny >1 500/s

➤ @CerebrasSystems nyní nabízí koncové body pro Qwen3 235B 2507 Reasoning i Non-reasoning. Oba modely mají celkové parametry 235B, přičemž 22B je aktivních.

➤ Qwen 3 235B 2507 Reasoning nabízí inteligenci srovnatelnou s o4-mini (high) & DeepSeek R1 0528. Varianta Non-reasoning nabízí inteligenci srovnatelnou s Kimi K2 a výrazně nad GPT-4.1 a Llama 4 Maverick.

➤ Qwen3 Coder 480B má celkové parametry 480B s aktivním 35B. Tento model je zvláště silný pro agentní kódování a lze jej použít v různých nástrojích pro psaní kódovacích agentů, včetně Qwen3-Coder CLI.

Spuštění Cerebras představuje první případ, kdy je tato úroveň inteligence dostupná při těchto výstupních rychlostech a má potenciál odemknout nové případy použití - jako je použití modelu uvažování pro každý krok agenta, aniž by bylo nutné čekat minuty.

25,22K

🇰🇷 Společnost LG nedávno uvedla na trh EXAONE 4.0 32B – v indexu umělé analýzy má 62 bodů, což je dosud nejvyšší skóre pro model 32B

EXAONE 4.0 společnosti @LG_AI_Research je vydán ve dvou variantách: model hybridního uvažování 32B, pro který zde uvádíme výsledky benchmarkingu, a menší model 1.2B určený pro aplikace na zařízení, které jsme zatím nesrovnávali.

Vedle nedávného vydání Solar Pro 2 společnosti Upstage je vzrušující vidět, jak se korejské laboratoře umělé inteligence připojují k USA a Číně na vrcholu zpravodajských žebříčků.

Klíčové výsledky:

🧠 ➤ EXAONE 4.0 32B (uvažování): V režimu uvažování má EXAONE 4.0 skóre 62 v indexu umělé analýzy. To odpovídá Claude 4 Opus a novému Llama Nemotron Super 49B v1.5 od NVIDIA a je pouze 1 bod za Gemini 2.5 Flash

⚡ ➤ EXAONE 4.0 32B (bez uvažování): V režimu bez uvažování má EXAONE 4.0 skóre 51 v indexu umělé analytické inteligence. V inteligenci se vyrovná Llama 4 Maverick, přestože má pouze ~1/4 celkových parametrů (i když má ~2x více aktivních parametrů)

⚙️ ➤ Výstupní tokeny a podrobnost: V režimu uvažování použil EXAONE 4.0 100M výstupních tokenů pro index umělé analýzy. To je více než u některých jiných hraničních modelů, ale je to v souladu s nedávnými trendy, kdy modely uvažování používají více výstupních tokenů k "většímu přemýšlení" – podobně jako Llama Nemotron Super 49B v1.5, Grok 4 a Qwen3 235B 2507 Reasoning. V režimu nerozumu používal EXAONE 4.0 15M tokenů - což je pro nerozumného člověka hodně, ale ne tak vysoko jako 30M Kimi K2.

Klíčové detaily:

➤ Hybridní uvažování: Model nabízí volitelnou možnost mezi režimem "uvažování" a režimem "neuvažování"

➤ Dostupnost: V současné době hostováno společností @friendliai a za konkurenceschopnou cenu (zejména ve srovnání s proprietárními opcemi) společností FriendlyliAI za 1 $ za 1 milion vstupních a výstupních tokenů

➤ Otevřené váhy: EXAONE 4.0 je model s otevřenými váhami dostupný na základě licenční smlouvy EXAONE AI Model License Agreement 1.2. Licence omezuje komerční použití.

➤ Multimodalita: Vstup a výstup pouze textu

➤ Kontextové okno: 131 tisíc tokenů

➤ Parametry: 32B aktivních a celkových parametrů, k dispozici v 16bitové a 8bitové přesnosti (znamená, že model lze provozovat na jednom čipu H100 s plnou přesností)

41,58K

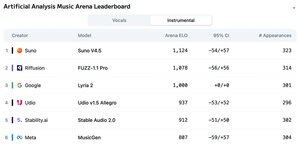

Oznámení žebříčku Artificial Analysis Music Arena: s >5 tisíci hlasy je Suno v4.5 vedoucím modelem Music Generation, následovaným Riffusion FUZZ-1.1 Pro.

Lyria 2 od Googlu se umístila na třetím místě v našem žebříčku Instrumental a Udio v1.5 Allegro se umístilo na třetím místě v našem žebříčku Vocals.

Instrumentální žebříček je následující:

🥇 @SunoMusic verze 4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI stabilní zvuk 2.0

@metaai MusicGen

Hodnocení je založeno na hlasování komunity v různých žánrech a podnětech. Chcete zobrazit svou výzvu? Výzvy můžete odeslat v aréně ještě dnes.

👇 Níže naleznete žebříček vokálů a odkaz na účast!

22,21K

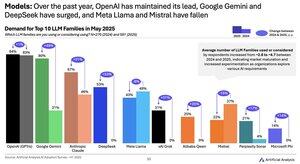

Změna poptávky po modelech v letech 2024 až 2025: Google (+49 bodů), DeepSeek (+53 bodů) a xAI (+31 bodů) dosáhly za poslední rok masivního nárůstu podílu na poptávce

@Google se změnila z opozdilce v oblasti umělé inteligence na lídra v oblasti umělé inteligence s ~2,5násobným nárůstem podílu respondentů, kteří používají nebo zvažují modelovou řadu Gemini. Klíčovým hnacím motorem toho bylo, že Google dosáhl významného nárůstu inteligence: Gemini 2.5 Pro se nyní nachází na #3 v našem indexu umělé analýzy ve srovnání s výrazným pozadem za OpenAI a Anthropic na začátku roku 2024.

@deepseek_ai v 1. pololetí 2024 vydala pouze model DeepSeek 67B, který zaznamenal omezené přijetí a nedosahoval dostatečného výkonu Llama 3 70B. Společnost DeepSeek nejprve zaznamenala určité přijetí koncem roku 2024 s vydáním svého modelu V2 a poté zaznamenala rychlé přijetí na začátku roku 2025 se svými modely V3 a R1, které je vynesly na vedoucí pozici mezi modely s otevřenou váhou.

Společnost @xai vydala svůj první model Grok-1 v polovině 1. pololetí 2024 a od té doby se rychle vyšplhala na vedoucí postavení v oblasti inteligence u všech modelů s postupným uvolňováním, což vyvrcholilo uvedením modelu Grok 4 minulý týden.

Zdroj: Průzkum umělé analýzy o adopci umělé inteligence H1 2025 (zpráva je k dispozici na webových stránkách umělé analýzy)

389,06K

Poskytovatelé Kimi K2: Groq obsluhuje Kimi K2 rychlostí >400 výstupních tokenů/s, 40x rychleji než API první strany Moonshot

Gratulujeme řadě poskytovatelů k rychlému spuštění API pro Kimi K2, včetně @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra a samozřejmě @Kimi_Moonshot. To je působivé vzhledem k velikosti modelu při celkovém počtu 1 bilionu parametrů.

Groq vyniká bleskovou rychlostí. DeepInfra, Novita a Baseten vynikají svými cenami, protože jsou jedinými poskytovateli, kteří mají podobné ceny nebo levnější než API první strany Moonshot.

Další srovnání mezi poskytovateli naleznete níže. U některých poskytovatelů očekáváme rychlý nárůst rychlosti, protože týmy optimalizují model K2 – naše níže uvedená čísla ukazují střední rychlosti za posledních 72 hodin, ale již nyní vidíme, že DeepInfra v dnešních měřeních vyskočil až na 62 tokenů/s

52,33K

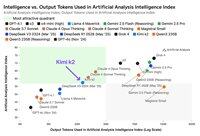

Zatímco Kimi k2 společnosti Moonshot AI je předním modelem s otevřenou váhou v indexu umělé analýzy, vydává ~3x více tokenů než jiné nerozumné modely, čímž stírá hranice mezi uvažováním a neuvažováním

Kimi k2 je zatím největší hlavní model s otevřenými váhami - celkové parametry 1T s 32B aktivními (to vyžaduje masivní 1TB paměti na nativním FP8, aby se váhy udržely). V indexu umělé analýzy máme k2 na 57, což je působivé skóre, které ho staví nad modely jako GPT-4.1 a DeepSeek V3, ale za přední modely uvažování.

Až dosud byl v našich hodnoceních jasný rozdíl mezi modelem uvažování a modely bez uvažování - definovaný nejen tím, zda model používá <reasoning> značky, ale především použitím tokenů. Medián počtu tokenů použitých k zodpovězení všech hodnocení v indexu umělé analýzy je ~10x vyšší pro modely uvažování než pro modely bez uvažování.

Kimi k2 @Kimi_Moonshot používá ~3x více tokenů, než používá mediánový model bez uvažování. Jeho využití tokenů je pouze o 30% nižší než u Claude 4 Sonet a Opus, když běží v režimu rozšířeného myšlení s maximálním rozpočtem, a je téměř trojnásobné oproti použití tokenů Claude 4 Sonet a Opus s vypnutým uvažováním.

Proto doporučujeme, aby byl Kimi k2 srovnáván s Claude 4 Sonet a Opus v jejich režimech myšlení s maximálním rozpočtem, nikoli s nerozumovým skóre pro modely Claude 4.

Kimi k2 je k dispozici na API první strany @Kimi_Moonshot a také na @FireworksAI_HQ, @togethercompute, @novita_labs a @parasail_io.

Další analýzu 👇 naleznete níže a v části Umělá analýza

60,64K

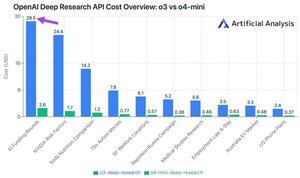

Nové rozhraní API pro hluboký výzkum OpenAI stojí až ~ 30 $ za volání API! Tyto nové koncové body rozhraní API pro hloubkový výzkum mohou být právě novým nejrychlejším způsobem, jak utratit peníze

Napříč našimi 10 hloubkovými výzkumnými testovacími dotazy jsme utratili 100 $ na o3 a 9.18 $ na o4-mini. Jak se náklady stávají tak velkými? Vysoké ceny a miliony žetonů.

Tyto koncové body jsou verze o3 a o4-mini, které byly RL vyvinuty pro úlohy hlubokého výzkumu. Dostupnost prostřednictvím rozhraní API umožňuje jejich použití jak s webovým vyhledávacím nástrojem OpenAI, tak s vlastními zdroji dat prostřednictvím vzdálených serverů MCP.

Cena O4-Mini-Deep-Research je 5x nižší než cena O3-Deep-Research. V našich testovacích dotazech se také zdá, že o4-mini používá méně tokenů - je celkem více než 10x levnější v našich 10 testovacích dotazech.

Stanovení cen:

➤ o3-deep-research má cenu 10 USD/M vstup (2,50 USD vstup uložený v mezipaměti), výstup 40 USD/M

➤ o4-mini-deep-research má cenu 2 $ / M vstup (0,5 $ vstup uložený do mezipaměti), výstup 8 $ / M

Oba tyto koncové body jsou podstatně dražší než standardní koncové body OpenAI o3 a o4-mini - ty jsou na:

➤ o3: $2 /M ($0.5 cachovaný) vstup, $8 /M výstup pro o3

➤ o4-mini: $1.1 /M (0.275 cache) vstup, $4.4 /M výstup

37,35K

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější