热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

Artificial Analysis

独立分析 AI 模型和托管提供商 - 为您的用例选择最佳模型和 API 提供商

DeepSeek推出V3.1,将V3和R1统一为一个混合推理模型,智能水平逐步提升

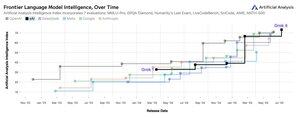

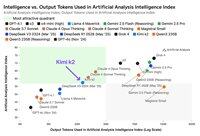

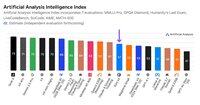

智能水平逐步提升:DeepSeek V3.1的初步基准测试结果显示,推理模式下的人工分析智能指数为60,较R1的59有所上升。在非推理模式下,V3.1的得分为49,较早期的V3 0324得分44有了更大的提升。这使得V3.1(推理)落后于阿里巴巴最新的Qwen3 235B 2507(推理)——DeepSeek尚未重新夺回领先地位。

混合推理:@deepseek_ai首次采用混合推理模型,支持推理和非推理模式。DeepSeek转向统一的混合推理模型模仿了OpenAI、Anthropic和Google的做法。然而,值得注意的是,阿里巴巴最近放弃了他们之前偏好的混合方法,分别发布了Qwen3 2507推理和指令模型。

功能调用/工具使用:虽然DeepSeek声称模型的功能调用有所改善,但DeepSeek V3.1在推理模式下不支持功能调用。这可能会大大限制其支持具有智能要求的代理工作流程的能力,包括在编码代理中的应用。

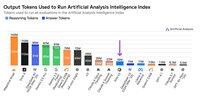

令牌使用:DeepSeek V3.1在推理模式下的得分比DeepSeek R1略高,并且在我们用于人工分析智能指数的评估中使用的令牌略少。在非推理模式下,它使用的令牌比V3 0324略多——但仍然是其推理模式使用的令牌的几倍。

API:DeepSeek的第一方API现在在他们的聊天和推理端点上服务于新的DeepSeek V3.1模型——只需在聊天模板中更改是否提供结束思考</think>令牌,以控制模型是否进行推理。

架构:DeepSeek V3.1在架构上与之前的V3和R1模型完全相同,具有671B的总参数和37B的活跃参数。

影响:我们建议在对这一发布所暗示的DeepSeek在未来模型(传闻称为V4或R2)进展方面做出任何假设时保持谨慎。我们注意到,DeepSeek之前在2024年12月10日发布了基于其V2架构的最终模型,仅在发布V3的两周前。

71.09K

宣布人工分析长上下文推理(AA-LCR),这是一个新的基准,用于通过测试多个长文档(~100k tokens)的推理能力来评估长上下文性能。

AA-LCR的重点是复制真实的知识工作和推理任务,测试对现代AI应用至关重要的能力,涵盖文档分析、代码库理解和复杂的多步骤工作流程。

AA-LCR包含100个基于文本的困难问题,这些问题需要在多个代表~100k输入tokens的真实世界文档中进行推理。问题的设计使得答案不能直接找到,而必须从多个信息源中推理得出,人工测试验证每个问题确实需要真实的推理而非检索。

关键要点:

➤ 今天的领先模型实现了~70%的准确率:前三名分别是OpenAI o3(69%)、xAI Grok 4(68%)和Qwen3 235B 2507 Thinking(67%)

➤👀 我们也已经有了gpt-oss的结果!120B的表现接近o4-mini(高),与OpenAI关于模型性能的声明一致。我们将很快跟进模型的智能指数。

➤ 100个基于文本的困难问题,涵盖7类文档(公司报告、行业报告、政府咨询、学术界、法律、市场材料和调查报告)

➤ 每个问题约需~100k tokens的输入,要求模型支持至少128K的上下文窗口才能在此基准上得分

➤ 运行基准所需的总独特输入tokens约为~3M,涵盖~230个文档(输出tokens通常因模型而异)

➤ 数据集链接在🤗 @HuggingFace下方

我们将AA-LCR添加到人工分析智能指数,并将版本号提升至v2.2。人工分析智能指数v2.2现在包括:MMLU-Pro、GPQA Diamond、AIME 2025、IFBench、LiveCodeBench、SciCode和AA-LCR。

所有数字现在已在网站上更新。查看哪些模型在人工分析智能指数v2.2中表现优异👇

28.79K

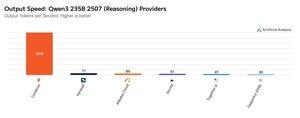

Cerebras 本周一直在展示其以非常高的速度托管大型 MoE 的能力,以 >1,500 个输出令牌/秒的速度推出 Qwen3 235B 2507 和 Qwen3 Coder 480B 端点

➤ @CerebrasSystems 现在为 Qwen3 235B 2507 推理和非推理提供端点。两种型号的总参数均为 235B,其中 22B 处于活动状态。

➤ Qwen 3 235B 2507 Reasoning 提供可与 o4-mini(高)和 DeepSeek R1 0528 相媲美的智能。非推理变体提供的智能可与 Kimi K2 相媲美,远高于 GPT-4.1 和 Llama 4 Maverick。

➤ Qwen3 Coder 480B 总参数为 480B,其中 35B 处于活动状态。该模型对于代理编码特别强大,可用于各种编码代理工具,包括 Qwen3-Coder CLI。

Cerebras 的发布代表了这种智能水平首次以这样的输出速度实现,并有可能解锁新的用例——例如为代理的每个步骤使用推理模型,而无需等待几分钟。

25.28K

🇰🇷 LG 最近推出了 EXAONE 4.0 32B - 在人工分析智能指数上得分 62,是迄今为止 32B 模型中最高的分数。

@LG_AI_Research 的 EXAONE 4.0 有两个变体:我们在这里报告基准测试结果的 32B 混合推理模型,以及一个为设备应用设计的小型 1.2B 模型,我们尚未对其进行基准测试。

随着 Upstage 最近发布的 Solar Pro 2,看到韩国 AI 实验室与美国和中国一起接近智能排行榜的顶端,令人兴奋。

关键结果:

➤ 🧠 EXAONE 4.0 32B(推理):在推理模式下,EXAONE 4.0 在人工分析智能指数上得分 62。这与 Claude 4 Opus 和 NVIDIA 的新款 Llama Nemotron Super 49B v1.5 相匹配,仅比 Gemini 2.5 Flash 低 1 分。

➤ ⚡ EXAONE 4.0 32B(非推理):在非推理模式下,EXAONE 4.0 在人工分析智能指数上得分 51。尽管总参数仅约为 1/4,但在智能上与 Llama 4 Maverick 相匹配(尽活跃参数约为 2 倍)。

➤ ⚙️ 输出令牌和冗长性:在推理模式下,EXAONE 4.0 为人工分析智能指数使用了 1 亿个输出令牌。这比其他一些前沿模型要高,但与推理模型使用更多输出令牌以“思考更多”的近期趋势一致 - 类似于 Llama Nemotron Super 49B v1.5、Grok 4 和 Qwen3 235B 2507 推理。在非推理模式下,EXAONE 4.0 使用了 1500 万个令牌 - 对于非推理者来说很高,但不及 Kimi K2 的 3000 万。

关键细节:

➤ 混合推理:该模型在“推理”模式和“非推理”模式之间提供选择。

➤ 可用性:目前由 @friendliai 托管,FriendliAI 以每 100 万输入和输出令牌 1 美元的竞争性价格提供(尤其是与专有选项相比)。

➤ 开放权重:EXAONE 4.0 是一个开放权重模型,依据 EXAONE AI 模型许可协议 1.2 提供。该许可限制商业使用。

➤ 多模态性:仅支持文本输入和输出。

➤ 上下文窗口:131k 令牌。

➤ 参数:32B 活跃和总参数,提供 16 位和 8 位精度(意味着该模型可以在单个 H100 芯片上以全精度运行)。

41.64K

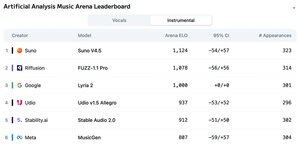

宣布人工分析音乐竞技场排行榜:超过5000票,Suno v4.5 是领先的音乐生成模型,其次是 Riffusion 的 FUZZ-1.1 Pro。

谷歌的 Lyria 2 在我们的器乐排行榜中排名第三,而 Udio 的 v1.5 Allegro 在我们的声乐排行榜中排名第三。

器乐排行榜如下:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

排名基于社区在多种风格和提示下的投票。想看到你的提示被展示吗?你可以今天在竞技场提交提示。

👇 请查看下面的声乐排行榜和参与链接!

22.27K

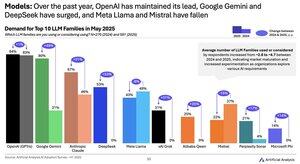

2024 年至 2025 年的模型需求变化:谷歌(+49 个百分点)、DeepSeek(+53 个百分点)和 xAI(+31 个百分点)在过去一年中实现了需求份额的巨大增长

@Google 已经从人工智能落后者转变为人工智能领导者,使用或考虑 Gemini 模型系列的受访者比例增加了 ~2.5 倍。其中一个关键驱动力是谷歌在智能方面取得了显着进步:Gemini 2.5 Pro 现在在我们的人工智能分析智能指数中排名 #3,而在 2024 年初明显落后于 OpenAI 和 Anthropic。

@deepseek_ai 在 2024 年上半年仅发布了 DeepSeek 67B,该型号采用率有限且表现不佳于 Llama 3 70B。DeepSeek 首先在 2024 年底随着 V2 模型的发布而获得一些采用,然后在 2025 年初凭借其 V3 和 R1 模型迅速采用,这使他们在开放重量模型中处于领先地位。

@xai于 1 年上半年中期发布了首款型号 Grok-2024,此后通过连续发布迅速跻身所有型号的智能领先地位,最终在上周推出了 Grok 4。

资料来源:2025 年上半年人工智能采用调查(报告可在人工智能分析网站上获取)

389.11K

Kimi K2 提供商:Groq 的输出速度超过 400 个 token/s,比 Moonshot 的第一方 API 快 40 倍。

祝贺多家提供商迅速推出 Kimi K2 的 API,包括 @GroqInc、@basetenco、@togethercompute、@FireworksAI_HQ、@parasail_io、@novita_labs、@DeepInfra,以及当然还有 @Kimi_Moonshot。考虑到模型的规模达到 1 万亿个参数,这实在令人印象深刻。

Groq 以其超快的速度脱颖而出。DeepInfra、Novita 和 Baseten 以其定价而突出,成为唯一与 Moonshot 的第一方 API 定价相似或更便宜的提供商。

请参见下面对各提供商的进一步比较。我们预计随着团队对 K2 模型的优化,一些提供商的速度将迅速提升——我们下面的数字显示了过去 72 小时的中位速度,但我们已经看到 DeepInfra 在今天的测量中跃升至 62 tokens/s。

52.39K

虽然 Moonshot AI 的 Kimi k2 是人工智能分析智能指数中领先的开放权重非推理模型,但它输出的代币是其他非推理模型的 ~3 倍,模糊了推理和非推理之间的界限

Kimi k2 是迄今为止最大的主要开放权重模型 - 1T 总参数,32B 活动(这需要原生 FP1 的 8TB 海量内存来保存权重)。我们在人工智能分析智能指数中的 k2 为 57,这是一个令人印象深刻的分数,使其高于 GPT-4.1 和 DeepSeek V3 等模型,但落后于领先的推理模型。

到目前为止,在我们的评估中,推理模型和非推理模型之间已经有明显的区别——不仅取决于模型是否使用<reasoning>标签,而且主要取决于标记的使用。推理模型用于回答人工智能分析智能指数中所有评估的标记数中位数比非推理模型高 ~10 倍。

@Kimi_Moonshot 的 Kimi k2 使用的标记数量是中位数非推理模型使用的标记数量的 ~3 倍。当在最大预算扩展思维模式下运行时,它的令牌使用量仅比 Claude 4 Sonnet 和 Opus 低 30%,并且几乎是 Claude 4 Sonnet 和 Opus 在关闭推理的情况下的令牌使用量的三倍。

因此,我们建议将 Kimi k2 与 Claude 4 Sonnet 和 Opus 的最大预算扩展思维模式进行比较,而不是与 Claude 4 模型的非推理分数进行比较。

Kimi k2 可在 @Kimi_Moonshot 的第一方 API 以及 @FireworksAI_HQ、@togethercompute、@novita_labs 和 @parasail_io 上使用。

有关进一步分析👇,请参阅下文和人工分析

60.7K

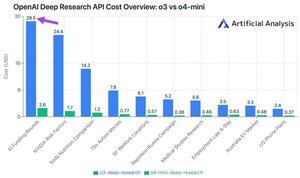

OpenAI 的新深度研究 API 每次 API 调用费用高达 ~30 美元!这些新的深度研究 API 端点可能只是新的、最快的花钱方式

在我们的 10 个深入研究测试查询中,我们在 o100 上花费了 3 美元,在 o9.18-mini 上花费了 4 美元。成本怎么会这么大?高价和数百万个代币。

这些端点是 o3 和 o4-mini 的版本,已针对深度研究任务进行了 RL。通过 API 提供,它们可以通过远程 MCP 服务器与 OpenAI 的 Web 搜索工具和自定义数据源一起使用。

O4-mini-Deep-Research 定价比 O5-Deep-Research 定价低 3 倍。在我们的测试查询中,o4-mini 似乎也使用了更少的代币——在我们的 10 个测试查询中,它的总成本降低了 10 倍以上。

定价:

➤ o3-deep-research 的定价为 10 美元/M 输入(2.50 美元缓存输入),40 美元/M 输出

➤ O4-mini-deep-research 定价为 2 美元/M 输入(0.5 美元缓存输入),8 美元/M 输出

这些端点都比 OpenAI 的标准 o3 和 o4-mini 端点贵得多——它们位于:

➤ o3:2 美元/月(0.5 美元缓存)输入,o3 8 美元/月输出

➤ o4-mini:1.1 美元/月(0.275 缓存)输入,4.4 美元/月输出

37.42K

热门

排行

收藏

链上热点

X 热门榜

近期融资

最受认可