Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

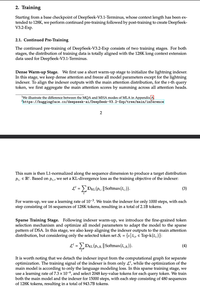

Những kẻ điên rồ đã lừa dối mọi người với "NATIVE Sparse Attention", giải thích dài dòng rằng độ thưa thớt sau là xấu và việc huấn luyện từ đầu là hoàn toàn cần thiết, và chỉ… đã làm thưa thớt một checkpoint V3.

Bạn có nhận ra điều này áp dụng chung cho tất cả các mô hình attn dày đặc không?

Hàng đầu

Thứ hạng

Yêu thích