Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

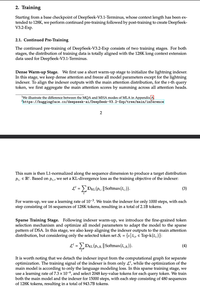

Mad lads hebben iedereen misleid met "NATIVE Sparse Attention", waarbij ze uitgebreid uitleggen hoe post-hoc sparsity slecht is en dat het absoluut noodzakelijk is om vanaf nul voor te trainen, en gewoon... een V3-checkpoint gesparsified hebben.

Realiseer je je dat dit algemeen van toepassing is op alle dense attn-modellen?

Boven

Positie

Favorieten