Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

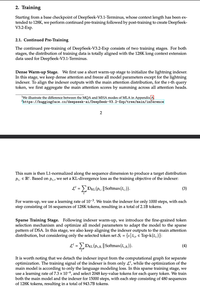

Rapazes loucos enganaram a todos com "Atenção esparsa nativa", explicando longamente como a esparsidade post-hoc é ruim e é necessário pré-treinar do zero, e apenas ... esparsificou um ponto de verificação V3.

Você percebe que isso se aplica de forma geral, a todos os modelos de atenção densa?

Melhores

Classificação

Favoritos