Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

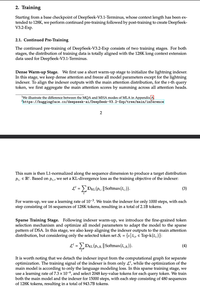

Les fous ont trompé tout le monde avec "NATIVE Sparse Attention", expliquant longuement comment la sparsité post-hoc est mauvaise et qu'il est totalement nécessaire de préformer à partir de zéro, et juste… ont sparsifié un point de contrôle V3.

Réalisez-vous que cela s'applique généralement à tous les modèles d'attention dense ?

Meilleurs

Classement

Favoris