Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

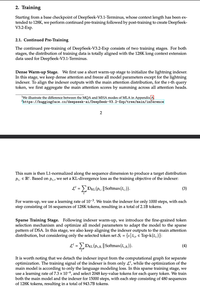

Szaleńcy wprowadzili wszystkich w błąd mówiąc o "NATIVE Sparse Attention", długo wyjaśniając, jak post-hoc sparsity jest zła i że konieczne jest trenowanie od podstaw, a po prostu... sparsifikowali punkt kontrolny V3.

Czy zdajesz sobie sprawę, że to dotyczy ogólnie wszystkich modeli z gęstym attn?

Najlepsze

Ranking

Ulubione