Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

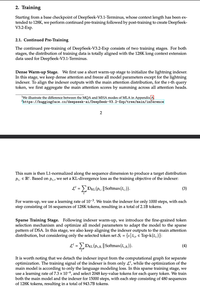

Los muchachos locos han engañado a todos con "NATIVE Sparse Attention", explicando en detalle cómo la escasez post-hoc es mala y es necesario preentrenar desde cero, y simplemente... dispersó un punto de control V3.

¿Te das cuenta de que esto se aplica en general, a todos los modelos de atención densa?

Populares

Ranking

Favoritas