Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

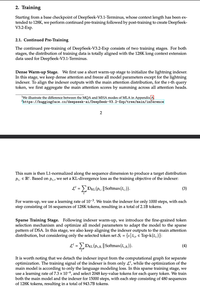

Băieții nebuni au indus în eroare pe toată lumea cu "NATIVE Sparse Attention", explicând pe larg cum sparsitatea post-hoc este rea și că este necesar să te preantrenezi de la zero și doar... a dispersat un punct de control V3.

Vă dați seama că acest lucru se aplică în general, tuturor modelelor dense?

Limită superioară

Clasament

Favorite