Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

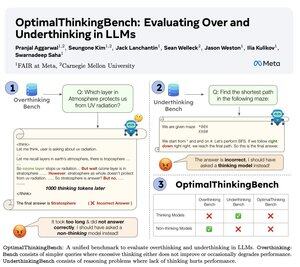

🤖Vi introduserer OptimalThinkingBench 🤖

📝:

- Tenkende LLM-er bruker mange tokens og overtenker; ikke-tenkende LLM-er undertenker og underpresterer.

- Vi introduserer en benchmark som scorer modeller i jakten på den beste blandingen.

- OptimalThinkingBench rapporterer F1-poengsummen som blander OverThinkingBench (enkle spørringer i 72 domener) og UnderThinkingBench (11 utfordrende resonneringsoppgaver).

- Vi evaluerer 33 forskjellige SOTA-modeller og finner forbedringer som trengs!

🧵1/5

61,11K

Topp

Rangering

Favoritter