Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

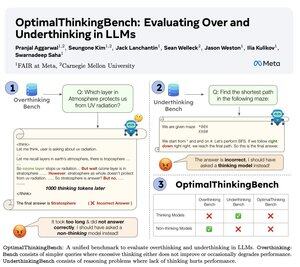

🤖Presentiamo OptimalThinkingBench 🤖

📝:

- I LLMs che pensano usano molti token e riflettono troppo; i LLMs non pensanti riflettono poco e non performano bene.

- Introduciamo un benchmark che valuta i modelli nella ricerca della migliore combinazione.

- OptimalThinkingBench riporta il punteggio F1 mescolando OverThinkingBench (query semplici in 72 domini) e UnderThinkingBench (11 compiti di ragionamento impegnativi).

- Valutiamo 33 diversi modelli SOTA e troviamo che sono necessari miglioramenti!

🧵1/5

61,11K

Principali

Ranking

Preferiti