Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

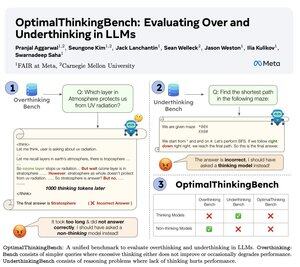

🤖 Einführung von OptimalThinkingBench 🤖

📝:

- Denkende LLMs verwenden viele Tokens und überdenken; nicht-denkende LLMs denken zu wenig und schneiden schlecht ab.

- Wir stellen einen Benchmark vor, der Modelle bewertet, um die beste Mischung zu finden.

- OptimalThinkingBench berichtet über den F1-Score, der OverThinkingBench (einfache Anfragen in 72 Bereichen) und UnderThinkingBench (11 herausfordernde Denkaufgaben) kombiniert.

- Wir bewerten 33 verschiedene SOTA-Modelle und stellen fest, dass Verbesserungen erforderlich sind!

🧵1/5

61,13K

Top

Ranking

Favoriten