Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

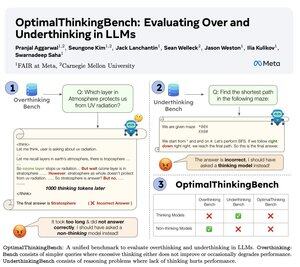

🤖Przedstawiamy OptimalThinkingBench 🤖

📝:

- Myślące LLM-y używają wielu tokenów i zbytnio analizują; nie-myślące LLM-y myślą zbyt mało i osiągają słabe wyniki.

- Wprowadzamy benchmark, który ocenia modele w poszukiwaniu najlepszego miksu.

- OptimalThinkingBench raportuje wynik F1 łącząc OverThinkingBench (proste zapytania w 72 dziedzinach) i UnderThinkingBench (11 trudnych zadań rozumowania).

- Oceniamy 33 różne modele SOTA i stwierdzamy, że potrzebne są poprawki!

🧵1/5

61,13K

Najlepsze

Ranking

Ulubione