Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

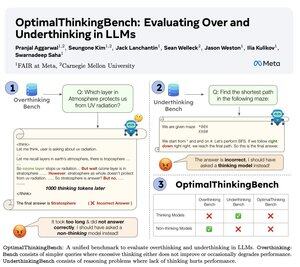

🤖Introductie van OptimalThinkingBench 🤖

📝:

- Denkende LLM's gebruiken veel tokens en denken te veel na; niet-denkende LLM's denken te weinig na en presteren ondermaats.

- We introduceren een benchmark die modellen beoordeelt in de zoektocht naar de beste mix.

- OptimalThinkingBench rapporteert de F1-score door OverThinkingBench (eenvoudige vragen in 72 domeinen) en UnderThinkingBench (11 uitdagende redeneertaken) te combineren.

- We evalueren 33 verschillende SOTA-modellen en ontdekken dat er verbeteringen nodig zijn!

🧵1/5

61,14K

Boven

Positie

Favorieten