Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

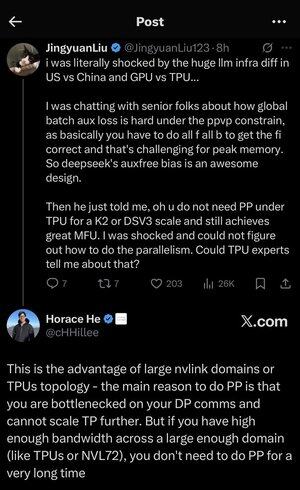

Je me suis un peu perdu dans tous les acronymes et le jargon ici, alors j'ai demandé à Claude de l'expliquer sans utiliser d'acronymes et maintenant tout a parfaitement du sens (tldr; bande passante ⟹ simplicité) :

C'est une discussion technique fascinante sur l'entraînement de grands modèles de langage à grande échelle.

La Conversation Principale

Jingyuan Liu exprime sa surprise de découvrir qu'il n'est pas nécessaire d'utiliser certaines techniques d'optimisation complexes lors de l'utilisation de TPUs (Tensor Processing Units - les puces AI spécialisées de Google) par rapport aux GPUs (Graphics Processing Units - généralement les puces de NVIDIA).

Concepts Techniques Clés Expliqués :

Types de Matériel :

•GPU (Graphics Processing Unit) : À l'origine conçu pour les graphiques, maintenant largement utilisé pour l'IA. NVIDIA domine ce marché.

•TPU (Tensor Processing Unit) : Puces conçues sur mesure par Google spécifiquement pour l'apprentissage automatique.

Stratégies de Parallélisme :

Lors de l'entraînement de modèles d'IA massifs, vous devez répartir le travail sur de nombreuses puces. Il existe plusieurs façons de le faire :

1) Parallélisme de Données (DP) : Chaque puce traite différents lots de données avec la même copie du modèle.

2) Parallélisme de Tenseur (TP) : Les opérations mathématiques du modèle sont réparties sur les puces.

3) Parallélisme de Pipeline (PP) : Différentes couches du modèle sont placées sur différentes puces, créant un pipeline.

Le Défi Technique Discuté :

Le problème de la perte auxiliaire : Lors de l'entraînement de modèles très grands, vous ajoutez souvent des "pertes auxiliaires" (objectifs d'entraînement supplémentaires) à des couches intermédiaires pour aider les gradients à mieux circuler dans le réseau. Sous les contraintes de PPVP (Parallélisme de Pipeline avec Partitionnement Variable), cela devient complexe car :

•Vous devez faire "tous f tous b" (tous les passages avant, puis tous les passages arrière)

•C'est un défi pour l'utilisation de la mémoire maximale car vous devez stocker les résultats intermédiaires.

L'innovation de DeepSeek : Ils ont développé un design "auxfree bias" qui apparemment évite d'avoir besoin de ces pertes auxiliaires tout en s'entraînant efficacement.

La Révélation Surprenante :

L'expert senior a dit à Jingyuan qu'avec des TPUs à l'échelle K2 ou DSV3 (ce sont des configurations de cluster avec des centaines ou des milliers de puces), vous pouvez atteindre une excellente MFU (Utilisation des FLOPs du Modèle - essentiellement à quel point vous utilisez efficacement le matériel) SANS utiliser le Parallélisme de Pipeline.

Pourquoi est-ce surprenant ?

•Le Parallélisme de Pipeline est généralement considéré comme essentiel pour l'entraînement à grande échelle.

•C'est une technique complexe qui nécessite une optimisation minutieuse.

•Être capable de l'éviter simplifie tout de manière significative.

L'Explication de Horace He :

Il explique POURQUOI cela est possible avec les TPUs :

L'avantage de la bande passante : Les TPUs et les clusters NVIDIA haut de gamme (comme NVL72 - la dernière configuration de 72 GPU de NVIDIA avec des interconnexions NVLink) ont une bande passante si élevée entre les puces qu'ils peuvent gérer les exigences de communication sans Parallélisme de Pipeline.

L'idée clé :

•Le Parallélisme de Pipeline est principalement nécessaire lorsque vous êtes "bottlenecked on DP comms" (limité par la rapidité de communication pendant l'entraînement parallèle de données).

•Si vous avez suffisamment de bande passante sur un domaine suffisamment large (cluster interconnecté), vous pouvez simplement utiliser des stratégies de parallélisme plus simples.

•Cela fonctionne "pendant très longtemps" - ce qui signifie que vous pouvez entraîner même des modèles très grands sans atteindre les limites.

L'Intuition :

Pensez-y comme à un système autoroutier :

•Les clusters GPU traditionnels sont comme avoir des routes étroites entre les villes, donc vous avez besoin d'un routage complexe (Parallélisme de Pipeline) pour éviter les embouteillages.

•Les clusters TPU ou les GPU connectés par NVLink sont comme avoir d'énormes autoroutes - vous pouvez simplement envoyer tout directement sans routage sophistiqué.

C'est un gros problème car le Parallélisme de Pipeline est complexe à mettre en œuvre, à déboguer et à optimiser. Être capable de l'éviter tout en atteignant une haute efficacité rend l'ensemble du processus d'entraînement beaucoup plus simple et plus fiable.

La discussion met en lumière comment les avancées dans la technologie d'interconnexion matérielle (les "routes" entre les puces) peuvent fondamentalement changer les stratégies logicielles nécessaires pour un entraînement efficace de l'IA.

6,97K

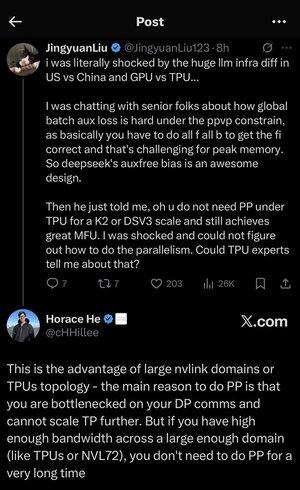

Je me suis un peu perdu dans tous les acronymes et le jargon ici, alors j'ai demandé à Claude de l'expliquer sans utiliser d'acronymes et maintenant tout a parfaitement du sens (tldr; bande passante ⟹ simplicité) :

C'est une discussion technique fascinante sur l'entraînement de grands modèles de langage à grande échelle.

La Conversation Principale

Jingyuan Liu exprime sa surprise de découvrir qu'il n'est pas nécessaire d'utiliser certaines techniques d'optimisation complexes lors de l'utilisation de TPUs (Tensor Processing Units - les puces AI spécialisées de Google) par rapport aux GPUs (Graphics Processing Units - généralement les puces de NVIDIA).

Concepts Techniques Clés Expliqués :

Types de Matériel :

•GPU (Graphics Processing Unit) : À l'origine conçu pour les graphiques, maintenant largement utilisé pour l'IA. NVIDIA domine ce marché.

•TPU (Tensor Processing Unit) : Puces conçues sur mesure par Google spécifiquement pour l'apprentissage automatique.

Stratégies de Parallélisme :

Lors de l'entraînement de modèles AI massifs, vous devez répartir le travail sur de nombreuses puces. Il existe plusieurs façons de le faire :

1. Parallélisme de Données (DP) : Chaque puce traite différents lots de données avec la même copie du modèle.

2. Parallélisme de Tenseur (TP) : Les opérations mathématiques du modèle sont réparties sur les puces.

3. Parallélisme de Pipeline (PP) : Différentes couches du modèle sont placées sur différentes puces, créant un pipeline.

Le Défi Technique Discuté :

Le problème de la perte auxiliaire : Lors de l'entraînement de modèles très grands, vous ajoutez souvent des "pertes auxiliaires" (objectifs d'entraînement supplémentaires) à des couches intermédiaires pour aider les gradients à mieux circuler dans le réseau. Sous les contraintes de PPVP (Parallélisme de Pipeline avec Partitionnement Variable), cela devient complexe car :

•Vous devez faire "tous f tous b" (toutes les passes avant, puis toutes les passes arrière).

•C'est un défi pour l'utilisation maximale de la mémoire car vous devez stocker les résultats intermédiaires.

L'innovation de DeepSeek : Ils ont développé un design "auxfree bias" qui apparemment évite d'avoir besoin de ces pertes auxiliaires tout en s'entraînant efficacement.

La Révélation Surprenante :

L'expert senior a dit à Jingyuan qu'avec des TPUs à l'échelle K2 ou DSV3 (ce sont des configurations de cluster avec des centaines ou des milliers de puces), vous pouvez atteindre une excellente MFU (Utilisation des FLOPs du Modèle - essentiellement à quel point vous utilisez efficacement le matériel) SANS utiliser le Parallélisme de Pipeline.

Pourquoi est-ce surprenant ?

•Le Parallélisme de Pipeline est généralement considéré comme essentiel pour l'entraînement à grande échelle.

•C'est une technique complexe qui nécessite une optimisation minutieuse.

•Être capable de l'éviter simplifie tout de manière significative.

L'Explication de Horace He :

Il explique POURQUOI cela est possible avec les TPUs :

L'avantage de la bande passante : Les TPUs et les clusters NVIDIA haut de gamme (comme NVL72 - la dernière configuration de 72 GPU de NVIDIA avec des interconnexions NVLink) ont une bande passante si élevée entre les puces qu'ils peuvent gérer les exigences de communication sans Parallélisme de Pipeline.

L'aperçu clé :

•Le Parallélisme de Pipeline est principalement nécessaire lorsque vous êtes "bottlenecked on DP comms" (limité par la rapidité de communication pendant l'entraînement parallèle de données).

•Si vous avez suffisamment de bande passante sur un domaine suffisamment large (cluster interconnecté), vous pouvez simplement utiliser des stratégies de parallélisme plus simples.

•Cela fonctionne "pendant très longtemps" - ce qui signifie que vous pouvez entraîner même des modèles très grands sans atteindre les limites.

L'Intuition :

Pensez-y comme à un système autoroutier :

•Les clusters GPU traditionnels sont comme avoir des routes étroites entre les villes, donc vous avez besoin d'un routage complexe (Parallélisme de Pipeline) pour éviter les embouteillages.

•Les clusters TPU ou les GPU connectés par NVLink sont comme avoir d'énormes autoroutes - vous pouvez simplement envoyer tout directement sans routage sophistiqué.

C'est un gros problème car le Parallélisme de Pipeline est complexe à mettre en œuvre, à déboguer et à optimiser. Être capable de l'éviter tout en atteignant une haute efficacité rend l'ensemble du processus d'entraînement beaucoup plus simple et plus fiable.

La discussion met en lumière comment les avancées dans la technologie d'interconnexion matérielle (les "routes" entre les puces) peuvent fondamentalement changer les stratégies logicielles nécessaires pour un entraînement AI efficace.

3,01K

Je suis un peu surpris que personne n'ait encore créé de serveur MCP pour Dwarf Fortress qui pourrait permettre à un agent comme Codex ou Claude Code de contrôler efficacement le jeu et de surveiller l'état et les progrès.

Je ne l'ai jamais vraiment joué moi-même, je l'ai juste téléchargé et l'ai brièvement consulté il y a environ 10 ans, mais j'ai aimé en lire à son sujet.

On dirait que ce serait un très bon test pour un LLM de voir combien de temps il pourrait garder les nains en vie et prospères.

Parce que chaque partie finit par entraîner une catastrophe en cascade qui fait mourir tous les nains, il devrait y avoir un point d'arrêt naturel, ce qui en fait un bon candidat pour un benchmark. Du moins, c'est ma compréhension (le motto des joueurs est "Perdre est amusant").

Bien faire ce jeu dépendrait de l'exactitude de l'appel d'outils et de la cohérence dans les tâches longues, ainsi que de la capacité à surveiller et comprendre la dynamique d'un système complexe et à faire des interventions opportunes qui anticipent et contrent les problèmes.

Et parce que c'est natif terminal, il pourrait être transmis et traité efficacement en utilisant des jetons réguliers sans avoir besoin de traitement d'image multimodal, ce qui le rendrait beaucoup plus efficace que d'autres jeux.

De plus, vous savez que aucun laboratoire d'IA ne s'est encore entraîné pour cela (pour l'instant !), donc c'est exempt de "benchmaxxing."

3,8K

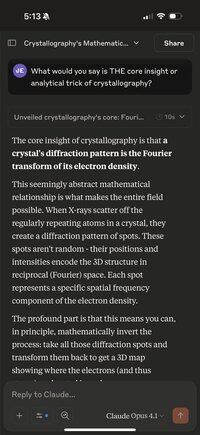

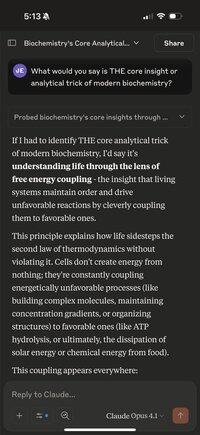

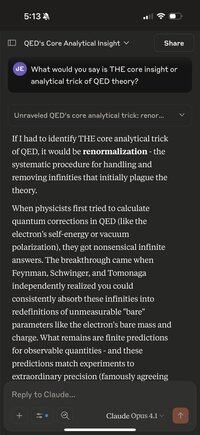

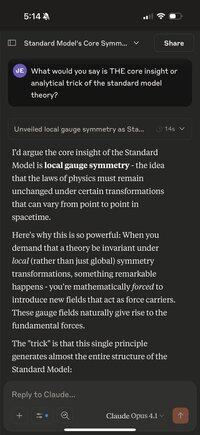

Une chose amusante à faire quand vous devez attendre quelques minutes est d'utiliser votre téléphone pour poser à Claude Opus la question suivante sur une discipline ou un domaine aléatoire :

"Quel serait selon vous LE principal aperçu ou astuce analytique de la cristallographie ?"

Remplacez cristallographie par tout ce que vous pouvez imaginer. Jusqu'à présent, j'ai essayé :

QED ; le Modèle Standard ; la Biochimie ; la Probabilité ; la théorie de l'évolution ; et bien d'autres.

Il y a quelque chose à forcer le modèle à faire l'impossible, à condenser un vaste et complexe domaine en "une astuce étrange", qui le pousse vraiment à rechercher le meilleur principe profond et unificateur dans le domaine et à l'exprimer de manière succincte.

Cela tend à être quelque chose d'évident pour les praticiens mais très probablement inconnu de la plupart des gens qui n'ont qu'un intérêt passager pour le sujet.

Fait intéressant, vous pouvez également appuyer plusieurs fois sur le bouton "réessayer" avec la même invite et parfois obtenir des explications très différentes, mais généralement très fascinantes.

J'ai déjà beaucoup appris en faisant cela, et cela pourrait bien être le plus élevé "compréhension par minute" que j'ai rencontré dans tout apprentissage autodirigé.

Parce qu'il ne s'agit pas seulement de faits amusants ou de petites anecdotes intéressantes. Ce sont, par construction, des idées pénétrantes et unificatrices qui relient une vaste quantité de théories et de phénomènes observés dans le monde.

C'est certainement beaucoup plus riche en contenu que de regarder une autre vidéo explicative sur YouTube avec des animations et des publicités pour Brilliant/KiwiCo ! Pas qu'il y ait quoi que ce soit de mal avec cela.

7,91K

L'idée qu'il y a eu un tel "exode de talents" d'OpenAI récemment qu'ils ne sont plus en mesure d'être un leader dans le domaine est aussi malavisée et erronée que l'idée que GPT-5 "a été un grand flop et que le modèle n'est pas si génial et est très incrémental."

Non seulement GPT-5 Pro est le modèle le plus intelligent au monde maintenant, et de loin, sur la plupart des tâches réelles les plus difficiles (en particulier les tâches de codage, qui ont la plus grande importance économique maintenant), mais le nouvel outil codex cli d'OpenAI est incroyablement bien exécuté.

Ils sont passés d'une troisième place lointaine dans les outils cli de codage à avoir ce qui est sans doute le meilleur actuellement (notez que j'aime toujours et utilise Claude Code, ce n'est pas l'un ou l'autre !), avec de loin la meilleure performance, la latence la plus basse, etc. parce qu'il est programmé en rust.

Et maintenant, cet outil cli est combiné avec le meilleur modèle de codage qui a la meilleure fiabilité d'appel d'outils et la meilleure cohérence sur les longues tâches, avec le moins d'hallucinations.

Et il va sans dire que leur application iOS est également dramatiquement meilleure que toutes les autres applications d'IA en termes de finition et de fonctionnalités. L'application Claude n'est que l'application web dans un bac à sable Safari ! Et leur application web est également toujours la meilleure. Des choses comme la recherche fonctionnent tout simplement mieux que dans d'autres applications. Blocage et tackling de base.

Donc, oui. Certaines personnes très intelligentes comme Ilya et John Schulman sont parties pour d'autres entreprises. Mais ils ont toujours une équipe technique absolument incroyable avec des personnes de produit incroyablement compétentes et des compétences d'ingénierie impressionnantes.

Ne laissez pas votre aversion pour Altman vous aveugler à l'évidence. Chaque fois que je vois encore une autre personne parler de la façon dont GPT-5 est mauvais, je grimace, car la personne montre qu'elle ne peut pas penser par elle-même sur la base de preuves et de raison, et a été influencée pour penser une opinion (et la répéter en ligne) parce qu'elle pense que cela la rend intelligente.

34,02K

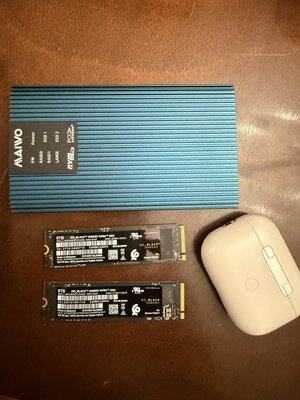

À quel point c'est génial que chacune de ces petites puces ait 8 téraoctets de stockage super rapide ? Et vous pouvez les brancher toutes les deux dans ce boîtier bleu et obtenir 20 Gbps via USB 3.3 (je n'ai pas de ports USB 4 et tous mes emplacements pci-e sont occupés par des GPU)

Nous vivons à une époque d'une telle abondance.

3,19K

En tant que mise à jour de mes deux récents fils de discussion concernant l'utilisation de GPT-5 Pro pour initier un processus de découverte de théories révolutionnaires qui combinent des applications novatrices de mathématiques avancées aux cas d'utilisation de l'IA, j'ai demandé au modèle de créer des implémentations de démonstration en Python utilisant Jax et Numpy pour chacune des 11 idées.

Ensuite, je les ai regroupées dans un projet et ajouté une belle interface en ligne de commande pour les exécuter, ainsi qu'une série de tests de bout en bout qui mesuraient si le code est mathématiquement correct, vérifiait que le code possède les propriétés mathématiques que nous souhaitons, et enfin, s'il fait quelque chose d'utile par rapport aux approches standard actuelles.

J'ai utilisé codex CLI avec GPT-5 pour intégrer le tout et corriger les bugs. Je vais lier le dépôt, qui contient une documentation détaillée pour l'ensemble du projet, puis des comptes rendus pour chacune des 11 démonstrations contenant toutes les sorties générées par le modèle pendant le processus.

3,79K

Wow, j'ai enfin pris le temps d'essayer la nouvelle version de l'interface en ligne de commande Codex d'OpenAI (leur réponse à Claude Code).

La dernière fois que j'ai essayé d'utiliser Codex (notez que c'est différent de leur agent de codage hébergé également appelé Codex, ce qui est extrêmement déroutant ; je parle maintenant de l'outil que vous exécutez localement sur votre machine dans le terminal), c'était écrit comme une application Nodejs/Typescript, et c'était vraiment assez mauvais :

- je ne pouvais accéder qu'à des modèles plus faibles comme o4-mini ou leur variante pour Codex, déroutant également appelée Codex (sérieusement ?)

- une interface utilisateur/expérience utilisateur bien pire que Claude Code

- bien moins efficace en matière de codage en raison d'un modèle moins performant, d'outils moins bons, d'un flux d'agent moins efficace.

- il vous forçait ennuyeusement à donner la permission pour tout, donc vous deviez le surveiller tout le temps, ce qui le rendait beaucoup moins utile car vous ne pouviez pas facilement exécuter plusieurs d'entre eux en parallèle.

- peut-être que c'était une bonne chose, car de loin le plus gros problème était qu'il faisait des choses super imprudentes et destructrices ; il était beaucoup plus cavalier que CC.

C'est finalement pourquoi j'ai immédiatement arrêté de l'utiliser, car il a décidé de faire un "git reset --hard HEAD" sans d'abord faire de stash, et j'ai perdu un peu de travail. Plus jamais, pensais-je.

Eh bien, j'ai enfin pris le temps d'essayer la toute nouvelle version en rust qui utilise GPT-5 et qui peut utiliser votre abonnement GPT Pro existant au lieu d'une clé API, et c'est tellement mieux que c'est choquant.

Tout d'abord, il n'y a tout simplement pas de substitut à un code compilé rapide quand il s'agit d'outils interactifs comme celui-ci.

Le fait qu'il soit écrit en rust signifie qu'il n'y a aucun retard avec l'entrée au clavier, et aussi pas d'artefacts étranges comme vous en avez dans CC où la touche de retour arrière ne fonctionne pas correctement et l'entrée est saccadée et lente parce qu'elle est écrite dans un langage interprété qui est cent fois plus lent pour ce genre de choses.

Faire face à un retard constant et à des saccades n'est pas seulement plus lent, c'est mentalement et peut-être même émotionnellement épuisant et lassant, du moins pour moi quand j'utilise ces choses pendant des heures. C'est un horrible sentiment de détester et de ressentir du ressentiment envers vos outils même si vous dépendez d'eux pour faire votre travail.

J'espère vraiment que cela élèvera le niveau pour tous ces outils et convaincra Anthropic, Google et d'autres d'utiliser également rust (ou C++, Zig, peu importe).

Mais la véritable grande amélioration est évidemment le modèle ; avec un modèle moins performant qui est peu fiable pour appeler des outils et qui perd sa cohérence sur des tâches plus longues, aucune des réactivités du Rust ne vaudrait un sou.

Mais si vous me suivez ici, alors vous savez que j'ai été en admiration devant les capacités de codage et la maîtrise des appels d'outils de GPT-5 Thinking depuis environ 15 minutes après sa sortie, bien que je l'utilise principalement depuis l'onglet agent de Cursor.

En fin de compte, ce nouveau Codex en rust est soudainement devenu un concurrent vraiment redoutable pour CC, et vous devriez absolument l'essayer.

Je vais devoir voir combien d'utilisation ils me laissent faire avec mon abonnement GPT Pro à 200 $/mois, mais si je dois en obtenir quelques autres, cela en vaudra vraiment la peine.

Notez que je n'ai pas arrêté d'utiliser CC. J'aime utiliser les deux ensemble. Et croyez-le ou non, j'utilise encore aussi Cursor.

Les gens devraient arrêter de chercher l'outil unique qui remplace tous les autres et accepter que différents outils ont différentes forces et faiblesses, et que vous obtenez les meilleurs résultats en apprenant tout cela de manière intuitive grâce à une utilisation constante.

Quoi qu'il en soit, faites-vous une faveur et procurez-vous cela maintenant. Le moyen le plus simple est de faire cette commande (notez que cela vous obtiendra la version rust, malgré la confusion d'utiliser bun/npm pour cela) :

bun i -g @openai/codex

8,57K

Wow, j'ai enfin pris le temps d'essayer la nouvelle version de l'interface en ligne de commande Codex d'OpenAI (leur réponse à Claude Code).

La dernière fois que j'ai essayé d'utiliser Codex (notez que c'est différent de leur agent de codage hébergé également appelé Codex, ce qui est extrêmement déroutant ; je parle maintenant de l'outil que vous exécutez localement sur votre machine dans le terminal), c'était écrit comme une application Nodejs/Typescript, et c'était vraiment assez mauvais :

- je ne pouvais accéder qu'à des modèles plus faibles comme o4-mini ou leur variante pour Codex, déroutant également appelée Codex (sérieusement ?)

- une interface utilisateur/expérience utilisateur bien pire que Claude Code

- beaucoup moins efficace en matière de codage en raison d'un modèle moins performant, d'outils moins bons, d'un flux d'agent moins efficace.

- il vous forçait ennuyeusement à donner la permission pour tout, donc vous deviez le surveiller tout le temps, ce qui le rendait beaucoup moins utile car vous ne pouviez pas facilement exécuter plusieurs d'entre eux en parallèle.

- peut-être que c'était une bonne chose, car de loin le plus gros problème était qu'il faisait des choses super imprudentes et destructrices ; il était beaucoup plus cavalier que CC. C'est finalement pourquoi j'ai immédiatement cessé de l'utiliser, car il a décidé de faire un "reset --hard HEAD" sans d'abord sauvegarder, et j'ai perdu un peu de travail. Plus jamais, pensais-je.

Eh bien, j'ai enfin pris le temps d'essayer la toute nouvelle version en Rust qui utilise GPT-5 et qui peut utiliser votre abonnement GPT Pro existant au lieu d'une clé API, et c'est tellement mieux que c'est choquant.

Tout d'abord, il n'y a tout simplement pas de substitut à un code compilé rapide quand il s'agit d'outils interactifs comme celui-ci.

Le fait qu'il soit écrit en Rust signifie qu'il n'y a aucun retard avec l'entrée au clavier, et aussi pas d'artefacts étranges comme vous en avez dans CC où la touche de retour arrière ne fonctionne pas correctement et l'entrée est saccadée et lente parce qu'elle est écrite dans un langage interprété qui est cent fois plus lent pour ce genre de choses.

Faire face à un retard constant et à des saccades n'est pas seulement plus lent, c'est mentalement et peut-être même émotionnellement épuisant et lassant, du moins pour moi quand j'utilise ces choses pendant des heures. C'est une horrible sensation de détester et de ressentir du ressentiment envers vos outils même si vous dépendez d'eux pour faire votre travail.

J'espère vraiment que cela élèvera le niveau pour tous ces outils et convaincra Anthropic, Google et d'autres d'utiliser également Rust (ou C++, Zig, peu importe).

Mais la véritable grande amélioration est évidemment le modèle ; avec un modèle moins performant qui est peu fiable pour appeler des outils et qui perd sa cohérence sur des tâches plus longues, aucune des réactivités de Rust ne vaudrait un sou.

Mais si vous me suivez ici, alors vous savez que j'ai été en admiration devant les capacités de codage et la maîtrise des appels d'outils de GPT-5 Thinking depuis environ 15 minutes après sa sortie, bien que je l'utilise principalement depuis l'onglet agent de Cursor.

En fin de compte, ce nouveau Codex en Rust est soudainement devenu un concurrent véritablement redoutable pour CC, et vous devriez absolument l'essayer.

Je vais devoir voir combien d'utilisation ils me laissent faire avec mon abonnement GPT Pro à 200 $/mois, mais si je dois en obtenir quelques autres, cela en vaudra vraiment la peine.

Notez que je n'ai pas cessé d'utiliser CC. J'aime utiliser les deux ensemble. Et croyez-le ou non, j'utilise encore aussi Cursor.

Les gens devraient cesser de chercher l'outil unique qui remplace tous les autres et accepter que différents outils ont différentes forces et faiblesses, et que vous obtenez les meilleurs résultats en apprenant tout cela intuitivement par une utilisation constante.

Quoi qu'il en soit, faites-vous une faveur et procurez-vous cela maintenant. Le moyen le plus simple est de faire cette commande (notez que cela vous obtiendra la version Rust, malgré la confusion d'utiliser bun/npm pour cela) :

bun i -g @openai/codex

682

Je suis absolument convaincu que les modèles d'IA les plus intelligents actuellement disponibles, GPT-5 Pro et Grok4 Heavy, sont déjà suffisamment intelligents et certainement assez compétents en mathématiques et en IA pour concevoir et développer d'importantes découvertes théoriques et pratiques, à condition d'avoir le bon type de suggestions astucieuses.

47,97K

Meilleurs

Classement

Favoris

Tendance on-chain

Tendance sur X

Récents financements de premier plan

Les plus notables