المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

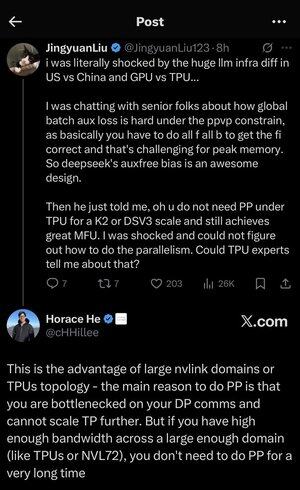

لقد ضاعت قليلا في جميع الاختصارات والمصطلحات هنا ، لذلك طلبت من كلود شرحها دون استخدام أي اختصارات والآن كل شيء منطقي تماما (tldr ؛ النطاق الترددي ⟹ البساطة):

هذه مناقشة فنية رائعة حول تدريب نماذج لغوية كبيرة على نطاق واسع.

المحادثة الأساسية

يعرب Jingyuan Liu عن دهشته من اكتشاف أنك لست بحاجة إلى تقنيات تحسين معقدة معينة عند استخدام TPUs (وحدات معالجة Tensor - رقائق الذكاء الاصطناعي المتخصصة من Google) مقابل وحدات معالجة الرسومات (وحدات معالجة الرسومات - عادة رقائق NVIDIA).

شرح المفاهيم الفنية الرئيسية:

أنواع الأجهزة:

•وحدة معالجة الرسومات: مصممة في الأصل للرسومات، وتستخدم الآن بكثافة في الذكاء الاصطناعي. تهيمن NVIDIA على هذا السوق.

•TPU (وحدة معالجة الموتر): رقائق Google المصممة خصيصا للتعلم الآلي.

استراتيجيات التوازي:

عند تدريب نماذج الذكاء الاصطناعي الضخمة ، تحتاج إلى تقسيم العمل عبر العديد من الرقائق. هناك عدة طرق للقيام بذلك:

1) توازي البيانات (DP): تعالج كل شريحة دفعات مختلفة من البيانات بنفس نسخة النموذج

2) توازي الموتر (TP): يتم تقسيم العمليات الرياضية للنموذج عبر الرقائق

3) توازي خطوط الأنابيب (PP): يتم وضع طبقات مختلفة من النموذج على رقائق مختلفة ، مما يؤدي إلى إنشاء خط أنابيب

التحدي الفني الذي تتم مناقشته:

مشكلة الخسارة المساعدة: عند تدريب النماذج الكبيرة جدا ، غالبا ما تضيف "خسائر مساعدة" (أهداف تدريب إضافية) في الطبقات الوسيطة لمساعدة التدرجات على التدفق بشكل أفضل عبر الشبكة. في ظل قيود PPVP (التوازي بين خط الأنابيب والتقسيم المتغير) ، يصبح هذا معقدا للأسباب التالية:

• تحتاج إلى القيام ب "all f all b" (جميع التمريرات الأمامية ، ثم جميع التمريرات للخلف)

•يمثل هذا تحديا لاستخدام الذاكرة القصوى لأنه يتعين عليك تخزين النتائج الوسيطة

ابتكار DeepSeek: لقد طوروا تصميم "تحيز خال من الأمور" يتجنب على ما يبدو الحاجة إلى هذه الخسائر المساعدة مع الاستمرار في التدريب بفعالية.

الوحي المفاجئ:

أخبر كبير الخبراء Jingyuan أنه باستخدام TPUs على نطاق K2 أو DSV3 (هذه تكوينات مجموعة مع مئات أو آلاف الرقائق) ، يمكنك تحقيق MFU ممتاز (استخدام نموذج FLOPs - بشكل أساسي مدى كفاءة استخدامك للأجهزة) دون استخدام Pipeline Parallelism.

لماذا هذا مفاجئ؟

• يعتبر التوازي في خطوط الأنابيب ضروريا للتدريب على نطاق واسع

• إنها تقنية معقدة تتطلب تحسينا دقيقا

• القدرة على تجنبه يبسط كل شيء بشكل كبير

هوراس هو شرح:

يشرح لماذا هذا ممكن مع TPUs:

ميزة النطاق الترددي: تتمتع وحدات TPU ومجموعات NVIDIA المتطورة (مثل NVL72 - أحدث تكوين ل NVIDIA 72-GPU مع وصلات NVLink) بعرض نطاق ترددي عال بين الرقائق بحيث يمكنها التعامل مع متطلبات الاتصال دون Pipeline Parallelism.

البصيرة الرئيسية:

•هناك حاجة إلى التوازي في خط الأنابيب بشكل أساسي عندما تكون "منتقدا في اتصالات DP" (محدودة بمدى سرعة الاتصال أثناء التدريب المتوازي للبيانات)

•إذا كان لديك نطاق ترددي كاف عبر مجال كبير بما يكفي (مجموعة مترابطة)، فيمكنك فقط استخدام استراتيجيات التوازي الأبسط

• يعمل هذا "لفترة طويلة جدا" - مما يعني أنه يمكنك تدريب حتى الطرز الكبيرة جدا دون الوصول إلى الحدود

الحدس:

فكر في الأمر كنظام طرق سريعة:

• تشبه مجموعات GPU التقليدية وجود طرق ضيقة بين المدن ، لذلك تحتاج إلى توجيه معقد (Pipeline Parallelism) لتجنب الاختناقات المرورية

• تشبه مجموعات TPU أو وحدات معالجة الرسومات المتصلة ب NVLink وجود طرق سريعة ضخمة - يمكنك فقط إرسال كل شيء مباشرة دون توجيه خيالي

هذه مشكلة كبيرة لأن Pipeline Parallelism معقد للتنفيذ والتصحيح والتحسين. القدرة على تجنبها مع الاستمرار في تحقيق كفاءة عالية تجعل عملية التدريب بأكملها أبسط بكثير وأكثر موثوقية.

تسلط المناقشة الضوء على كيف يمكن للتقدم في تقنية ربط الأجهزة ("الطرق" بين الرقائق) أن يغير بشكل أساسي استراتيجيات البرامج اللازمة للتدريب الفعال على الذكاء الاصطناعي.

7.3K

لقد ضاعت قليلا في جميع الاختصارات والمصطلحات هنا ، لذلك طلبت من كلود شرحها دون استخدام أي اختصارات والآن كل شيء منطقي تماما (tldr ؛ النطاق الترددي ⟹ البساطة):

هذه مناقشة فنية رائعة حول تدريب نماذج لغوية كبيرة على نطاق واسع.

المحادثة الأساسية

يعرب Jingyuan Liu عن دهشته من اكتشاف أنك لست بحاجة إلى تقنيات تحسين معقدة معينة عند استخدام TPUs (وحدات معالجة Tensor - رقائق الذكاء الاصطناعي المتخصصة من Google) مقابل وحدات معالجة الرسومات (وحدات معالجة الرسومات - عادة رقائق NVIDIA).

شرح المفاهيم الفنية الرئيسية:

أنواع الأجهزة:

•وحدة معالجة الرسومات: مصممة في الأصل للرسومات، وتستخدم الآن بكثافة في الذكاء الاصطناعي. تهيمن NVIDIA على هذا السوق.

•TPU (وحدة معالجة الموتر): رقائق Google المصممة خصيصا للتعلم الآلي.

استراتيجيات التوازي:

عند تدريب نماذج الذكاء الاصطناعي الضخمة ، تحتاج إلى تقسيم العمل عبر العديد من الرقائق. هناك عدة طرق للقيام بذلك:

1توازي البيانات (DP): تعالج كل شريحة دفعات مختلفة من البيانات بنفس نسخة النموذج

2توازي الموتر (TP): يتم تقسيم العمليات الرياضية للنموذج عبر الرقائق

3 التوازي لخطوط الأنابيب (PP): يتم وضع طبقات مختلفة من النموذج على رقائق مختلفة ، مما يؤدي إلى إنشاء خط أنابيب

التحدي الفني الذي تتم مناقشته:

مشكلة الخسارة المساعدة: عند تدريب النماذج الكبيرة جدا ، غالبا ما تضيف "خسائر مساعدة" (أهداف تدريب إضافية) في الطبقات الوسيطة لمساعدة التدرجات على التدفق بشكل أفضل عبر الشبكة. في ظل قيود PPVP (التوازي بين خط الأنابيب والتقسيم المتغير) ، يصبح هذا معقدا للأسباب التالية:

• تحتاج إلى القيام ب "all f all b" (جميع التمريرات الأمامية ، ثم جميع التمريرات للخلف)

•يمثل هذا تحديا لاستخدام الذاكرة القصوى لأنه يتعين عليك تخزين النتائج الوسيطة

ابتكار DeepSeek: لقد طوروا تصميم "تحيز خال من الأمور" يتجنب على ما يبدو الحاجة إلى هذه الخسائر المساعدة مع الاستمرار في التدريب بفعالية.

الوحي المفاجئ:

أخبر كبير الخبراء Jingyuan أنه باستخدام TPUs على نطاق K2 أو DSV3 (هذه تكوينات مجموعة مع مئات أو آلاف الرقائق) ، يمكنك تحقيق MFU ممتاز (استخدام نموذج FLOPs - بشكل أساسي مدى كفاءة استخدامك للأجهزة) دون استخدام Pipeline Parallelism.

لماذا هذا مفاجئ؟

• يعتبر التوازي في خطوط الأنابيب ضروريا للتدريب على نطاق واسع

• إنها تقنية معقدة تتطلب تحسينا دقيقا

• القدرة على تجنبه يبسط كل شيء بشكل كبير

هوراس هو شرح:

يشرح لماذا هذا ممكن مع TPUs:

ميزة النطاق الترددي: تتمتع وحدات TPU ومجموعات NVIDIA المتطورة (مثل NVL72 - أحدث تكوين ل NVIDIA 72-GPU مع وصلات NVLink) بعرض نطاق ترددي عال بين الرقائق بحيث يمكنها التعامل مع متطلبات الاتصال دون Pipeline Parallelism.

البصيرة الرئيسية:

•هناك حاجة إلى التوازي في خط الأنابيب بشكل أساسي عندما تكون "منتقدا في اتصالات DP" (محدودة بمدى سرعة الاتصال أثناء التدريب المتوازي للبيانات)

•إذا كان لديك نطاق ترددي كاف عبر مجال كبير بما يكفي (مجموعة مترابطة)، فيمكنك فقط استخدام استراتيجيات التوازي الأبسط

• يعمل هذا "لفترة طويلة جدا" - مما يعني أنه يمكنك تدريب حتى الطرز الكبيرة جدا دون الوصول إلى الحدود

الحدس:

فكر في الأمر كنظام طرق سريعة:

• تشبه مجموعات GPU التقليدية وجود طرق ضيقة بين المدن ، لذلك تحتاج إلى توجيه معقد (Pipeline Parallelism) لتجنب الاختناقات المرورية

• تشبه مجموعات TPU أو وحدات معالجة الرسومات المتصلة ب NVLink وجود طرق سريعة ضخمة - يمكنك فقط إرسال كل شيء مباشرة دون توجيه خيالي

هذه مشكلة كبيرة لأن Pipeline Parallelism معقد للتنفيذ والتصحيح والتحسين. القدرة على تجنبها مع الاستمرار في تحقيق كفاءة عالية تجعل عملية التدريب بأكملها أبسط بكثير وأكثر موثوقية.

تسلط المناقشة الضوء على كيف يمكن للتقدم في تقنية ربط الأجهزة ("الطرق" بين الرقائق) أن يغير بشكل أساسي استراتيجيات البرامج اللازمة للتدريب الفعال على الذكاء الاصطناعي.

3.33K

أنا مندهش نوعا ما من عدم قيام أي شخص حتى الآن بإنشاء خادم Dwarf Fortress MCP الذي يمكن أن يسمح لوكيل مثل Codex أو Claude Code بالتحكم بكفاءة في اللعبة ومراقبة الحالة والتقدم.

لم ألعبها أبدا ، فقط قمت بتنزيلها وفحصتها لفترة وجيزة منذ حوالي 10 سنوات ، لكنني استمتعت بالقراءة عنها.

يبدو أنه سيكون اختبارا جيدا جدا لماجستير في القانون لمعرفة المدة التي يمكن أن تبقي فيها الأقزام على قيد الحياة ومزدهرة.

نظرا لأن كل لعبة تؤدي في النهاية إلى كارثة متتالية تتسبب في موت جميع الأقزام ، يجب أن تكون هناك نقطة توقف طبيعية لها ، مما يجعلها مرشحا معياريا جيدا. على الأقل هذا هو فهمي لذلك (شعار اللاعبين هو "الخسارة ممتعة").

سيعتمد القيام بعمل جيد مع هذه الألعاب على دقة استدعاء الأدوات والتماسك المستمر للمهام الطويلة ، بالإضافة إلى القدرة على مراقبة وفهم ديناميكيات النظام المعقد وإجراء تدخلات في الوقت المناسب لتوقع المشكلات ومواجهتها.

ونظرا لأنه أصلي في المحطة ، يمكن نقله ومعالجته بكفاءة باستخدام الرموز المميزة العادية دون الحاجة إلى معالجة صور متعددة الوسائط ، مما يجعلها أكثر كفاءة بكثير من الألعاب الأخرى.

بالإضافة إلى أنك تعلم أنه لم تتدرب أي مختبرات الذكاء الاصطناعي على هذا (حتى الآن!) ، لذا فهو غير ملوث ب "benchmaxxing".

3.8K

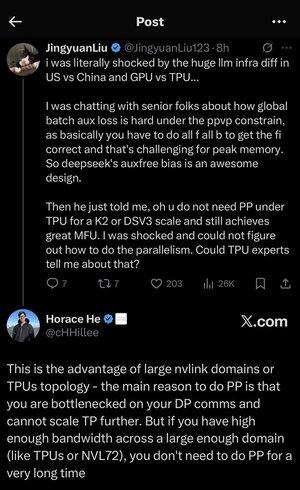

من الأشياء الممتعة التي يجب القيام بها عندما تحتاج إلى الانتظار لبضع دقائق استخدام هاتفك لطرح السؤال التالي على كلود أوبوس حول بعض الانضباط أو المجالات العشوائية:

"ما هي البصيرة الأساسية أو الخدعة التحليلية لعلم البلورات؟"

استبدل علم البلورات بأي شيء يخطر ببالك. حتى الآن ، حاولت:

QED. النموذج القياسي. كيمياء حيوية; احتمال; نظرية التطور. وغيرها الكثير.

هناك شيء ما حول إجبار النموذج على فعل المستحيل ، لتكثيف حقل شاسع ومعقد في "خدعة واحدة غريبة" ، مما يجعله يبحث حقا عن أفضل مبدأ عميق وموحد في هذا المجال ثم يعبر عنه بإيجاز.

يميل هذا إلى أن يكون شيئا واضحا للممارسين ولكن من المحتمل جدا أن يكون غير معروف من قبل معظم الأشخاص الذين لديهم اهتمام عابر بالموضوع.

ومن المثير للاهتمام ، أنه يمكنك أيضا الضغط بشكل متكرر على زر "إعادة المحاولة" بنفس المطالبة وأحيانا الحصول على تفسيرات مختلفة تماما ، ولكنها عادة ما تكون رائعة للغاية.

لقد تعلمت بالفعل الكثير من القيام بذلك ، وقد يكون أعلى "فهم في الدقيقة" واجهته في أي تعلم موجه ذاتيا.

لأنها ليست مجرد حقائق ممتعة أو حكايات رائعة. إنها ، من خلال البناء ، تخترق وتوحيد الأفكار التي تربط معا كمية هائلة من النظرية والظواهر المرصودة في العالم.

من المؤكد أنه نطاق ترددي عال أكثر بكثير من مشاهدة مقطع فيديو توضيحي آخر على YouTube مع رسوم متحركة وإعلانات ل Brilliant / KiwiCo! لا يعني ذلك أن هناك أي خطأ في هؤلاء.

7.91K

إن فكرة حدوث مثل هذا "هجرة المواهب" من OpenAI مؤخرا لدرجة أنهم لم يعودوا في وضع يسمح لهم بأن يكونوا رائدين في الفضاء هي فكرة مضللة وخاطئة مثل فكرة أن GPT-5 "كان فاشلا كبيرا وأن النموذج ليس بهذه الروعة وتدريجي للغاية".

لا يقتصر الأمر على أن GPT-5 Pro هو النموذج الأذكى في العالم الآن إلى حد كبير جدا في معظم المهام الواقعية تحديا (خاصة مهام الترميز ، والتي لها أهمية اقتصادية أكبر الآن) ، ولكن أداة Codex CLI الجديدة من OpenAI يتم تنفيذها بشكل جيد بشكل لا يصدق.

لقد انتقلوا من المركز الثالث البعيد في أدوات CLI للترميز إلى الحصول على ما يمكن القول إنه الأفضل الآن (لاحظ أنني ما زلت أحب وأستخدم Claude Code ، فهو ليس إما / أو!) ، مع أفضل أداء إلى حد بعيد ، وأقل زمن انتقال ، وما إلى ذلك لأنه مبرمج في الصدأ.

والآن يتم دمج أداة cli هذه مع أفضل نموذج ترميز يتمتع بأفضل موثوقية لاستدعاء الأدوات وأفضل تماسك للمهام الطويلة ، مع أقل قدر من الهلوسة.

وغني عن القول ، أن تطبيق iOS الخاص بهم أفضل أيضا بشكل كبير من جميع تطبيقات الذكاء الاصطناعي الأخرى من حيث التلميع والميزات. تطبيق كلود هو مجرد تطبيق ويب في وضع الحماية في سفاري! ولا يزال تطبيق الويب الخاص بهم هو الأفضل أيضا. تعمل أشياء مثل البحث بشكل أفضل من التطبيقات الأخرى. الحجب الأساسي والمعالجة.

لذا نعم. غادر بعض الأشخاص الأذكياء جدا مثل إيليا وجون شولمان إلى شركات أخرى. لكن لا يزال لديهم فريق تقني رائع للغاية مع أشخاص جيدين بشكل لا يصدق في مجال المنتجات وقطع هندسية رائعة.

لا تدع نفورك من ألتمان يعميك عن ما هو واضح. كلما رأيت شخصا آخر يتحدث عن مدى سوء GPT-5 ، أتأرجح ، لأن الشخص يظهر أنه لا يستطيع التفكير بنفسه بناء على الأدلة والعقل ، وقد انغمس في التفكير في رأي (ونشره عبر الإنترنت) لأنهم يعتقدون أنه يجعله يبدو ذكيا.

34.02K

كتحديث لموضوعي الأخيرين حول استخدام GPT-5 Pro لبدء عملية اكتشاف نظريات اختراق تجمع بين التطبيقات الجديدة للرياضيات المتقدمة وحالات استخدام الذكاء الاصطناعي ، كان لدي النموذج ينشئ تطبيقات تجريبية في Python باستخدام Jax و Numpy لكل فكرة من الأفكار ال 11.

ثم قمت بتجميعها معا في مشروع وأضفت CLI لطيفا لتشغيلها ، وسلسلة من الاختبارات الشاملة التي تقيس ما إذا كان الكود صحيحا رياضيا ، وتتحقق من أن الكود يحتوي على الخصائص الرياضية التي نريدها ، وأخيرا ، ما إذا كان يفعل أي شيء مفيد مقابل الأساليب القياسية الحالية.

لقد استخدمت codex CLI مع GPT-5 لدمج كل شيء وإصلاح الأخطاء. سأقوم بالارتباط بالريبو ، الذي يحتوي على وثائق مفصلة للمشروع بأكمله ثم عمليات الكتابة لكل من العروض التوضيحية ال 11 التي تحتوي على جميع المخرجات التي تم إنشاؤها بواسطة النموذج أثناء العملية.

3.79K

واو ، لقد تمكنت أخيرا من تجربة الإصدار الجديد من Codex CLI من OpenAI (إجابتهم على كود كلود).

آخر مرة حاولت فيها استخدام المخطوطة (لاحظ أن هذا يختلف عن عامل الترميز المستضاف المسمى أيضا المخطوطة ، وهو أمر محير للغاية ؛ أنا أتحدث الآن عن الأداة التي تقوم بتشغيلها محليا على جهازك في المحطة) ، وقد تمت كتابتها كتطبيق Nodejs / Typescript ، وهي حقا نوع من الامتصاص:

- يمكن الوصول فقط إلى النماذج الأضعف مثل O4-mini أو متغيرها للمخطوطة ، والتي تسمى أيضا CodeX (على محمل الجد؟)

- واجهة مستخدم / تجربة مستخدم أسوأ بكثير من كود كلود

- أسوأ بكثير في الترميز نتيجة لنموذج أسوأ ، وأدوات أسوأ ، وتدفق أسوأ للوكيل.

- لقد أجبرك بشكل مزعج على منح الإذن لكل شيء ، لذلك كان عليك مجالسة الأطفال طوال الوقت ، مما يجعله أقل فائدة لأنه لا يمكنك تشغيل مجموعة منهم بالتوازي بسهولة.

- ربما كان هذا شيئا جيدا ، لأن المشكلة الأكبر كانت إلى حد بعيد هي أنها فعلت أشياء متهورة ومدمرة للغاية. لقد كان أكثر تعجرفا من CC.

هذا هو السبب في أنني توقفت على الفور عن استخدامه ، حيث قرر القيام ب "إعادة تعيين git - hard HEAD" دون إخفاؤه أولا ، وفقدت بعض العمل. لم يحدث ذلك مرة أخرى ، كما اعتقدت.

حسنا ، لقد تمكنت أخيرا من تجربة إصدار الصدأ الجديد تماما الذي يستخدم GPT-5 والذي يمكنه استخدام اشتراك GPT Pro الحالي بدلا من مفتاح API ، وهذا أفضل بكثير لدرجة أنه أمر صادم.

بادئ ذي بدء ، ببساطة لا يوجد بديل عن التعليمات البرمجية المجمعة السريعة عندما يتعلق الأمر بالأدوات التفاعلية مثل هذه.

حقيقة أنه مكتوب بالصدأ يعني أنه لا يوجد تأخير على الإطلاق في إدخال لوحة المفاتيح ، وأيضا لا توجد قطع أثرية غريبة مثل CC حيث لا تعمل المساحة الخلفية بشكل صحيح والإدخال غير مألوف وبطيء لأنه مكتوب بلغة مفسرة أبطأ مائة مرة لأشياء مثل هذه.

إن التعامل مع التأخير المستمر والهراء ليس أبطأ فحسب ، بل إنه مرهق عقليا وربما عاطفيا ومرهقا ، على الأقل بالنسبة لي عندما أستخدم هذه الأشياء لساعات متتالية. إنه شعور فظيع أن تكره أدواتك وتستاء منها حتى وأنت تعتمد عليها للقيام بعملك.

آمل حقا أن يرفع هذا مستوى كل هذه الأدوات ويقنع Anthropic و Google وآخرين باستخدام الصدأ أيضا (أو C ++ ، Zig ، أيا كان).

لكن من الواضح أن التحسن الكبير حقا هو النموذج. مع نموذج أسوأ لا يمكن الاعتماد عليه في استدعاء الأدوات والذي يفقد التماسك خلال المهام الأطول ، لن يكون أي من سرعة الصدأ يستحق اللعنة.

ولكن إذا تابعتني هنا ، فستعرف أنني كنت في حالة من الرهبة من قدرات الترميز في GPT-5 Thinking وبراعة استدعاء الأدوات منذ حوالي 15 دقيقة من ظهورها ، على الرغم من أنني كنت أستخدمها بشكل أساسي من داخل علامة تبويب وكيل المؤشر.

خلاصة القول هي أن مخطوطة الصدأ الجديدة هذه أصبحت فجأة منافسا هائلا حقا ل CC ، ويجب أن تجربها تماما.

سأحتاج إلى معرفة مقدار الاستخدام الذي سمحوا لي به في اشتراكي في GPT Pro بقيمة 200 دولار شهريا ، ولكن إذا اضطررت إلى الحصول على زوجين آخرين ، فسيكون الأمر يستحق ذلك.

لاحظ أنني لم أتوقف عن استخدام CC. أحب استخدام كلاهما معا. وصدق أو لا تصدق ، ما زلت أستخدم المؤشر أيضا.

يجب على الأشخاص التوقف عن البحث عن أداة واحدة تحل محل جميع الأدوات الأخرى واحتضان أن الأدوات المختلفة لها نقاط قوة وضعف مختلفة ، وتحصل على أفضل النتائج من خلال تعلم كل ذلك بشكل حدسي من الاستخدام المستمر.

على أي حال ، افعل لنفسك معروفا واحصل عليه الآن. أسهل طريقة هي القيام بهذا الأمر (لاحظ أن هذا سيوفر لك إصدار الصدأ ، على الرغم من مدى إرباك استخدام bun / npm لهذا الغرض):

كعكة I -G @openai / مخطوطة

8.57K

واو ، لقد تمكنت أخيرا من تجربة الإصدار الجديد من Codex CLI من OpenAI (إجابتهم على كود كلود).

آخر مرة حاولت فيها استخدام المخطوطة (لاحظ أن هذا يختلف عن عامل الترميز المستضاف المسمى أيضا المخطوطة ، وهو أمر محير للغاية ؛ أنا أتحدث الآن عن الأداة التي تقوم بتشغيلها محليا على جهازك في المحطة) ، وقد تمت كتابتها كتطبيق Nodejs / Typescript ، وهي حقا نوع من الامتصاص:

- يمكن الوصول فقط إلى النماذج الأضعف مثل O4-mini أو متغيرها للمخطوطة ، والتي تسمى أيضا CodeX (على محمل الجد؟)

- واجهة مستخدم / تجربة مستخدم أسوأ بكثير من كود كلود

- أسوأ بكثير في الترميز نتيجة لنموذج أسوأ ، وأدوات أسوأ ، وتدفق أسوأ للوكيل.

- لقد أجبرك بشكل مزعج على منح الإذن لكل شيء ، لذلك كان عليك مجالسة الأطفال طوال الوقت ، مما يجعله أقل فائدة لأنه لا يمكنك تشغيل مجموعة منهم بالتوازي بسهولة.

- ربما كان هذا شيئا جيدا ، لأن المشكلة الأكبر كانت إلى حد بعيد هي أنها فعلت أشياء متهورة ومدمرة للغاية. لقد كان أكثر تعجرفا من CC. لهذا السبب توقفت في النهاية عن استخدامه على الفور ، حيث قررت إجراء "إعادة تعيين - رأس صعب" دون إخفاؤه أولا ، وفقدت بعض العمل. لم يحدث ذلك مرة أخرى ، كما اعتقدت.

حسنا ، لقد تمكنت أخيرا من تجربة إصدار الصدأ الجديد تماما الذي يستخدم GPT-5 والذي يمكنه استخدام اشتراك GPT Pro الحالي بدلا من مفتاح API ، وهذا أفضل بكثير لدرجة أنه أمر صادم.

بادئ ذي بدء ، ببساطة لا يوجد بديل عن التعليمات البرمجية المجمعة السريعة عندما يتعلق الأمر بالأدوات التفاعلية مثل هذه.

حقيقة أنه مكتوب بالصدأ يعني أنه لا يوجد تأخير على الإطلاق في إدخال لوحة المفاتيح ، وأيضا لا توجد قطع أثرية غريبة مثل CC حيث لا تعمل المساحة الخلفية بشكل صحيح والإدخال غير مألوف وبطيء لأنه مكتوب بلغة مفسرة أبطأ مائة مرة لأشياء مثل هذه.

إن التعامل مع التأخير المستمر والهراء ليس أبطأ فحسب ، بل إنه مرهق عقليا وربما عاطفيا ومرهقا ، على الأقل بالنسبة لي عندما أستخدم هذه الأشياء لساعات متتالية. إنه شعور فظيع أن تكره أدواتك وتستاء منها حتى وأنت تعتمد عليها للقيام بعملك.

آمل حقا أن يرفع هذا مستوى كل هذه الأدوات ويقنع Anthropic و Google وآخرين باستخدام الصدأ أيضا (أو C ++ ، Zig ، أيا كان).

لكن من الواضح أن التحسن الكبير حقا هو النموذج. مع نموذج أسوأ لا يمكن الاعتماد عليه في استدعاء الأدوات والذي يفقد التماسك خلال المهام الأطول ، لن يكون أي من سرعة الصدأ يستحق اللعنة.

ولكن إذا تابعتني هنا ، فستعرف أنني كنت في حالة من الرهبة من قدرات الترميز في GPT-5 Thinking وبراعة استدعاء الأدوات منذ حوالي 15 دقيقة من ظهورها ، على الرغم من أنني كنت أستخدمها بشكل أساسي من داخل علامة تبويب وكيل المؤشر.

خلاصة القول هي أن مخطوطة الصدأ الجديدة هذه أصبحت فجأة منافسا هائلا حقا ل CC ، ويجب أن تجربها تماما.

سأحتاج إلى معرفة مقدار الاستخدام الذي سمحوا لي به في اشتراكي في GPT Pro بقيمة 200 دولار شهريا ، ولكن إذا اضطررت إلى الحصول على زوجين آخرين ، فسيكون الأمر يستحق ذلك.

لاحظ أنني لم أتوقف عن استخدام CC. أحب استخدام كلاهما معا. وصدق أو لا تصدق ، ما زلت أستخدم المؤشر أيضا.

يجب على الأشخاص التوقف عن البحث عن أداة واحدة تحل محل جميع الأدوات الأخرى واحتضان أن الأدوات المختلفة لها نقاط قوة وضعف مختلفة ، وتحصل على أفضل النتائج من خلال تعلم كل ذلك بشكل حدسي من الاستخدام المستمر.

على أي حال ، افعل لنفسك معروفا واحصل عليه الآن. أسهل طريقة هي القيام بهذا الأمر (لاحظ أن هذا سيوفر لك إصدار الصدأ ، على الرغم من مدى إرباك استخدام bun / npm لهذا الغرض):

كعكة I -G @openai / مخطوطة

683

الأفضل

المُتصدِّرة

التطبيقات المفضلة

رائج على السلسة

رائج على منصة X

أهم عمليات التمويل الأخيرة

الأبرز