المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

لقد ضاعت قليلا في جميع الاختصارات والمصطلحات هنا ، لذلك طلبت من كلود شرحها دون استخدام أي اختصارات والآن كل شيء منطقي تماما (tldr ؛ النطاق الترددي ⟹ البساطة):

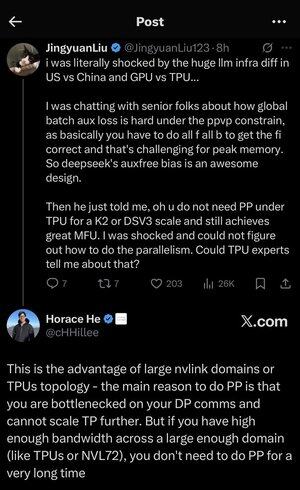

هذه مناقشة فنية رائعة حول تدريب نماذج لغوية كبيرة على نطاق واسع.

المحادثة الأساسية

يعرب Jingyuan Liu عن دهشته من اكتشاف أنك لست بحاجة إلى تقنيات تحسين معقدة معينة عند استخدام TPUs (وحدات معالجة Tensor - رقائق الذكاء الاصطناعي المتخصصة من Google) مقابل وحدات معالجة الرسومات (وحدات معالجة الرسومات - عادة رقائق NVIDIA).

شرح المفاهيم الفنية الرئيسية:

أنواع الأجهزة:

•وحدة معالجة الرسومات: مصممة في الأصل للرسومات، وتستخدم الآن بكثافة في الذكاء الاصطناعي. تهيمن NVIDIA على هذا السوق.

•TPU (وحدة معالجة الموتر): رقائق Google المصممة خصيصا للتعلم الآلي.

استراتيجيات التوازي:

عند تدريب نماذج الذكاء الاصطناعي الضخمة ، تحتاج إلى تقسيم العمل عبر العديد من الرقائق. هناك عدة طرق للقيام بذلك:

1) توازي البيانات (DP): تعالج كل شريحة دفعات مختلفة من البيانات بنفس نسخة النموذج

2) توازي الموتر (TP): يتم تقسيم العمليات الرياضية للنموذج عبر الرقائق

3) توازي خطوط الأنابيب (PP): يتم وضع طبقات مختلفة من النموذج على رقائق مختلفة ، مما يؤدي إلى إنشاء خط أنابيب

التحدي الفني الذي تتم مناقشته:

مشكلة الخسارة المساعدة: عند تدريب النماذج الكبيرة جدا ، غالبا ما تضيف "خسائر مساعدة" (أهداف تدريب إضافية) في الطبقات الوسيطة لمساعدة التدرجات على التدفق بشكل أفضل عبر الشبكة. في ظل قيود PPVP (التوازي بين خط الأنابيب والتقسيم المتغير) ، يصبح هذا معقدا للأسباب التالية:

• تحتاج إلى القيام ب "all f all b" (جميع التمريرات الأمامية ، ثم جميع التمريرات للخلف)

•يمثل هذا تحديا لاستخدام الذاكرة القصوى لأنه يتعين عليك تخزين النتائج الوسيطة

ابتكار DeepSeek: لقد طوروا تصميم "تحيز خال من الأمور" يتجنب على ما يبدو الحاجة إلى هذه الخسائر المساعدة مع الاستمرار في التدريب بفعالية.

الوحي المفاجئ:

أخبر كبير الخبراء Jingyuan أنه باستخدام TPUs على نطاق K2 أو DSV3 (هذه تكوينات مجموعة مع مئات أو آلاف الرقائق) ، يمكنك تحقيق MFU ممتاز (استخدام نموذج FLOPs - بشكل أساسي مدى كفاءة استخدامك للأجهزة) دون استخدام Pipeline Parallelism.

لماذا هذا مفاجئ؟

• يعتبر التوازي في خطوط الأنابيب ضروريا للتدريب على نطاق واسع

• إنها تقنية معقدة تتطلب تحسينا دقيقا

• القدرة على تجنبه يبسط كل شيء بشكل كبير

هوراس هو شرح:

يشرح لماذا هذا ممكن مع TPUs:

ميزة النطاق الترددي: تتمتع وحدات TPU ومجموعات NVIDIA المتطورة (مثل NVL72 - أحدث تكوين ل NVIDIA 72-GPU مع وصلات NVLink) بعرض نطاق ترددي عال بين الرقائق بحيث يمكنها التعامل مع متطلبات الاتصال دون Pipeline Parallelism.

البصيرة الرئيسية:

•هناك حاجة إلى التوازي في خط الأنابيب بشكل أساسي عندما تكون "منتقدا في اتصالات DP" (محدودة بمدى سرعة الاتصال أثناء التدريب المتوازي للبيانات)

•إذا كان لديك نطاق ترددي كاف عبر مجال كبير بما يكفي (مجموعة مترابطة)، فيمكنك فقط استخدام استراتيجيات التوازي الأبسط

• يعمل هذا "لفترة طويلة جدا" - مما يعني أنه يمكنك تدريب حتى الطرز الكبيرة جدا دون الوصول إلى الحدود

الحدس:

فكر في الأمر كنظام طرق سريعة:

• تشبه مجموعات GPU التقليدية وجود طرق ضيقة بين المدن ، لذلك تحتاج إلى توجيه معقد (Pipeline Parallelism) لتجنب الاختناقات المرورية

• تشبه مجموعات TPU أو وحدات معالجة الرسومات المتصلة ب NVLink وجود طرق سريعة ضخمة - يمكنك فقط إرسال كل شيء مباشرة دون توجيه خيالي

هذه مشكلة كبيرة لأن Pipeline Parallelism معقد للتنفيذ والتصحيح والتحسين. القدرة على تجنبها مع الاستمرار في تحقيق كفاءة عالية تجعل عملية التدريب بأكملها أبسط بكثير وأكثر موثوقية.

تسلط المناقشة الضوء على كيف يمكن للتقدم في تقنية ربط الأجهزة ("الطرق" بين الرقائق) أن يغير بشكل أساسي استراتيجيات البرامج اللازمة للتدريب الفعال على الذكاء الاصطناعي.

16.73K

الأفضل

المُتصدِّرة

التطبيقات المفضلة