Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

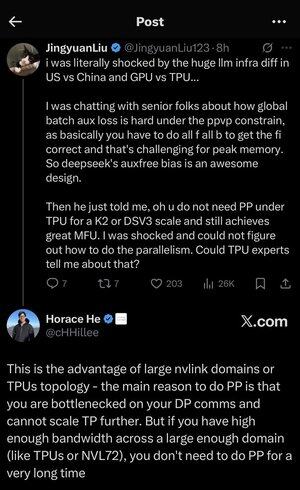

Zgubiłem się trochę w tych wszystkich akronimach i żargonie, więc poprosiłem Claude'a, aby wyjaśnił to bez używania jakichkolwiek akronimów i teraz wszystko ma sens (tldr; przepustowość ⟹ prostota):

To fascynująca dyskusja techniczna na temat trenowania dużych modeli językowych na dużą skalę.

Główna rozmowa

Jingyuan Liu wyraża zdziwienie odkryciem, że nie potrzebujesz pewnych skomplikowanych technik optymalizacji przy użyciu TPU (Tensor Processing Units - specjalizowane chipy AI Google'a) w porównaniu do GPU (Graphics Processing Units - typowo chipy NVIDIA).

Kluczowe pojęcia techniczne wyjaśnione:

Rodzaje sprzętu:

•GPU (Graphics Processing Unit): Początkowo zaprojektowane do grafiki, teraz intensywnie wykorzystywane w AI. NVIDIA dominuje na tym rynku.

•TPU (Tensor Processing Unit): Niestandardowe chipy zaprojektowane przez Google specjalnie do uczenia maszynowego.

Strategie równoległości:

Podczas trenowania ogromnych modeli AI, musisz podzielić pracę na wiele chipów. Istnieje kilka sposobów, aby to zrobić:

1) Równoległość danych (DP): Każdy chip przetwarza różne partie danych z tą samą kopią modelu.

2) Równoległość tensorowa (TP): Operacje matematyczne modelu są dzielone między chipy.

3) Równoległość potokowa (PP): Różne warstwy modelu są umieszczane na różnych chipach, tworząc potok.

Techniczne wyzwanie, które jest omawiane:

Problem strat pomocniczych: Podczas trenowania bardzo dużych modeli często dodajesz "straty pomocnicze" (dodatkowe cele treningowe) na warstwach pośrednich, aby pomóc gradientom lepiej przepływać przez sieć. W ramach ograniczeń PPVP (Pipeline Parallelism with Variable Partitioning) staje się to skomplikowane, ponieważ:

•Musisz wykonać "wszystko dla wszystkich b" (wszystkie przejścia do przodu, a następnie wszystkie przejścia do tyłu).

•To jest wyzwaniem dla szczytowego zużycia pamięci, ponieważ musisz przechowywać wyniki pośrednie.

Innowacja DeepSeek: Opracowali projekt "auxfree bias", który najwyraźniej unika potrzeby tych strat pomocniczych, jednocześnie skutecznie trenując.

Zaskakujące odkrycie:

Starszy ekspert powiedział Jingyuanowi, że przy TPU w skali K2 lub DSV3 (to są konfiguracje klastrów z setkami lub tysiącami chipów) można osiągnąć doskonałe MFU (Model FLOPs Utilization - zasadniczo jak efektywnie wykorzystujesz sprzęt) BEZ używania równoległości potokowej.

Dlaczego to jest zaskakujące?

•Równoległość potokowa jest zazwyczaj uważana za niezbędną do treningu na dużą skalę.

•To skomplikowana technika, która wymaga starannej optymalizacji.

•Możliwość jej uniknięcia znacznie upraszcza wszystko.

Wyjaśnienie Horace'a He:

Wyjaśnia, DLACZEGO to jest możliwe z TPU:

Zaleta przepustowości: TPU i wysokiej klasy klastry NVIDIA (jak NVL72 - najnowsza konfiguracja 72-GPU NVIDIA z interkonektami NVLink) mają tak wysoką przepustowość między chipami, że mogą obsługiwać wymagania komunikacyjne bez równoległości potokowej.

Kluczowy wgląd:

•Równoległość potokowa jest głównie potrzebna, gdy jesteś "wąskim gardłem w komunikacji DP" (ograniczonym przez to, jak szybko możesz komunikować się podczas treningu równoległego danych).

•Jeśli masz wystarczającą przepustowość w wystarczająco dużym obszarze (połączony klaster), możesz po prostu używać prostszych strategii równoległości.

•To działa "przez bardzo długi czas" - co oznacza, że możesz trenować nawet bardzo duże modele bez osiągania limitów.

Intuicja:

Pomyśl o tym jak o systemie autostrad:

•Tradycyjne klastry GPU są jak wąskie drogi między miastami, więc potrzebujesz skomplikowanego routingu (równoległość potokowa), aby uniknąć korków.

•Klastry TPU lub GPU połączone NVLink są jak ogromne autostrady - możesz po prostu wysłać wszystko bez wymyślania skomplikowanego routingu.

To jest duża sprawa, ponieważ równoległość potokowa jest skomplikowana do wdrożenia, debugowania i optymalizacji. Możliwość jej uniknięcia, jednocześnie osiągając wysoką efektywność, sprawia, że cały proces treningowy jest znacznie prostszy i bardziej niezawodny.

Dyskusja podkreśla, jak postępy w technologii interkonektów sprzętowych ("drogi" między chipami) mogą zasadniczo zmienić strategie oprogramowania potrzebne do efektywnego treningu AI.

7,35K

Zgubiłem się trochę w tych wszystkich akronimach i żargonie, więc poprosiłem Claude'a, aby wyjaśnił to bez używania jakichkolwiek akronimów i teraz wszystko ma sens (tldr; przepustowość ⟹ prostota):

To fascynująca dyskusja techniczna na temat trenowania dużych modeli językowych na dużą skalę.

Główna rozmowa

Jingyuan Liu wyraża zdziwienie odkryciem, że nie potrzebujesz pewnych skomplikowanych technik optymalizacji przy użyciu TPU (Tensor Processing Units - specjalizowane chipy AI Google'a) w porównaniu do GPU (Graphics Processing Units - typowo chipy NVIDIA).

Kluczowe pojęcia techniczne wyjaśnione:

Rodzaje sprzętu:

•GPU (Graphics Processing Unit): Początkowo zaprojektowane do grafiki, teraz intensywnie wykorzystywane w AI. NVIDIA dominuje na tym rynku.

•TPU (Tensor Processing Unit): Niestandardowe chipy zaprojektowane przez Google specjalnie do uczenia maszynowego.

Strategie równoległości:

Podczas trenowania ogromnych modeli AI, musisz podzielić pracę na wiele chipów. Istnieje kilka sposobów, aby to zrobić:

1. Równoległość danych (DP): Każdy chip przetwarza różne partie danych z tą samą kopią modelu.

2. Równoległość tensorowa (TP): Operacje matematyczne modelu są dzielone między chipy.

3. Równoległość potokowa (PP): Różne warstwy modelu są umieszczane na różnych chipach, tworząc potok.

Techniczne wyzwanie, które jest omawiane:

Problem strat pomocniczych: Podczas trenowania bardzo dużych modeli często dodajesz "straty pomocnicze" (dodatkowe cele treningowe) na warstwach pośrednich, aby pomóc gradientom lepiej przepływać przez sieć. W ramach ograniczeń PPVP (Pipeline Parallelism with Variable Partitioning) staje się to skomplikowane, ponieważ:

•Musisz wykonać "wszystko f wszystko b" (wszystkie przejścia do przodu, a następnie wszystkie przejścia do tyłu).

•To jest wyzwaniem dla szczytowego zużycia pamięci, ponieważ musisz przechowywać wyniki pośrednie.

Innowacja DeepSeek: Opracowali projekt "auxfree bias", który najwyraźniej unika potrzeby tych strat pomocniczych, jednocześnie skutecznie trenując.

Zaskakujące odkrycie:

Starszy ekspert powiedział Jingyuanowi, że przy TPU w skali K2 lub DSV3 (to są konfiguracje klastrów z setkami lub tysiącami chipów) można osiągnąć doskonałe MFU (Model FLOPs Utilization - zasadniczo jak efektywnie wykorzystujesz sprzęt) BEZ używania równoległości potokowej.

Dlaczego to jest zaskakujące?

•Równoległość potokowa jest zazwyczaj uważana za niezbędną do treningu na dużą skalę.

•To skomplikowana technika, która wymaga starannej optymalizacji.

•Możliwość jej uniknięcia znacznie upraszcza wszystko.

Wyjaśnienie Horace'a He:

Wyjaśnia, DLACZEGO to jest możliwe z TPU:

Zaleta przepustowości: TPU i wysokiej klasy klastry NVIDIA (takie jak NVL72 - najnowsza konfiguracja 72-GPU NVIDIA z interkonektami NVLink) mają tak wysoką przepustowość między chipami, że mogą obsługiwać wymagania komunikacyjne bez równoległości potokowej.

Kluczowy wgląd:

•Równoległość potokowa jest głównie potrzebna, gdy jesteś "ograniczony przez DP comms" (ograniczony przez to, jak szybko możesz komunikować się podczas treningu równoległego danych).

•Jeśli masz wystarczającą przepustowość w wystarczająco dużym obszarze (połączony klaster), możesz po prostu używać prostszych strategii równoległości.

•To działa "przez bardzo długi czas" - co oznacza, że możesz trenować nawet bardzo duże modele bez osiągania limitów.

Intuicja:

Pomyśl o tym jak o systemie autostrad:

•Tradycyjne klastry GPU są jak wąskie drogi między miastami, więc potrzebujesz skomplikowanego routingu (równoległość potokowa), aby uniknąć korków.

•Klastry TPU lub GPU połączone przez NVLink są jak ogromne autostrady - możesz po prostu wysłać wszystko bez skomplikowanego routingu.

To jest duża sprawa, ponieważ równoległość potokowa jest skomplikowana do wdrożenia, debugowania i optymalizacji. Możliwość jej uniknięcia, jednocześnie osiągając wysoką efektywność, sprawia, że cały proces treningowy jest znacznie prostszy i bardziej niezawodny.

Dyskusja podkreśla, jak postępy w technologii interkonektów sprzętowych ("drogi" między chipami) mogą zasadniczo zmienić strategie oprogramowania potrzebne do efektywnego treningu AI.

3,38K

Jestem trochę zaskoczony, że nikt jeszcze nie stworzył serwera MCP dla Dwarf Fortress, który mógłby pozwolić agentowi, takiemu jak Codex czy Claude Code, na efektywne kontrolowanie gry oraz monitorowanie stanu i postępów.

Sam nigdy w to nie grałem, tylko pobrałem to i krótko sprawdziłem około 10 lat temu, ale cieszyłem się, że mogłem o tym poczytać.

Wydaje się, że byłoby to bardzo dobre testowanie LLM, aby zobaczyć, jak długo mogłoby utrzymać krasnoludy przy życiu i w dobrej kondycji.

Ponieważ każda gra ostatecznie kończy się jakąś kaskadową katastrofą, która powoduje śmierć wszystkich krasnoludów, powinno być naturalne miejsce na zakończenie, co czyni to dobrym kandydatem na benchmark. Przynajmniej tak to rozumiem (motto graczy to „Przegrywanie jest zabawne”).

Dobrze wykonana praca w tej grze opierałaby się na dokładności wywoływania narzędzi i utrzymaniu spójności w długoterminowych zadaniach, a także na zdolności do monitorowania i rozumienia dynamiki złożonego systemu oraz dokonywania terminowych interwencji, które przewidują i przeciwdziałają problemom.

A ponieważ jest to natywne dla terminala, mogłoby być efektywnie przesyłane i przetwarzane za pomocą zwykłych tokenów, bez potrzeby przetwarzania obrazów w trybie multi-modalnym, co uczyniłoby to znacznie bardziej efektywnym niż inne gry.

Poza tym wiesz, że żadne laboratoria AI nie trenowały się na tym (jeszcze!), więc jest to nieskażone „benchmaxxingiem.”

3,81K

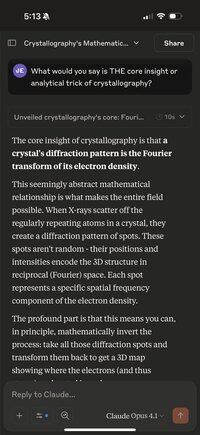

Ciekawą rzeczą, którą można zrobić, gdy trzeba poczekać kilka minut, jest użycie telefonu, aby zadać Claude Opus następujące pytanie dotyczące jakiejś losowej dziedziny lub dyscypliny:

"Co byś powiedział, że jest KLUCZOWYM wglądem lub analitycznym trikiem krystalografii?"

Zamień krystalografię na cokolwiek, co przyjdzie ci do głowy. Jak dotąd próbowałem:

QED; Model Standardowy; Biochemia; Prawdopodobieństwo; Teoria ewolucji; i wiele innych.

Jest coś w zmuszaniu modelu do zrobienia niemożliwego, do skondensowania ogromnej, złożonej dziedziny w "jeden dziwny trik", co sprawia, że naprawdę poszukuje najlepszego głębokiego, jednoczącego zasady w tej dziedzinie, a następnie artykułuje to zwięźle.

Zwykle jest to coś, co jest oczywiste dla praktyków, ale bardzo prawdopodobne, że nieznane dla większości ludzi, którzy mają tylko pobieżne zainteresowanie tematem.

Interesujące jest to, że można również wielokrotnie naciskać przycisk "spróbuj ponownie" z tym samym zapytaniem i czasami uzyskać bardzo różne, ale zazwyczaj bardzo fascynujące wyjaśnienia.

Już dużo się nauczyłem, robiąc to, i może to być najwyższy "poziom zrozumienia na minutę", z jakim się spotkałem w jakiejkolwiek samodzielnej nauce.

Ponieważ to nie są tylko ciekawe fakty czy fajne ciekawostki. To, z definicji, przenikliwe i jednoczące idee, które łączą ogromną ilość teorii i obserwowanych zjawisk na świecie.

Z pewnością jest to znacznie bardziej intensywne niż oglądanie kolejnego filmu wyjaśniającego na YouTube z animacjami i reklamami Brilliant/KiwiCo! Nie ma w tym nic złego.

7,91K

Pomysł, że nastąpił taki "exodus talentów" z OpenAI, że nie są już w stanie być liderem w tej dziedzinie, jest tak samo mylny i błędny jak pomysł, że GPT-5 "był dużą klapą, a model nie jest taki świetny i jest bardzo inkrementalny."

Nie tylko, że GPT-5 Pro jest teraz najinteligentniejszym modelem na świecie w większości trudnych zadań z rzeczywistego świata (szczególnie w zadaniach kodowania, które mają teraz największe znaczenie ekonomiczne), ale nowe narzędzie codex cli od OpenAI jest niesamowicie dobrze wykonane.

Przeszli z odległego 3. miejsca w narzędziach kodowania cli do posiadania tego, co można uznać za najlepsze narzędzie w tej chwili (zauważ, że nadal lubię i używam Claude Code, to nie jest albo/albo!), z zdecydowanie najlepszą wydajnością, najniższym opóźnieniem itd., ponieważ jest zaprogramowane w rust.

A teraz to narzędzie cli jest połączone z najlepszym modelem kodowania, który ma najlepszą niezawodność w wywoływaniu narzędzi i najlepszą spójność w długoterminowych zadaniach, z najmniejszą ilością halucynacji.

I nie trzeba mówić, że ich aplikacja na iOS jest również dramatycznie lepsza niż wszystkie inne aplikacje AI pod względem wykończenia i funkcji. Aplikacja Claude to po prostu aplikacja webowa w piaskownicy Safari! A ich aplikacja webowa nadal jest najlepsza. Rzeczy takie jak wyszukiwanie działają po prostu lepiej niż w innych aplikacjach. Podstawowe blokowanie i tackling.

Więc tak. Niektórzy bardzo inteligentni ludzie, tacy jak Ilya i John Schulman, odeszli do innych firm. Ale wciąż mają absolutnie wspaniały zespół techniczny z niesamowicie dobrymi ludźmi od produktów i świetnymi umiejętnościami inżynieryjnymi.

Nie pozwól, aby twoja niechęć do Altmana zaślepiła cię na oczywiste. Kiedy widzę kolejnego człowieka, który mówi, jak zły jest GPT-5, czuję się zażenowany, ponieważ ta osoba pokazuje, że nie potrafi myśleć samodzielnie na podstawie dowodów i rozumu, i została zmanipulowana do myślenia, że opinia (i wygłaszanie jej w internecie) sprawia, że brzmią mądrze.

34,03K

Jako aktualizację do moich dwóch ostatnich wątków dotyczących używania GPT-5 Pro do rozpoczęcia procesu odkrywania przełomowych teorii, które łączą nowatorskie zastosowania zaawansowanej matematyki w przypadkach użycia AI, poprosiłem model o stworzenie demonstracyjnych implementacji w Pythonie z użyciem Jax i Numpy dla każdego z 11 pomysłów.

Następnie połączyłem je w projekt i dodałem ładne CLI do ich uruchamiania oraz szereg testów end-to-end, które mierzyły, czy kod jest matematycznie poprawny, sprawdzają, czy kod ma pożądane właściwości matematyczne, a na koniec, czy robi coś użytecznego w porównaniu do obecnych standardowych podejść.

Użyłem codex CLI z GPT-5, aby zintegrować wszystko i naprawić błędy. Podam link do repozytorium, które zawiera szczegółową dokumentację całego projektu oraz opisy dla każdego z 11 demonstracji, które zawierają wszystkie wyniki wygenerowane przez model podczas tego procesu.

3,8K

Wow, w końcu zabrałem się za wypróbowanie nowej wersji CLI codex OpenAI (ich odpowiedzi na Claude Code).

Ostatnim razem, gdy próbowałem używać codex (zauważ, że to różni się od ich hostowanego agenta kodującego, który również nazywa się codex, co jest niezwykle mylące; mówię teraz o narzędziu, które uruchamiasz lokalnie na swoim komputerze w terminalu), było to napisane jako aplikacja Nodejs/Typescript i naprawdę było do niczego:

- mogłem uzyskać dostęp tylko do słabszych modeli, takich jak o4-mini lub ich wariant dla codex, myląco również nazywany codex (serio?)

- znacznie gorszy interfejs użytkownika/UX niż Claude Code

- znacznie gorsze w kodowaniu w wyniku gorszego modelu, gorszych narzędzi, gorszego przepływu agenta.

- irytująco zmuszało cię do udzielania zgody na wszystko, więc musiałeś cały czas nad tym czuwać, co czyniło to znacznie mniej użytecznym, ponieważ nie mogłeś łatwo uruchomić ich wielu równolegle.

- może to było dobre, ponieważ zdecydowanie największym problemem było to, że robiło super lekkomyślne, destrukcyjne rzeczy; było znacznie bardziej beztroskie niż CC.

To ostatecznie dlatego natychmiast przestałem go używać, ponieważ postanowiło zrobić „git reset --hard HEAD” bez wcześniejszego stashowania, i straciłem część pracy. Nigdy więcej, pomyślałem.

Cóż, w końcu zabrałem się za wypróbowanie całkowicie nowej wersji rust, która używa GPT-5 i która może korzystać z twojej istniejącej subskrypcji GPT Pro zamiast klucza API, i to jest tak dużo lepsze, że aż szokujące.

Przede wszystkim nie ma po prostu substytutu dla szybkiego skompilowanego kodu, gdy chodzi o interaktywne narzędzia takie jak to.

Fakt, że jest napisane w rust, oznacza, że nie ma żadnego opóźnienia związanego z wprowadzaniem z klawiatury, a także żadnych dziwnych artefaktów, jak w CC, gdzie backspace nie działa poprawnie, a wprowadzanie jest zacinające i opóźnione, ponieważ jest napisane w języku interpretowanym, który jest sto razy wolniejszy w takich sprawach.

Radzenie sobie z ciągłym opóźnieniem i zacinaniem nie tylko spowalnia, ale także psychicznie, a może nawet emocjonalnie, jest męczące i wyczerpujące, przynajmniej dla mnie, gdy używam tych rzeczy przez długie godziny. To okropne uczucie nienawidzić i czuć urazę do swoich narzędzi, nawet gdy polegasz na nich, aby wykonać swoją pracę.

Naprawdę mam nadzieję, że to podniesie poprzeczkę dla wszystkich tych narzędzi i przekona Anthropic, Google i innych do również używania rust (lub C++, Zig, cokolwiek).

Ale naprawdę dużą poprawą jest oczywiście model; z gorszym modelem, który jest zawodny w wywoływaniu narzędzi i który traci spójność w dłuższych zadaniach, żadne z tej rustowej zwinności nie byłoby warte nic.

Ale jeśli mnie śledzisz tutaj, to wiesz, że od około 15 minut po jego wydaniu byłem pod wrażeniem zdolności kodowania i umiejętności wywoływania narzędzi GPT-5 Thinking, chociaż używałem go głównie z poziomu zakładki agenta Cursor.

Podsumowując, ten nowy rust codex nagle stał się naprawdę groźnym konkurentem dla CC, i zdecydowanie powinieneś go wypróbować.

Muszę zobaczyć, ile użytkowania pozwolą mi mieć na mojej subskrypcji GPT Pro za 200 dolarów miesięcznie, ale jeśli będę musiał zdobyć kilka więcej, to będzie to warte swojej ceny.

Zauważ, że nie przestałem używać CC. Lubię używać ich obu razem. I uwierz lub nie, nadal używam również Cursor.

Ludzie powinni przestać szukać jednego narzędzia, które zastąpi wszystkie inne, i zaakceptować, że różne narzędzia mają różne mocne i słabe strony, a najlepsze wyniki osiąga się, ucząc się tego intuicyjnie z ciągłego użytkowania.

W każdym razie, zrób sobie przysługę i zdobądź to teraz. Najłatwiejszym sposobem jest wykonanie tego polecenia (zauważ, że to uzyska wersję rust, mimo że używanie bun/npm do tego jest mylące):

bun i -g @openai/codex

8,57K

Wow, w końcu zabrałem się za wypróbowanie nowej wersji CLI codex OpenAI (ich odpowiedzi na Claude Code).

Ostatnim razem, gdy próbowałem używać codex (zauważ, że to różni się od ich hostowanego agenta kodującego, który również nazywa się codex, co jest niezwykle mylące; mówię teraz o narzędziu, które uruchamiasz lokalnie na swoim komputerze w terminalu), było to napisane jako aplikacja Nodejs/Typescript i naprawdę było do niczego:

- mogłem uzyskać dostęp tylko do słabszych modeli, takich jak o4-mini lub ich wariant dla codex, myląco również nazywany codex (serio?)

- znacznie gorszy interfejs użytkownika/UX niż Claude Code

- znacznie gorsze w kodowaniu w wyniku gorszego modelu, gorszych narzędzi, gorszego przepływu agenta.

- irytująco zmuszało cię do udzielania zgody na wszystko, więc musiałeś cały czas nad tym czuwać, co czyniło to znacznie mniej użytecznym, ponieważ nie mogłeś łatwo uruchomić ich wielu równolegle.

- może to było dobre, ponieważ zdecydowanie największym problemem było to, że robiło super lekkomyślne, destrukcyjne rzeczy; było znacznie bardziej beztroskie niż CC. To ostatecznie sprawiło, że natychmiast przestałem go używać, ponieważ postanowiło zrobić "reset --hard HEAD" bez wcześniejszego stashowania, i straciłem część pracy. Nigdy więcej, pomyślałem.

Cóż, w końcu zabrałem się za wypróbowanie zupełnie nowej wersji rust, która używa GPT-5 i która może korzystać z twojej istniejącej subskrypcji GPT Pro zamiast klucza API, i to jest tak dużo lepsze, że aż szokuje.

Przede wszystkim nie ma po prostu substytutu dla szybkiego skompilowanego kodu, gdy chodzi o interaktywne narzędzia takie jak to.

Fakt, że jest napisane w rust, oznacza, że nie ma żadnego opóźnienia związanego z wprowadzaniem z klawiatury, a także żadnych dziwnych artefaktów, jak w CC, gdzie backspace nie działa poprawnie, a wprowadzanie jest zacinające się i opóźnione, ponieważ jest napisane w języku interpretowanym, który jest sto razy wolniejszy w takich sprawach.

Radzenie sobie z ciągłym opóźnieniem i zacinaniem się nie tylko spowalnia, ale także psychicznie, a może nawet emocjonalnie obciąża i męczy, przynajmniej dla mnie, gdy używam tych rzeczy przez wiele godzin. To okropne uczucie nienawidzić i czuć urazę do swoich narzędzi, nawet gdy polegasz na nich, aby wykonać swoją pracę.

Naprawdę mam nadzieję, że to podniesie poprzeczkę dla wszystkich tych narzędzi i przekona Anthropic, Google i innych do również używania rust (lub C++, Zig, cokolwiek).

Ale naprawdę dużą poprawą jest oczywiście model; z gorszym modelem, który jest zawodny w wywoływaniu narzędzi i który traci spójność w dłuższych zadaniach, żadne z tej rześkości Rust nie byłoby warte nic.

Ale jeśli śledzisz mnie tutaj, to wiesz, że od około 15 minut po jego wydaniu byłem pod wrażeniem zdolności kodowania i umiejętności wywoływania narzędzi GPT-5 Thinking, chociaż używałem go głównie z poziomu zakładki agenta Cursor.

Podsumowując, ten nowy rust codex nagle stał się naprawdę groźnym konkurentem dla CC, i zdecydowanie powinieneś go wypróbować.

Muszę zobaczyć, ile użycia pozwolą mi uzyskać na mojej subskrypcji GPT Pro za 200 dolarów miesięcznie, ale jeśli będę musiał zdobyć kilka więcej, to będzie to warte swojej ceny.

Zauważ, że nie przestałem używać CC. Lubię używać ich obu razem. I uwierz lub nie, nadal używam również Cursor.

Ludzie powinni przestać szukać jednego narzędzia, które zastąpi wszystkie inne, i zaakceptować, że różne narzędzia mają różne mocne i słabe strony, a najlepsze wyniki uzyskuje się, ucząc się tego intuicyjnie z ciągłego użycia.

W każdym razie, zrób sobie przysługę i zdobądź to teraz. Najłatwiejszy sposób to wykonać to polecenie (zauważ, że to zdobędzie wersję rust, mimo że użycie bun/npm jest mylące):

bun i -g @openai/codex

686

Jestem absolutnie przekonany, że najinteligentniejsze modele AI, które są teraz dostępne, GPT-5 Pro i Grok4 Heavy, są już wystarczająco mądre i z pewnością wystarczająco obeznane z matematyką i AI, aby wymyślić i opracować ważne odkrycia teoretyczne i praktyczne, pod warunkiem, że otrzymają odpowiednie, sprytne wskazówki.

47,97K

Najlepsze

Ranking

Ulubione

Trendy onchain

Trendy na X

Niedawne największe finansowanie

Najbardziej godne uwagi